PH热榜 | 2026-01-27

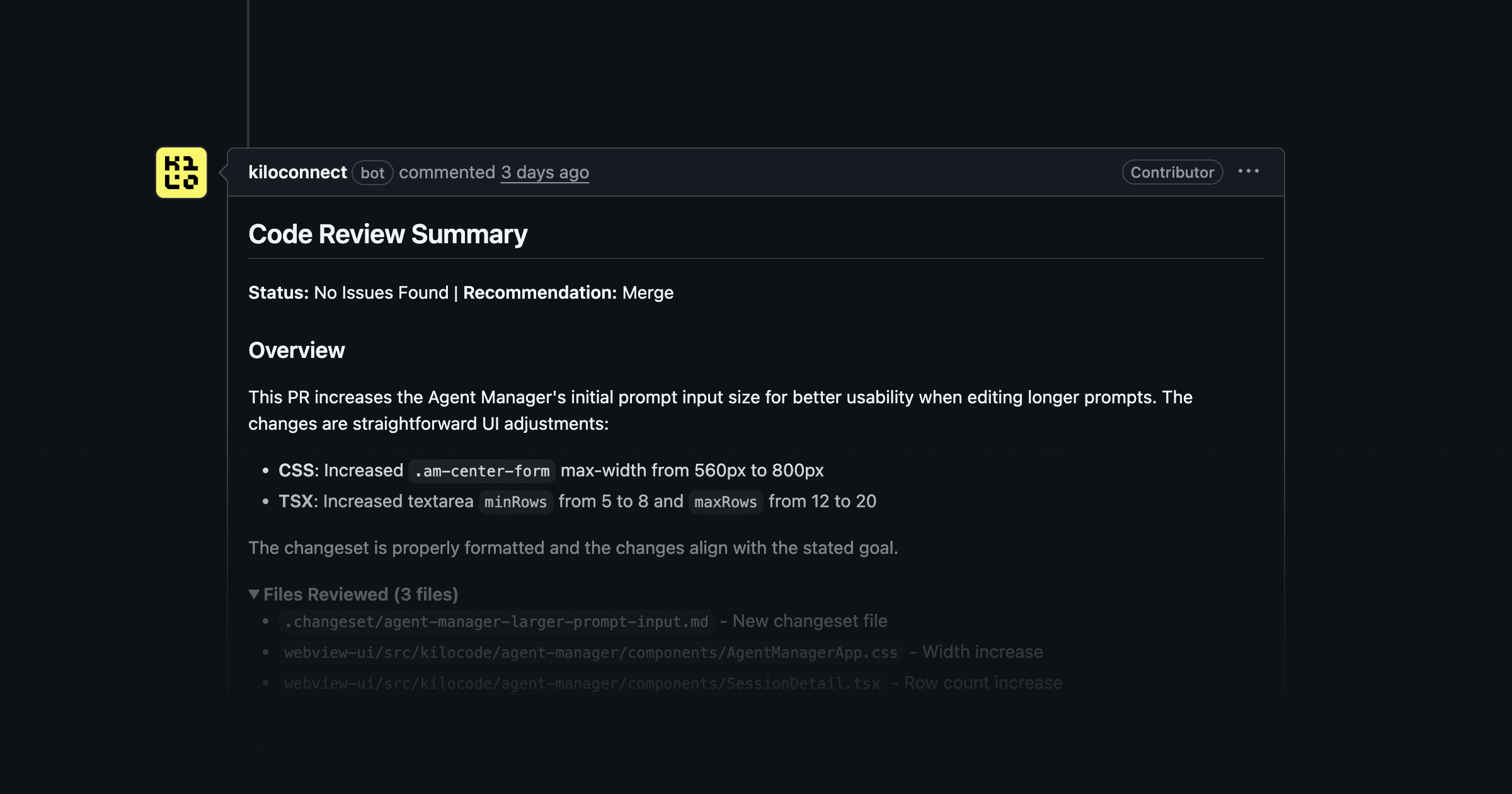

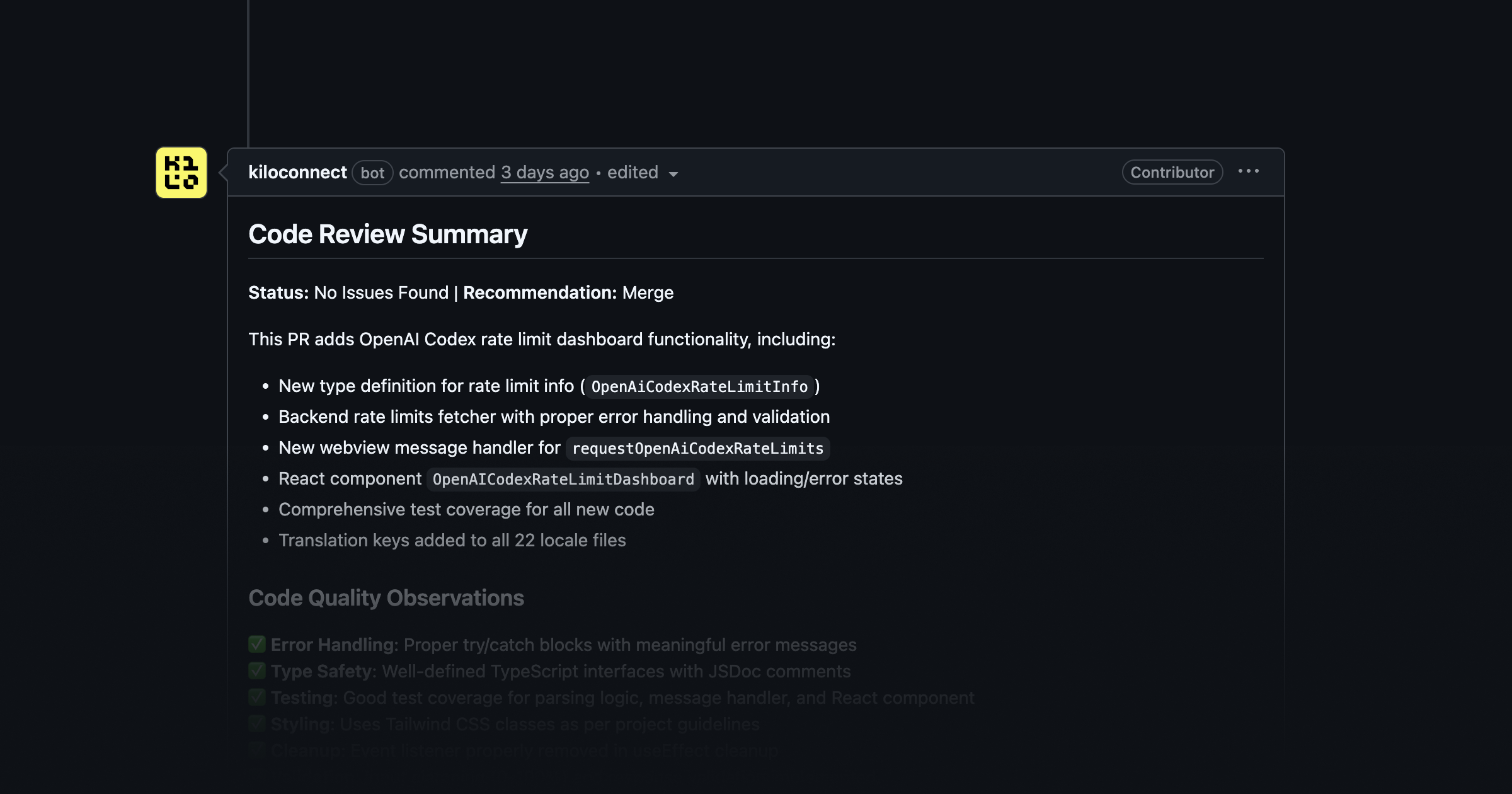

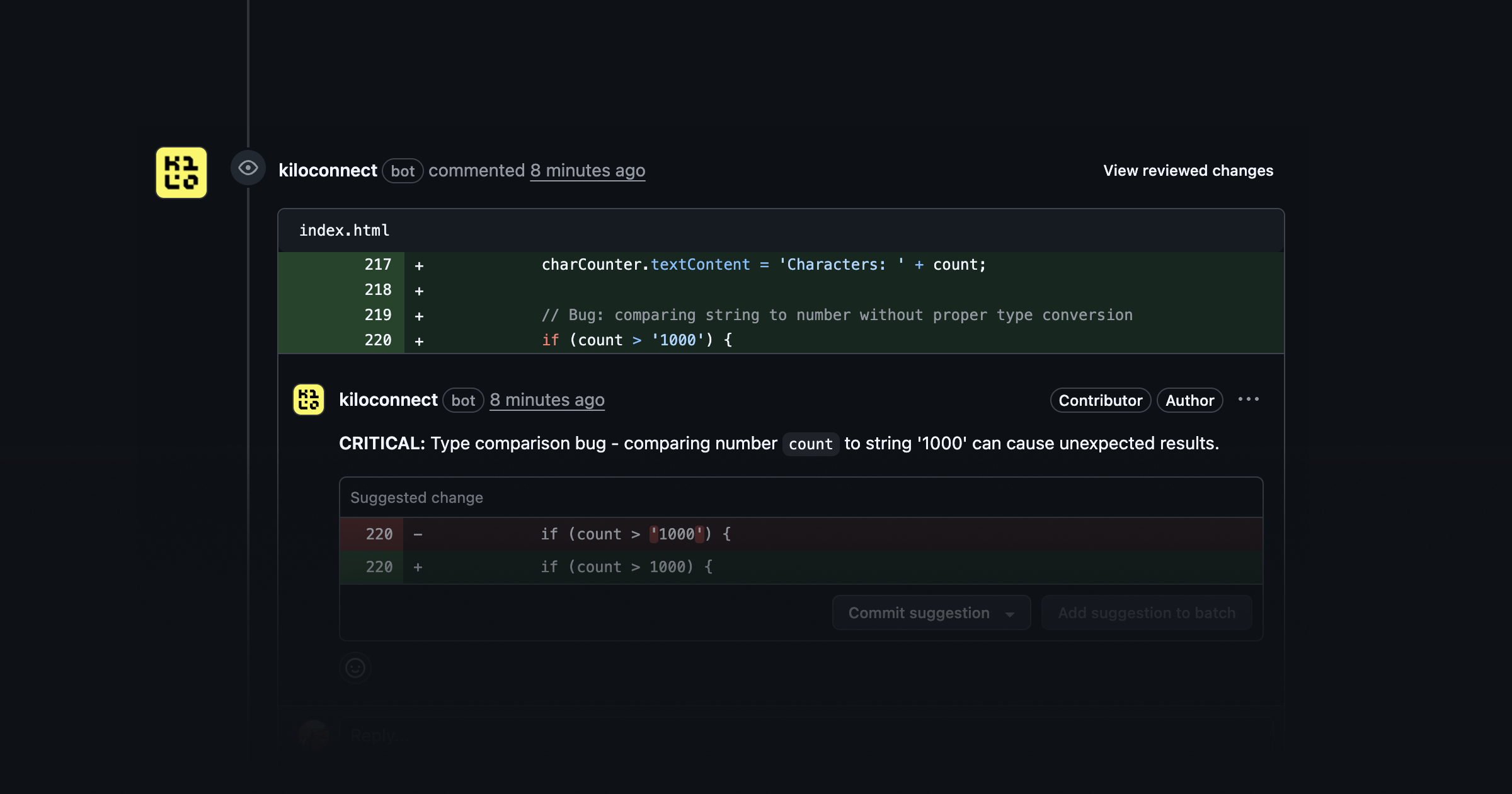

一句话介绍:一款AI驱动的自动化代码审查工具,在开发者提交拉取请求(PR)时即时运行,通过分析代码、提出改进建议、捕捉漏洞来缓解PR积压瓶颈,提升代码质量和团队效率。

Open Source

Software Engineering

Developer Tools

GitHub

AI代码审查

自动化开发工具

开发者生产力

PR流程优化

多模型支持

开源项目

代码质量管控

即时反馈

用户评论摘要:用户普遍认可其缓解PR瓶颈、提供即时反馈的价值,尤其对新手友好。关注点集中在与现有工作流的整合、对大型/遗留代码库的处理效果、防止“机器人垃圾评论”的配置,以及是否会导致开发者过度依赖AI而削弱深度审查能力。

AI 锐评

Kilo Code Reviewer 瞄准了一个精准且日益增长的痛点:人工代码审查作为开发流程的关键瓶颈。其核心价值并非“替代人类”,而在于充当一个不知疲倦的“第一道过滤器”。通过集成500+模型并支持本地与云端审查,它在灵活性与成本控制上展现了优势,特别是提供免费模型选项,降低了尝鲜门槛。

然而,产品的成功不取决于技术堆砌,而在于能否“优雅地嵌入”现有工作流。评论中关于“防止机器人垃圾评论”和“配置审查严格度”的提问直指核心风险:糟糕的AI审查会产生噪音,反而成为新负担。团队对此已有预案,如提供自定义指令和焦点区域调整,但这恰恰是落地时最需精细调校的部分。

更深层的挑战在于其宣称的“理解代码库”。对于复杂模块化项目和遗留系统,AI能否保持高准确率仍需观察。虽然团队建议针对不同代码区域切换专用模型,但这无疑提高了使用者的认知负荷和配置成本。此外,它将代码审查从“人际协作环节”部分转变为“人机交互环节”,可能削弱团队通过代码评审进行知识传递的隐性价值。长远看,它或许会重塑代码审查的角色——人类工程师将更聚焦于架构设计与业务逻辑等高阶判断,而将风格、常见漏洞和基础优化委托给AI。这不仅是效率工具,更是开发范式的潜在变革者。其真正的考验在于,能否在提升即时效率的同时,不损害代码的长期可维护性与团队的技术凝聚力。

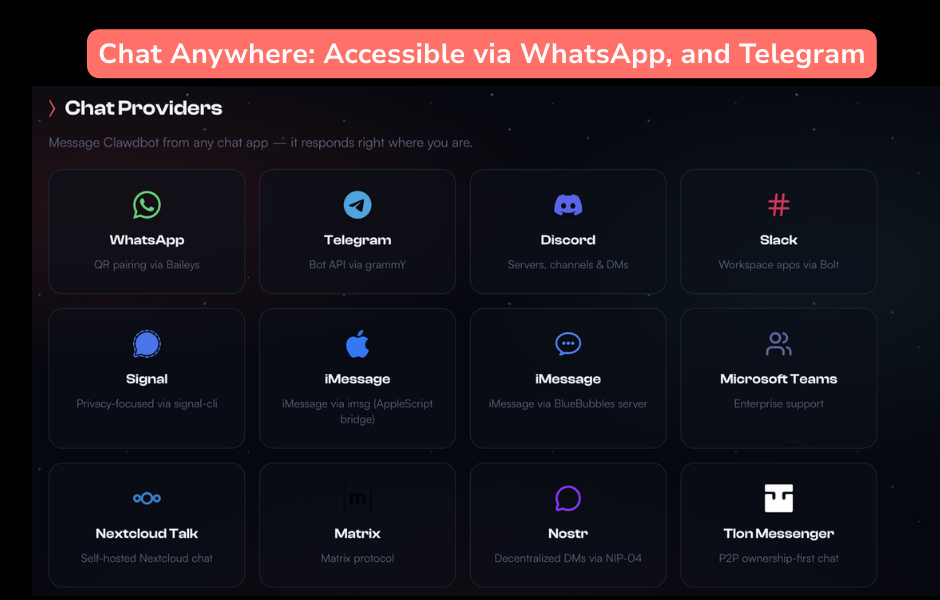

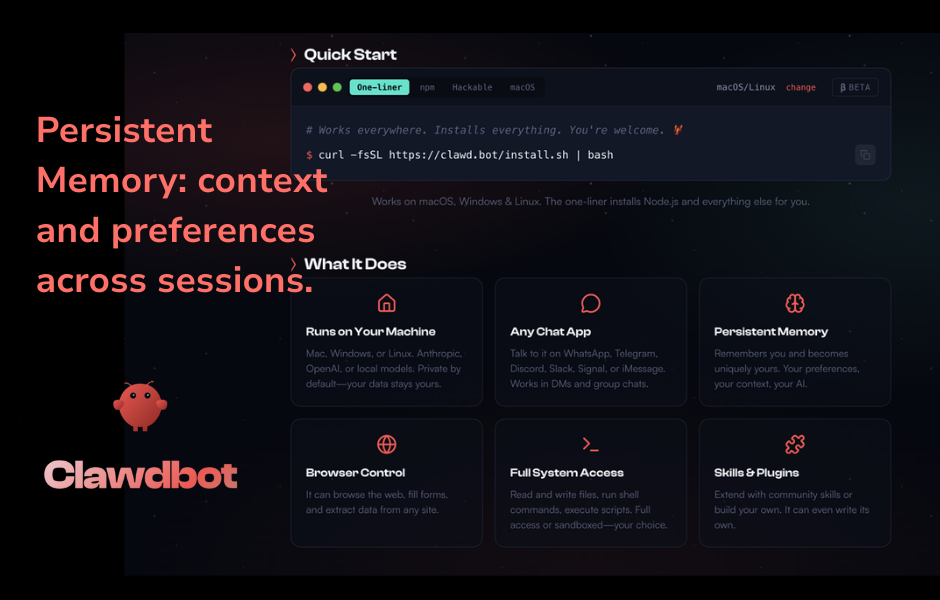

一句话介绍:Moltbot是一款部署在本地的AI个人代理,可通过WhatsApp等聊天应用远程控制电脑,执行浏览器操作、运行终端命令、管理文件等实际任务,解决了传统AI助手只能生成文本而无法在操作系统中执行具体操作的痛点。

Open Source

Developer Tools

Artificial Intelligence

GitHub

本地AI代理

自动化工作流

远程控制

隐私安全

聊天机器人

系统集成

开源平台

生产力工具

个人助理

跨平台

用户评论摘要:用户普遍认可其“本地执行、聊天交互”的核心价值,认为它代表了AI助手的新方向。主要反馈集中在安全担忧(如公开实例被攻击、权限控制)、与竞品对比的实用性,以及对默认安全机制、操作审计和撤销功能的具体建议。

AI 锐评

Moltbot所标榜的“真正能做事的AI”,直击了当前AI助手生态的核心软肋:智力与行动力之间的断层。它将大语言模型的意图理解与操作系统的底层能力桥接起来,从“浏览器的囚徒”进化为“系统的延伸”,这是一个质变。

其真正的颠覆性在于两点:一是以“本地优先”重新划分了信任边界,在数据隐私成为普遍焦虑的当下,提供了极具说服力的解决方案;二是以“聊天应用即前端”重构了交互范式,将高频通讯工具转化为自然的指令入口,符合无缝工作流的趋势。这使其不再是又一个Co-pilot式的副驾驶,而是一个可独当一面的数字管家。

然而,赋予AI“行动权”的同时也打开了潘多拉魔盒。评论中密集的安全性质疑——从权限粗放、缺乏审计到公开实例遭攻击——暴露了产品从“酷炫概念”迈向“可靠基础设施”的关键挑战。安全与效能的永恒博弈在此尤为尖锐:过于严格的沙箱会阉割其核心价值,而过于宽松的授权则可能酿成灾难。产品能否成功,不取决于其功能列表的丰富度,而取决于能否在架构层面设计出一套精妙、透明且用户可理解的安全模型(如能力白名单、意图验证)。这不仅是技术问题,更是产品哲学问题。

此外,其开源与可扩展性是一把双刃剑。它有望吸引开发者构建生态,形成护城河,但也可能因技能质量参差不齐和安全标准不一而稀释核心体验。本质上,Moltbot的野心是成为下一代人机交互的底层操作系统雏形,但这条路注定需要先以最谨慎的姿态,处理好“第一个毁灭性错误”。

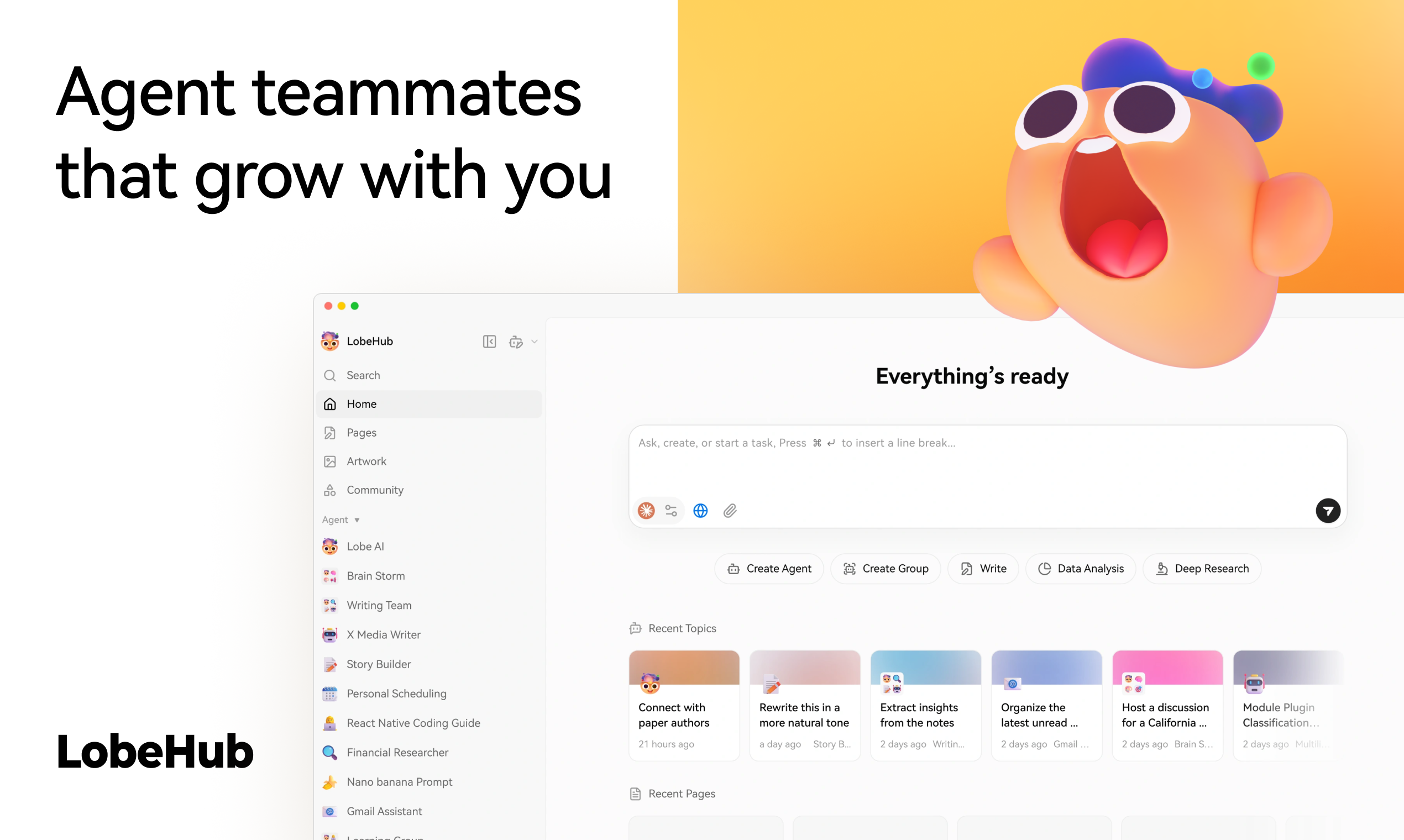

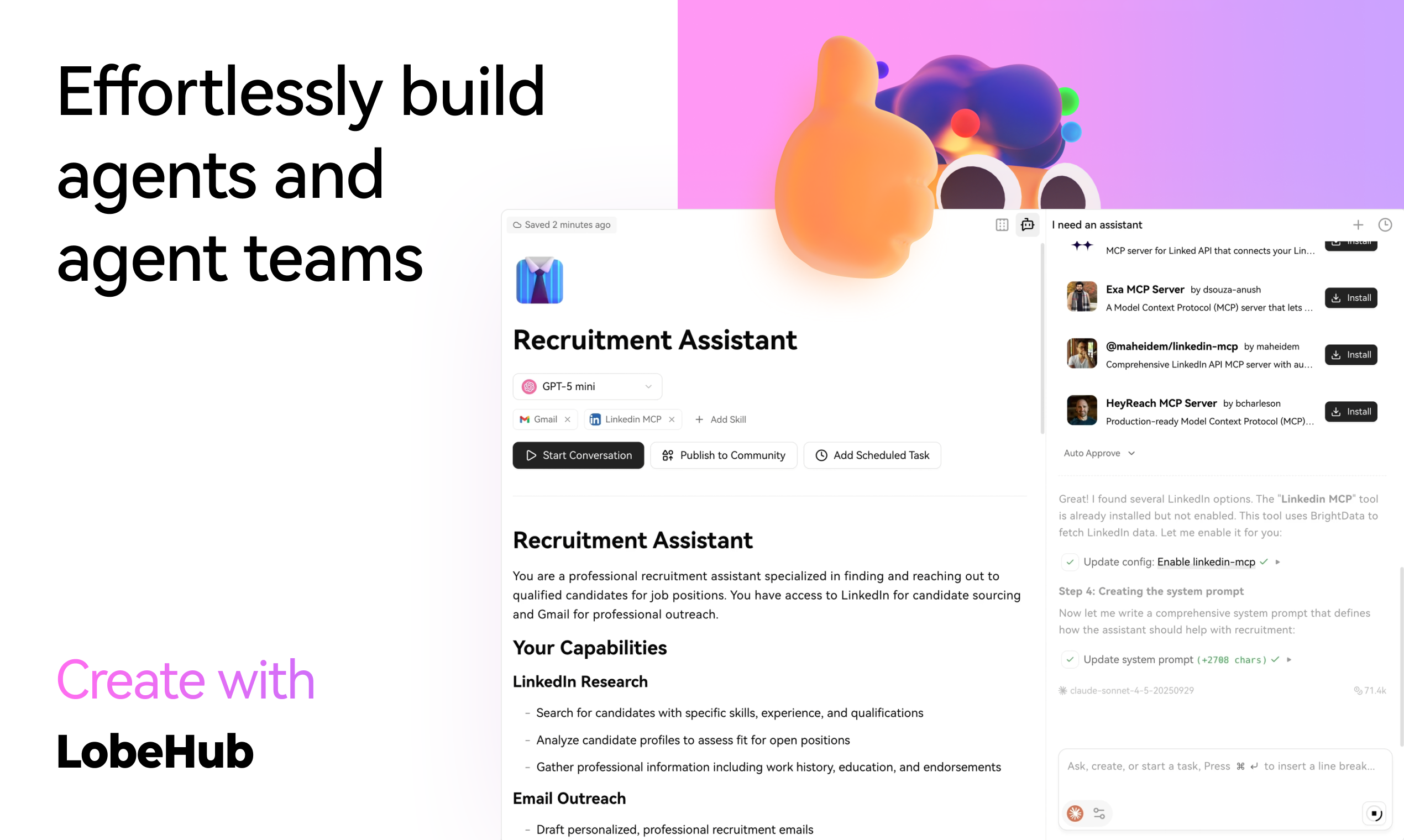

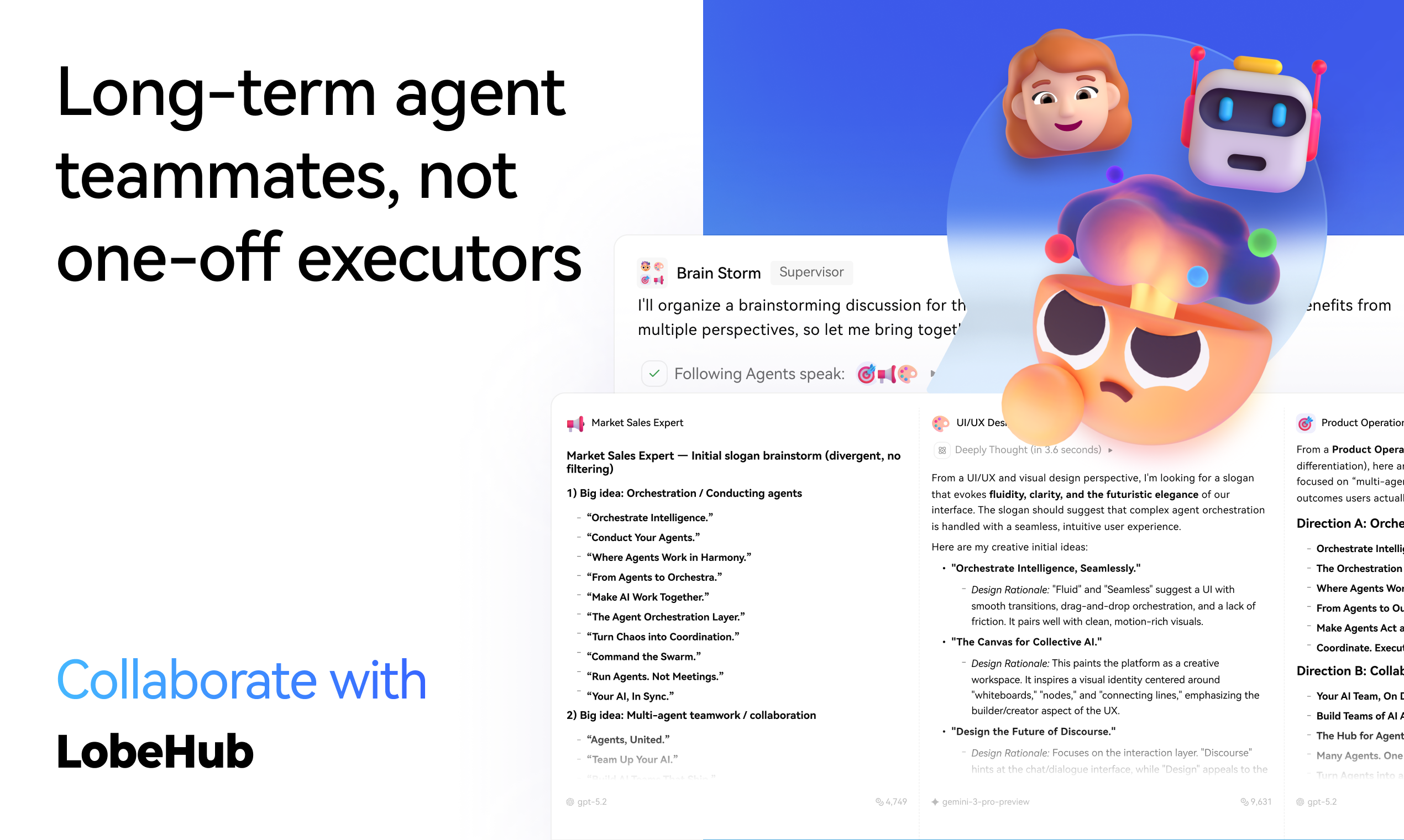

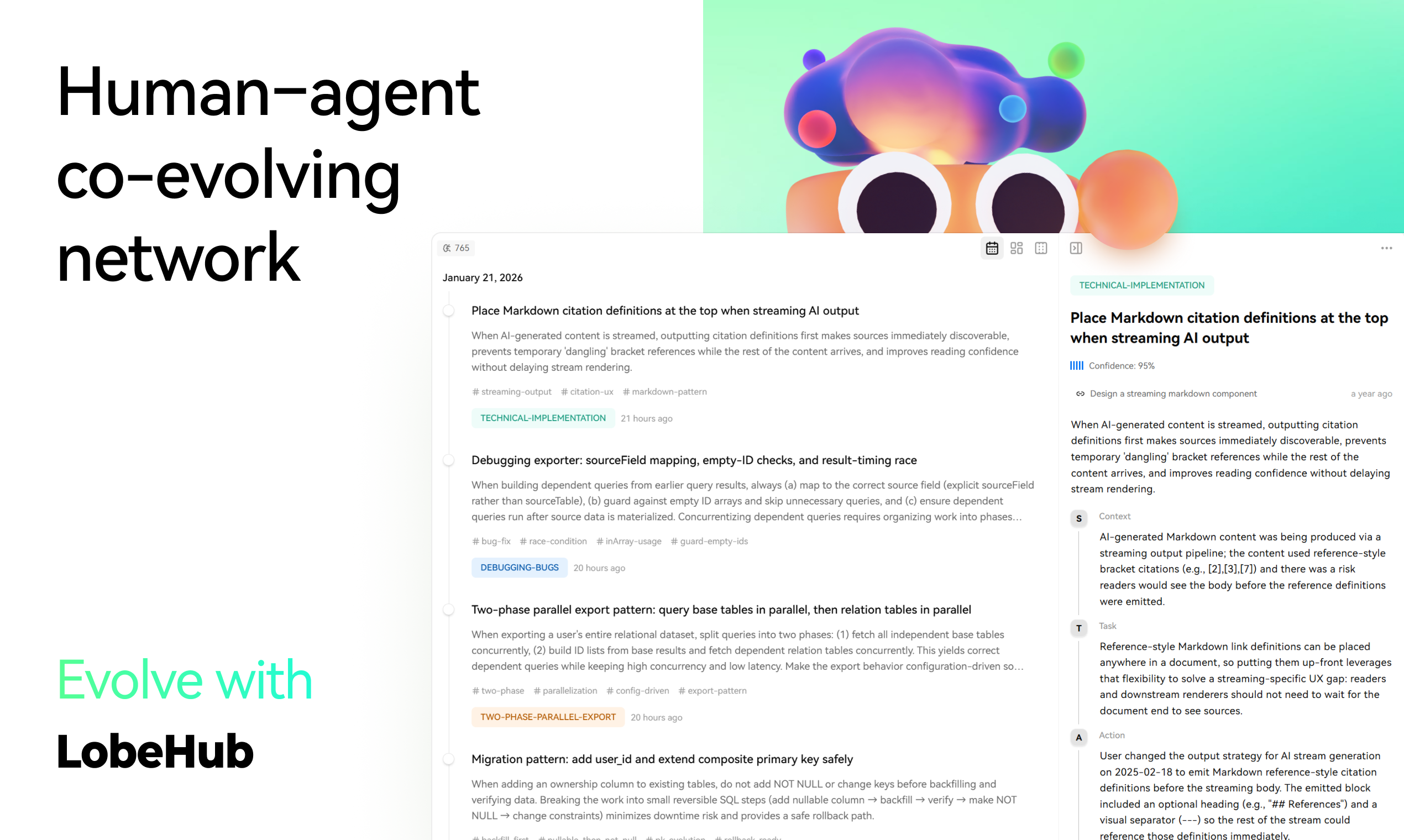

一句话介绍:LobeHub是一个AI智能体协作平台,它通过创建具备长期记忆、可协同工作的“智能体队友”,在复杂项目管理和个人工作流中,解决了传统一次性AI工具孤立、低效、成本高且难以构建的痛点。

Productivity

GitHub

Maker Tools

Marketing automation

AI智能体平台

多模型编排

长期记忆

人机协同

工作流自动化

开源

团队协作

智能体基础设施

认知减负

用户评论摘要:用户普遍认可其“智能体即队友”的长期协作理念及多模型编排能力。有效反馈集中在:询问产品主页与注册引导不清晰;探讨智能体记忆如何保持更新、避免偏见的具体机制;赞赏其内联编辑、异步协作对工作流的提升;并认为其定位是更有潜力的“基础设施”,而非另一个聊天应用。

AI 锐评

LobeHub的野心,远不止于制造另一个AI聊天机器人或任务自动化工具。它剑指当前AI应用生态的核心缺陷:智能体的“短视”与“孤立”。产品将智能体重新定义为具备“白盒化”长期记忆、可进化的协作单元,这试图将AI从执行单次任务的“耗材”,转变为参与完整工作流的“同事”。

其真正价值在于两个维度的“整合”。一是横向的工作流整合,允许用户在工作场景中随时唤起智能体团队,从构思、执行到交付进行闭环协作,这挑战了以“对话窗口”为中心的割裂式交互。二是纵向的认知整合,其可编辑的记忆系统旨在让人与AI共同进化,目标是降低认知负荷,而非单纯提高输出量。这回应了高级用户对AI“失忆”和“缺乏上下文”的深层焦虑。

然而,其宣称的“民主化”愿景面临严峻考验。将复杂的智能体编排与记忆管理交给“日常用户”,可能带来极高的学习成本和不可控的认知开销。透明化记忆是一把双刃剑,在赋予用户控制权的同时,也可能将管理记忆的负担转嫁给用户。此外,其发展高度依赖社区共享的“智能体团队”能否形成活跃生态,这存在网络效应冷启动的典型挑战。

LobeHub的赛道正变得拥挤(如提及的Claude等)。它的突围筹码是其开源背景带来的开发者信任、以及从LobeChat继承的多模型编排技术栈。它能否从极客和早期采用者的玩具,成长为稳定可靠的生产力“基础设施”,将取决于其如何在“功能强大”与“体验简单”之间找到精妙的平衡,并证明“长期智能体队友”带来的复利,足以抵消其更高的使用与维护成本。

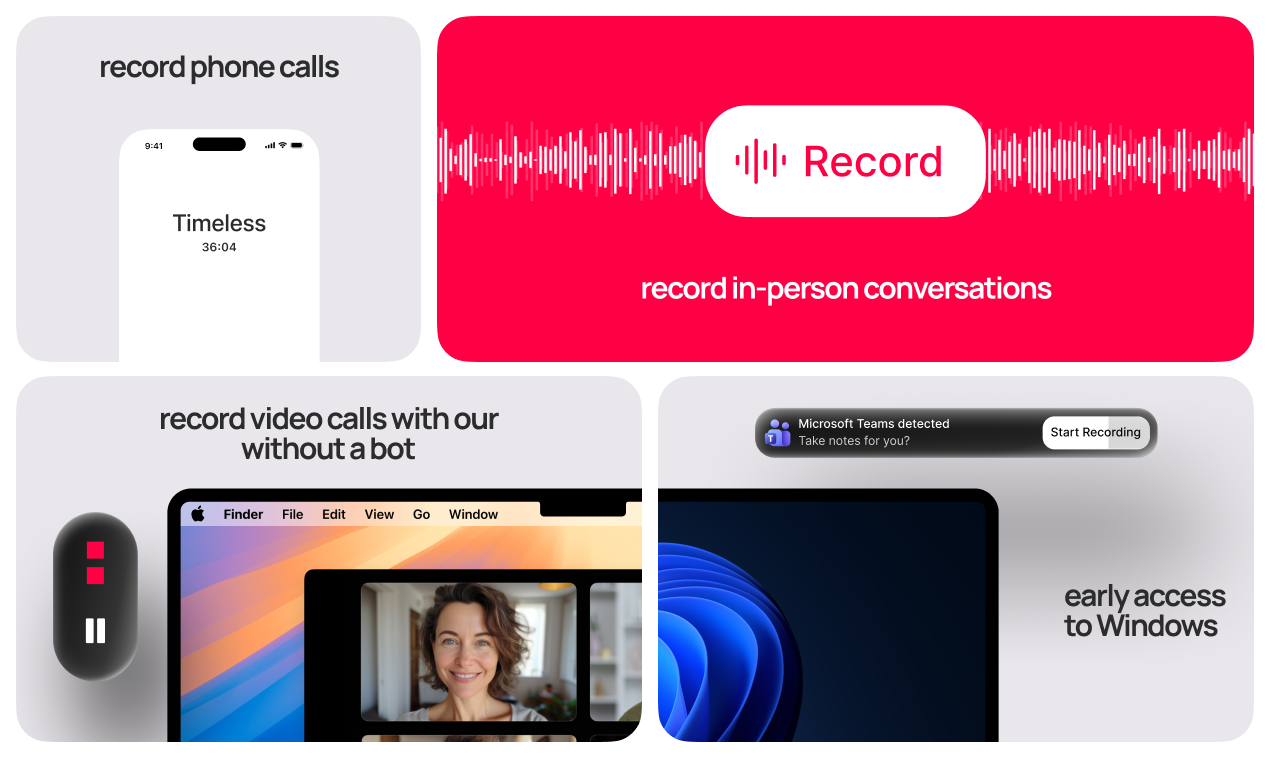

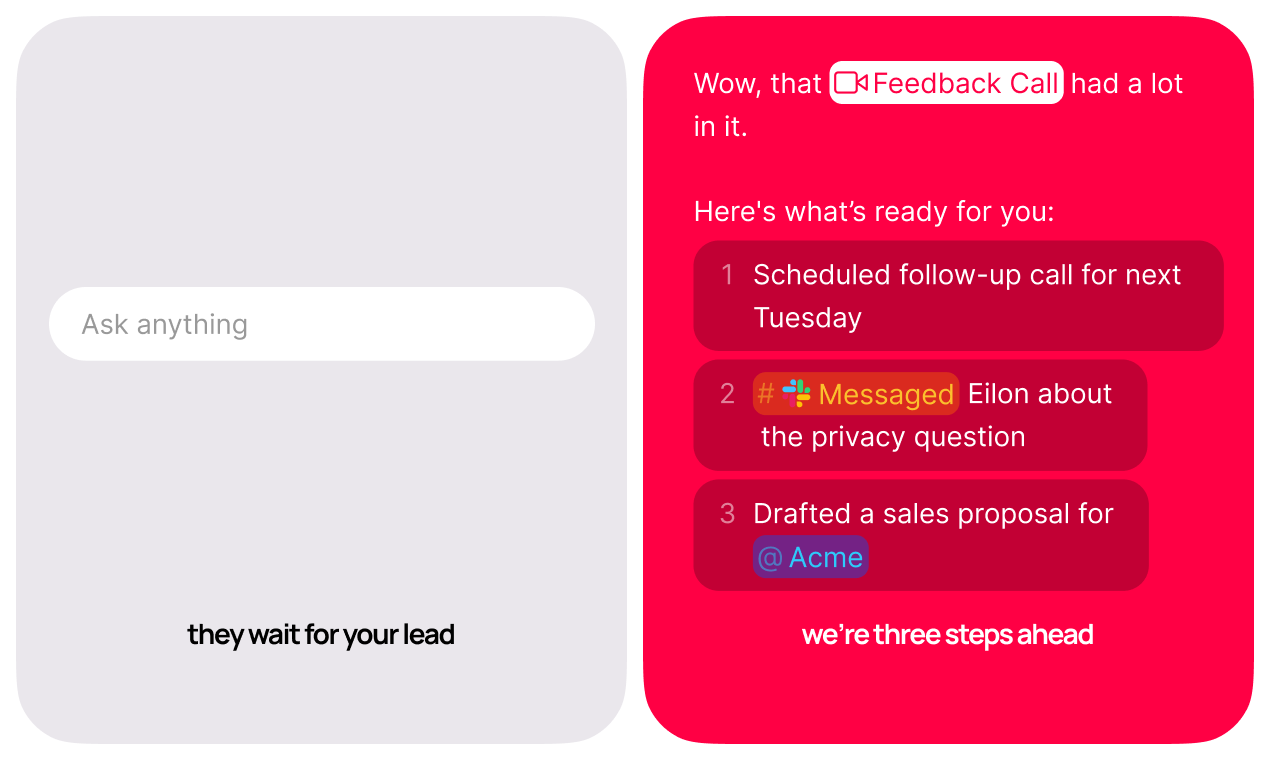

一句话介绍:Timeless 是一款AI智能体平台,它能自动识别会议、通话等各类对话中的意图,并直接创建任务、起草文档、安排跟进会议,解决了会后执行断层、效率低下的核心痛点。

Meetings

Artificial Intelligence

AI智能体

自动化执行

会议效率

工作流自动化

对话智能

生产力工具

智能助理

任务管理

知识管理

跨平台协作

用户评论摘要:用户普遍赞赏其“行动者”而非“记录者”的定位,认为能真正推动工作进展。主要问题集中于:1. 在复杂、模糊或玩笑式对话中,如何保证理解和执行的精确性?2. 如何跨平台、跨非正式对话维持上下文连贯?3. 如何与现有工具(如Slack、日历、网盘)深度集成以降低使用门槛?

AI 锐评

Timeless 的野心不在于做另一个优秀的笔记工具,而在于成为工作流的“末梢神经”与“执行引擎”。其宣称的价值并非更好的记录,而是让“说过即做过”成为可能。这直指现代协作中最隐秘的损耗:从意图到行动的转化成本。

产品的真正创新点在于其“被动触发”模式——无需主动操作,AI在后台持续监听对话(线上/线下),将自然语言直接解析为可执行指令。这试图将人类从繁琐的“自我任务管理”中解放,把对话本身变成最自然的交互界面。然而,这也正是其最大的风险与挑战所在。

首先,是精确性与“过度自动化”的悖论。评论中多次提及的“模糊、玩笑语境”问题,本质是AI对人类复杂沟通中大量隐含上下文、社交线索和意图不确定性的理解鸿沟。误判不仅会产生垃圾任务,更可能引发严重的协作信任危机。其次,是数据与系统的“连接器”难题。其价值高度依赖于与现有工具链(日历、网盘、CRM、任务系统)的无缝集成能力,这涉及复杂的API工程与权限问题,也是用户切换成本的核心。最后,是其商业模式的潜在隐忧:一个持续监听所有对话(包括线下)的平台,将数据安全与隐私合规置于何等优先级?这需要极致的透明度和控制权设计。

如果Timeless能攻克精确性、系统集成与隐私安全这三座大山,它有望从“智能笔记”的红海中开辟出一个新品类——“对话驱动自动化”。其真正的对手或许不是Fathom等笔记工具,而是未来所有试图将自然语言转化为行动的AI原生操作系统。目前,它展示了一个诱人的愿景,但通往“可靠的工作副驾驶”之路,仍布满需要极致工程与伦理思考的荆棘。

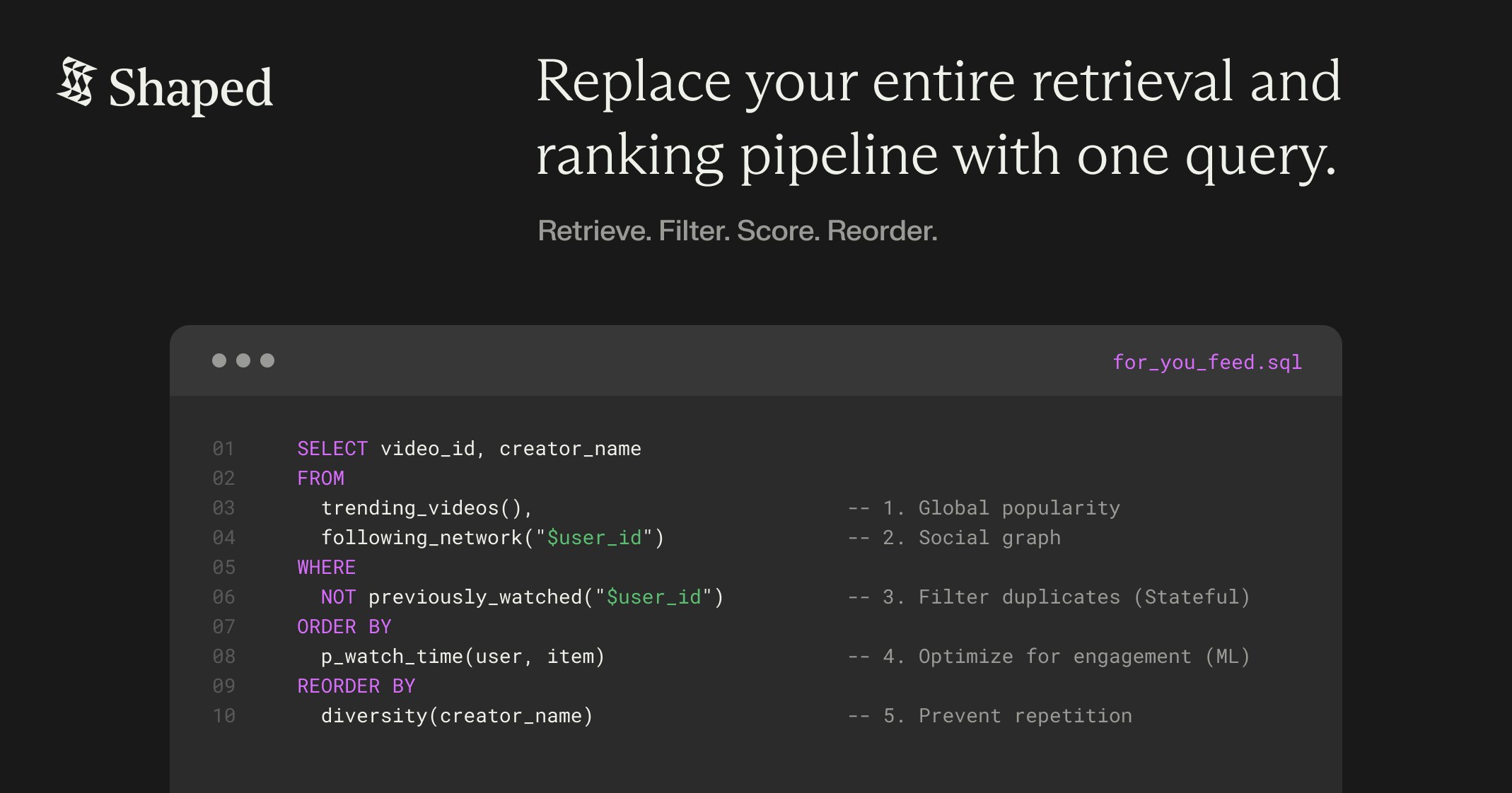

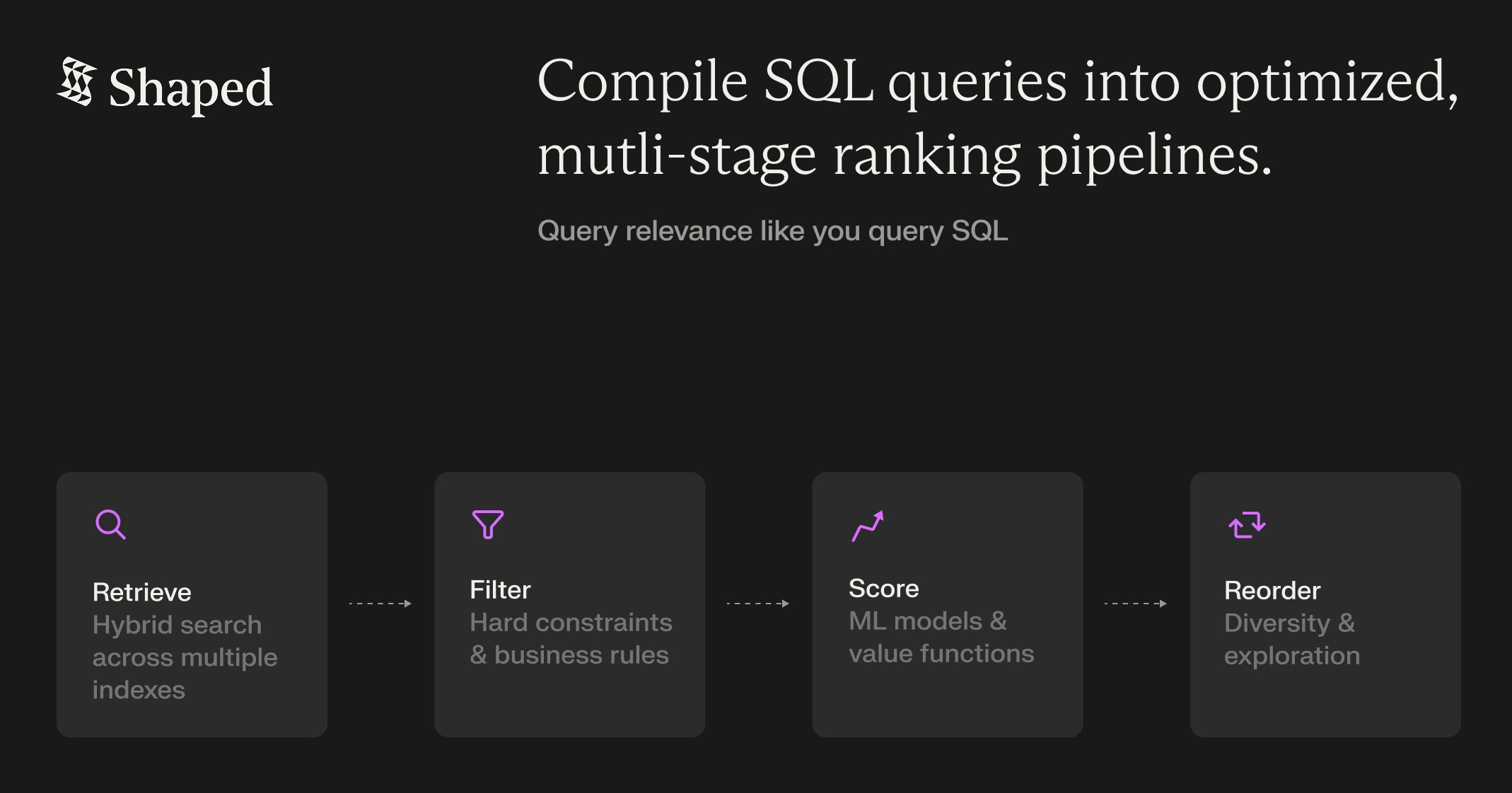

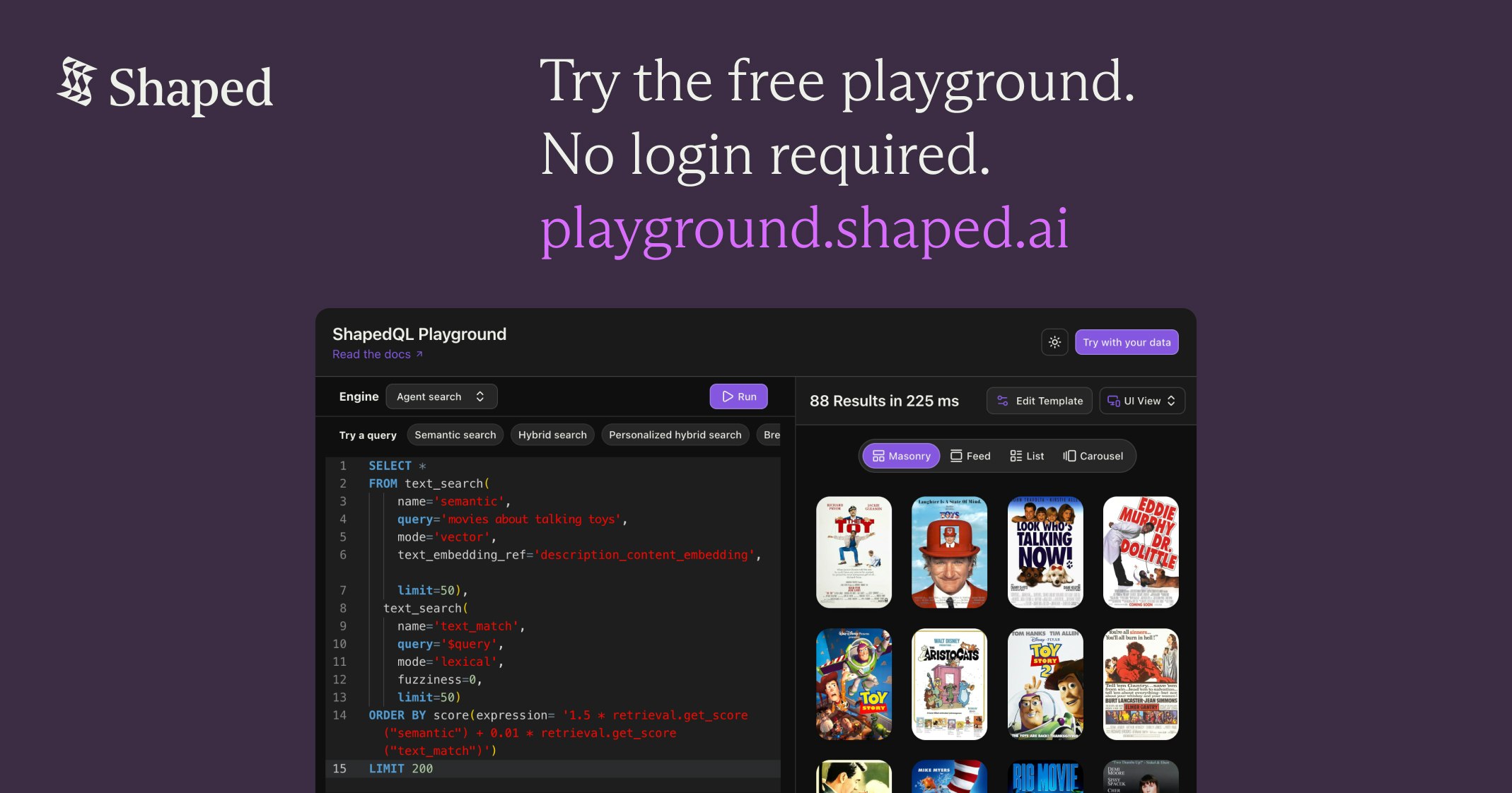

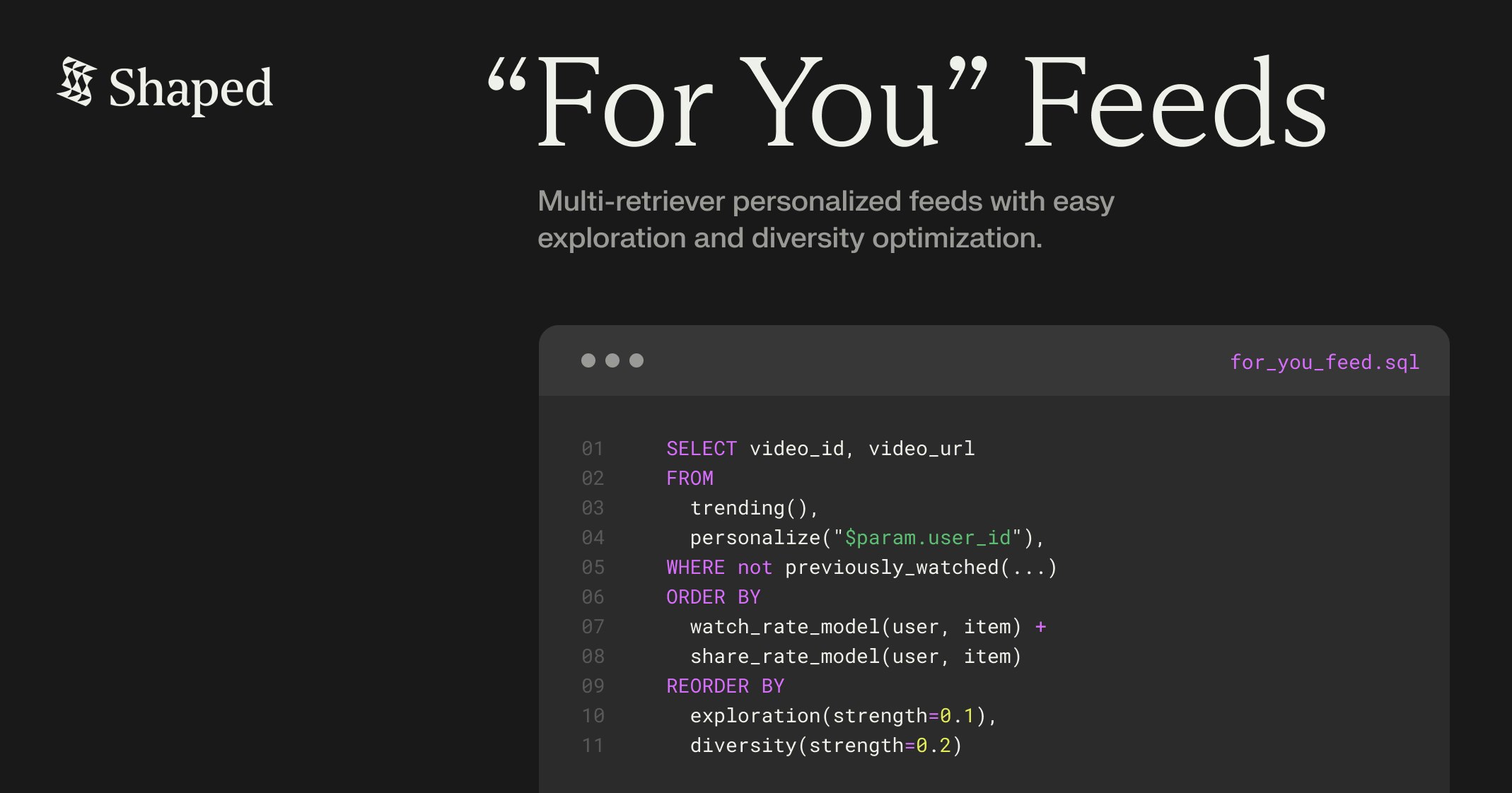

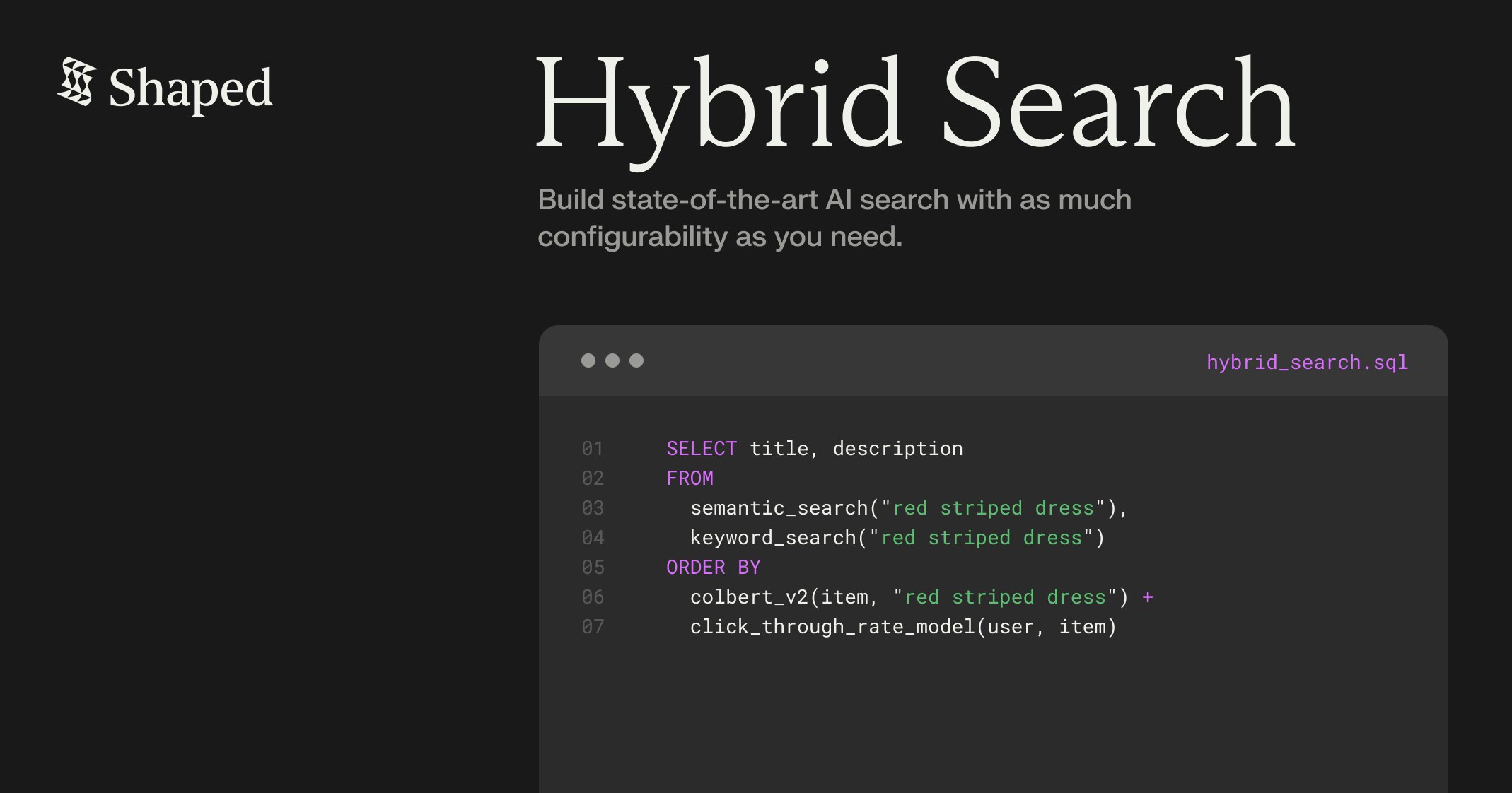

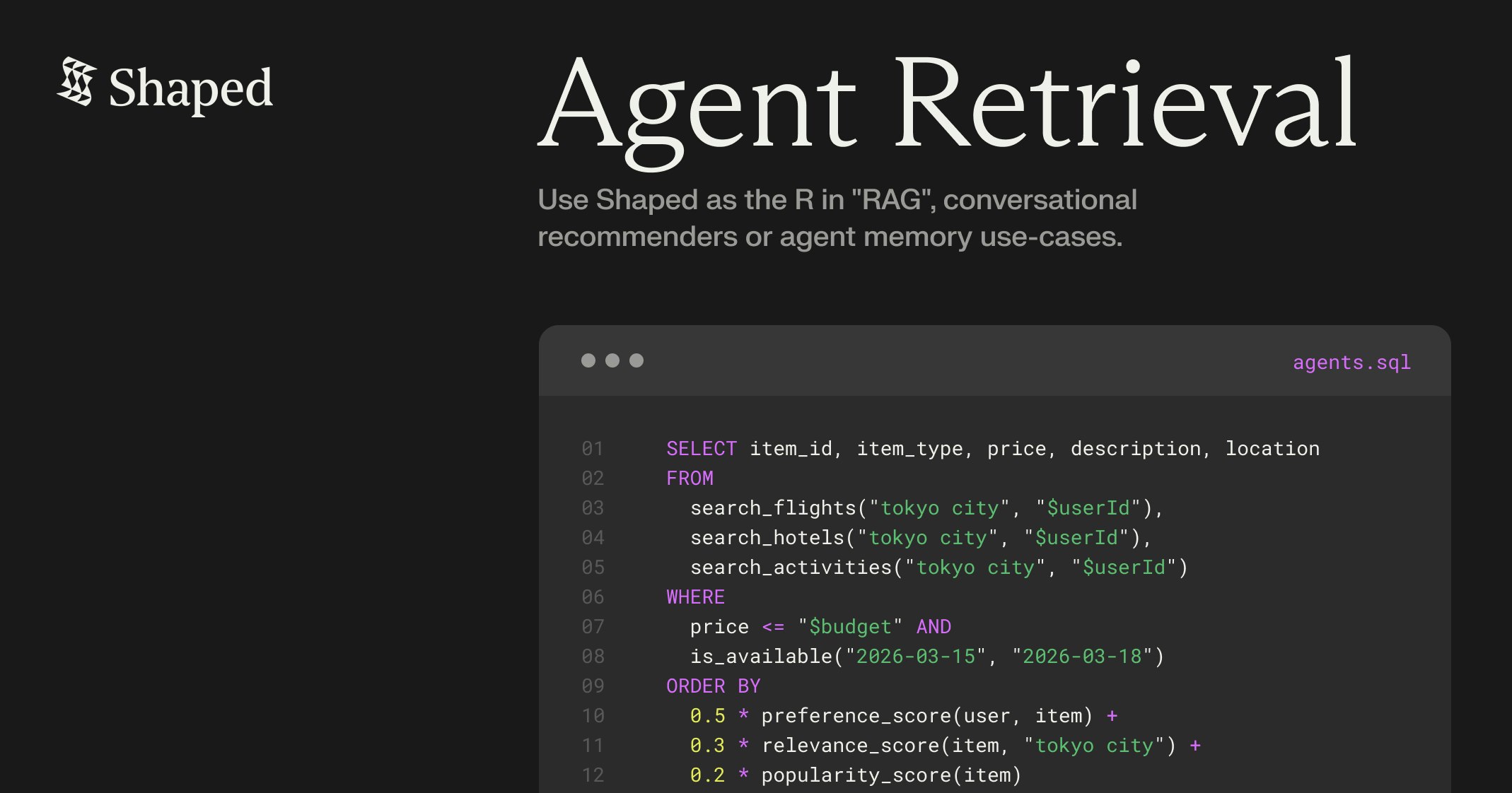

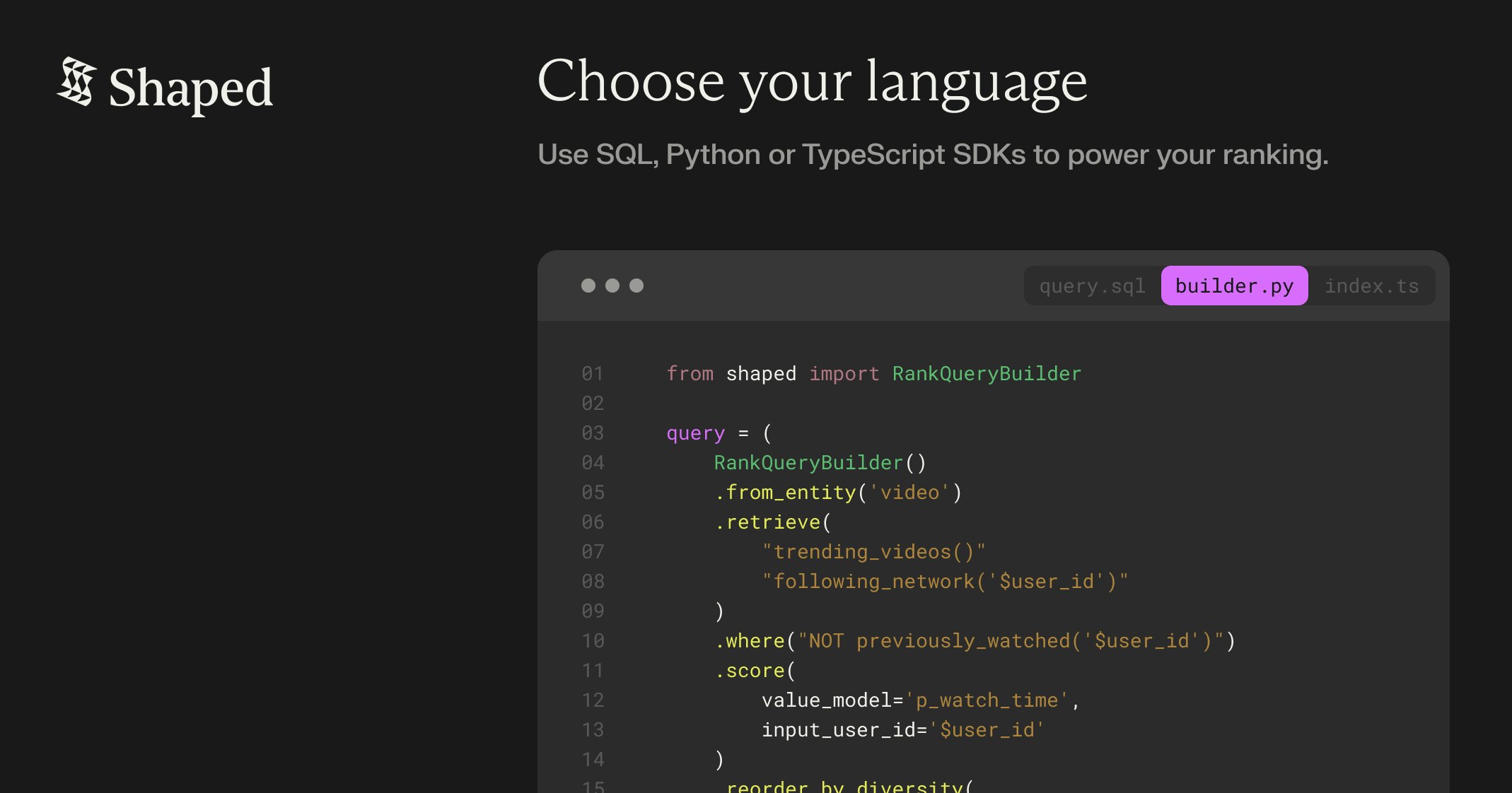

一句话介绍:ShapedQL是一个用于搜索、信息流和AI智能体的SQL引擎,它通过将简单的SQL编译成实时排序管道,帮助开发团队快速构建个性化的“为你推荐”信息流、搜索和RAG记忆系统,解决了团队在整合向量数据库、特征存储和重排序服务时面临的架构复杂、代码臃肿的痛点。

Software Engineering

Developer Tools

Artificial Intelligence

SQL引擎

实时排序

个性化推荐

向量搜索

特征工程

AI智能体

机器学习运维

信息流系统

检索增强生成

开发效率工具

用户评论摘要:用户反馈积极,认为产品精准击中了工程实现的痛点。主要问题集中在技术细节:对评分阶段ML模型的控制度与自定义能力、多源检索时的动态排序、大规模下的特征新鲜度与延迟保障、以及上线后如何快速迭代相关性。创始人团队给予了详细的技术解答。

AI 锐评

ShapedQL的野心不在于发明新算法,而在于对机器学习系统,特别是推荐与搜索系统,进行一场彻底的“工程范式”重构。它试图用声明式的SQL语言,封装从多源检索、过滤、实时模型评分到结果重排的完整复杂管线,将原本分散在Pinecone、Redis、Python脚本乃至特征平台中的“胶水代码”抽象为一层统一的接口。

其真正价值在于“降本增效”,但这个“本”不仅是代码行数,更是高级ML人才的认知负荷与团队的迭代成本。它让算法工程师和全栈开发者能以更接近产品逻辑(“给购物车推荐相关商品”)而非基础设施逻辑的方式工作,有望显著缩短从实验到生产的周期。创始人Meta AI的背景,使其对Instagram级信息流系统的复杂性与痛点有深刻理解,产品设计直指要害。

然而,挑战同样明显。首先,它将系统的核心权重完全押在了ShapedQL自身的可靠性、性能与灵活性上,这要求其底层引擎必须极其健壮。其次,虽然声明式接口降低了入门门槛,但当需要极致优化或处理非常规场景时,开发者可能会感到“黑箱”般的束缚感,其自定义模型和特征的能力边界将是关键。最后,它身处一个竞争激烈的领域,既要应对传统向量数据库的向上延伸,也要面对各大云厂商的类似托管服务。能否建立足够深的护城河,并让开发者信任其能处理大规模、高要求的线上流量,将是成功的关键。总体而言,这是一个思路正确、直击痛点的产品,但其长期成功将取决于工程实现的深度与生态构建的广度。

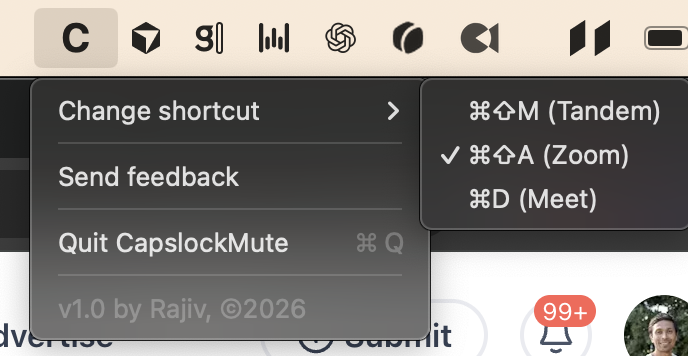

一句话介绍:一款Mac工具,将Caps Lock键重映射为Zoom、Teams等视频会议软件的静音快捷键,利用大键位优势实现快速盲操,解决用户在紧急情况下(如突发噪音)手忙脚乱寻找静音按钮的痛点。

Mac

Productivity

GitHub

Menu Bar Apps

效率工具

Mac应用

键盘映射

视频会议

静音快捷键

远程办公

生产力

用户体验优化

用户评论摘要:用户普遍认可其便捷性,将其奉为“肌肉记忆”式解决方案。主要建议与问题集中在:1. 希望Caps Lock指示灯能同步静音状态以提供视觉反馈;2. 担心应用更新导致快捷键失效或状态不同步;3. 询问是否支持更多会议软件及自动切换。

AI 锐评

CapslockMute 的价值远不止于一个键位映射。它实质上是针对“视频会议常态”这一现代工作流的一次精准外科手术,其核心洞察在于:占据键盘宝贵位置的Caps Lock键,其原生功能的使用频率已远低于静音需求。产品巧妙地将一个“空间浪费”转化为“效率枢纽”,这不仅是菲茨定律(Fitts‘ Law)的胜利,更是对硬件设计滞后于现实工作场景的辛辣讽刺。

然而,其光鲜的“单键解决方案”背后,潜藏着深层的技术脆弱性与体验断层。首先,它作为一款上层应用,严重依赖各大会议软件未经验证的快捷键API,任何一次Zoom或Teams的更新都可能无声地切断其命脉,导致状态“失同步”——这种风险在关键商业会议中是致命的。其次,用户对指示灯同步的强烈渴求,恰恰暴露了当前方案的“感知黑洞”:肌肉记忆虽快,但缺乏即时、可靠的确认反馈,用户可能在“自以为静音”的状态下滔滔不绝。创始人坦言MacOS限制使得指示灯映射“几乎不可能”,这成了产品体验的天花板。

产品的真正挑战在于,它试图在操作系统与应用软件的夹缝中,搭建一座本应由系统层或硬件层提供的桥梁。它的流行,反衬出笔记本制造商在适应“视频会议优先”时代时的麻木与迟缓。长远看,它或许更像一个成功的概念原型,其终极命运要么被操作系统原生功能吸收,要么因平台限制而止步于小众极客工具。它的成功,在于响亮地提出了一个正确的问题;而它的局限,则在于受制于现有生态,无法给出一个彻底、稳健的答案。

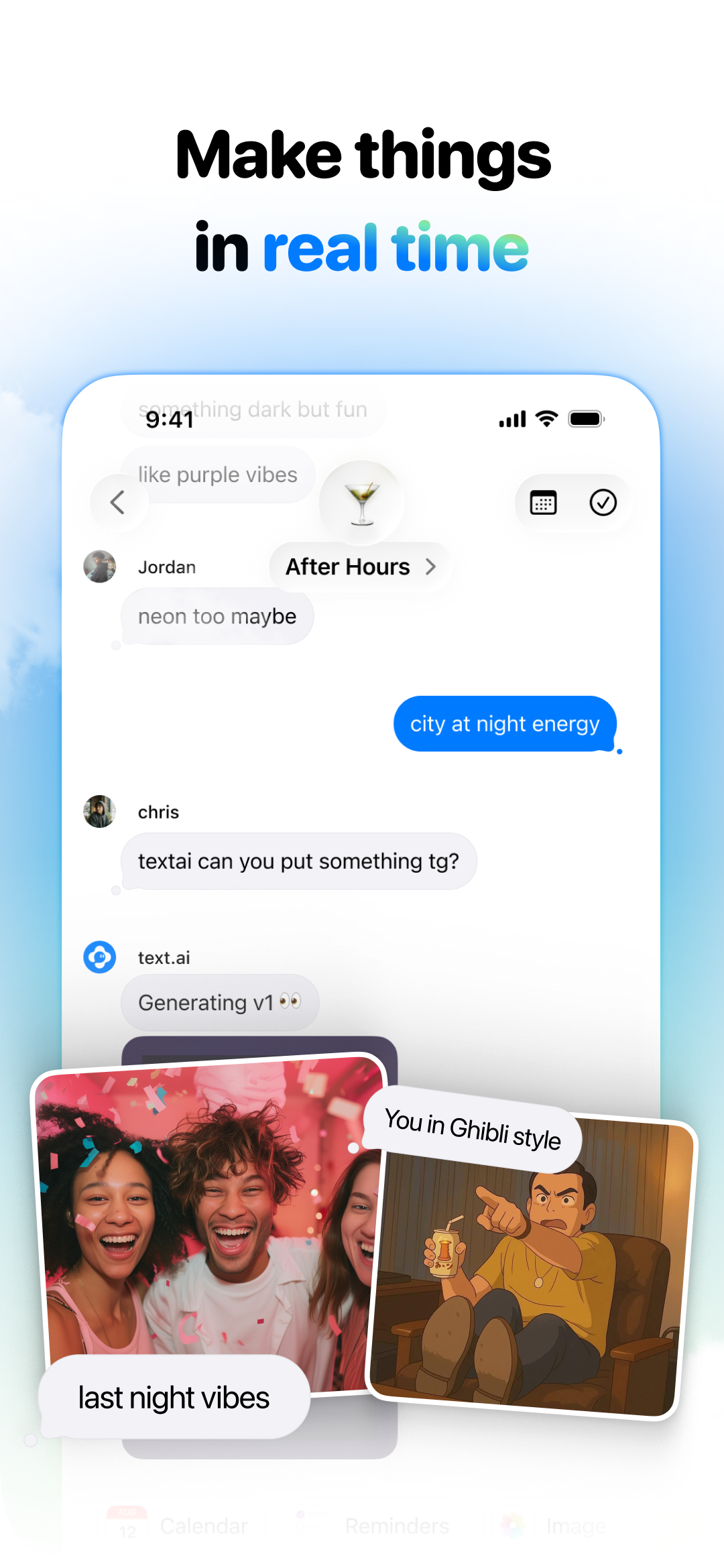

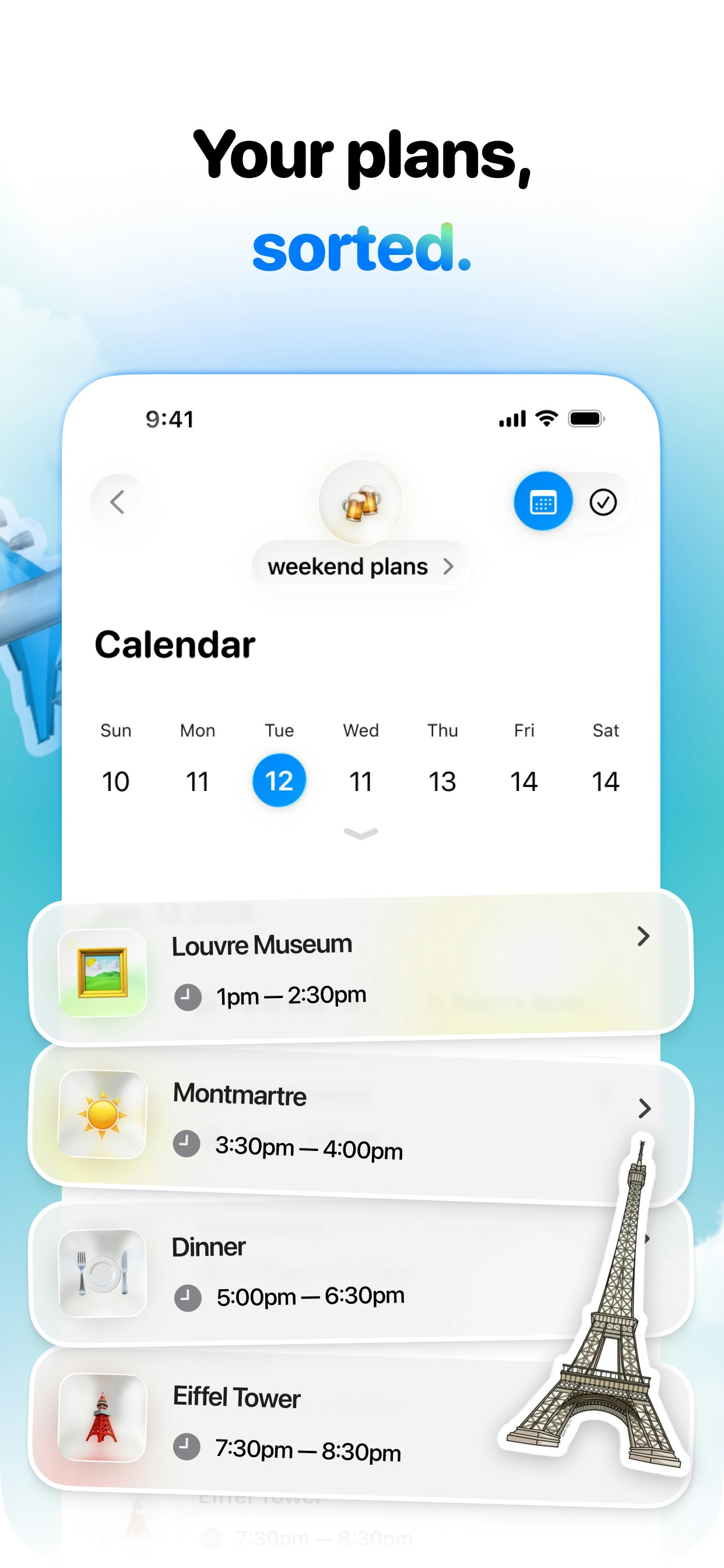

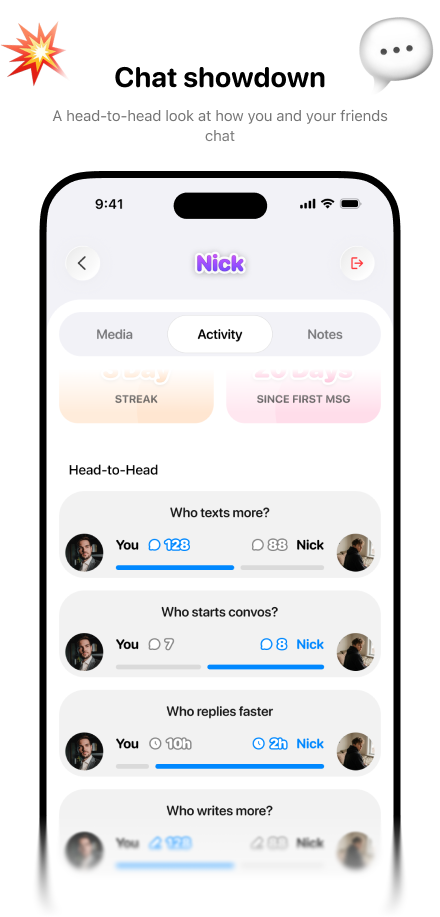

一句话介绍:一款为朋友群聊设计的、具备“社交技能”的AI聊天应用,通过内置计划制定、餐厅预订、图片共创等功能,解决群聊中计划难以落地、组织协调费时费力的痛点。

Messaging

Social Network

Artificial Intelligence

社交AI

群聊应用

活动规划

朋友社交

AI助手

生成式AI

生活效率

兴趣社交

智能日历

群聊回顾

用户评论摘要:用户肯定产品概念及解决计划“流产”痛点的价值,并对个性化记忆、娱乐功能表示兴趣。核心质疑集中在付费模式(按用量计费)对群聊场景的适用性及长期可持续性,并关注AI介入对话的时机与分寸感。

AI 锐评

Alfi敏锐地捕捉到了一个关键趋势:群聊正成为新一代的、去中心化的“真实社交网络”。其核心价值并非又一个聊天工具,而是试图成为群聊场景的“智能协作者”或“首席运营官”,将散落各处的社交意图转化为实际行动。产品通过集成Yelp预订、多人图像生成、社交日历等功能,直接攻击“群聊是计划的坟墓”这一经典难题,方向精准。

然而,其面临的挑战同样尖锐。首先,商业模式与产品本质存在潜在冲突。向“朋友”群聊引入按消息或图像数量计费的机制,极易造成支付责任与使用体验的割裂,这与促进无压力社交的初衷背道而驰。评论中“谁买单?”的质问直指要害。其次,其宣称的“社交技能”——理解语境、群体动态并适时介入——是极高的技术与社会工程学挑战。过度介入会沦为恼人的“第三方”,沉默不语则失去价值,这其中的平衡算法需要极其精妙的设计和海量的场景数据喂养。

本质上,Alfi是在赌两件事:一是用户为社交便利与娱乐的付费意愿,能超越对免费但笨拙的现有工具(如WhatsApp)的依赖;二是其AI能真正进化成一位“懂分寸的数字化朋友”,而非一个需要被管理和付费的机器人。它若想成功,必须将体验打磨到足以让整个社交群体心甘情愿地迁移并分摊成本,这注定是一条艰难但颇具想象力的道路。

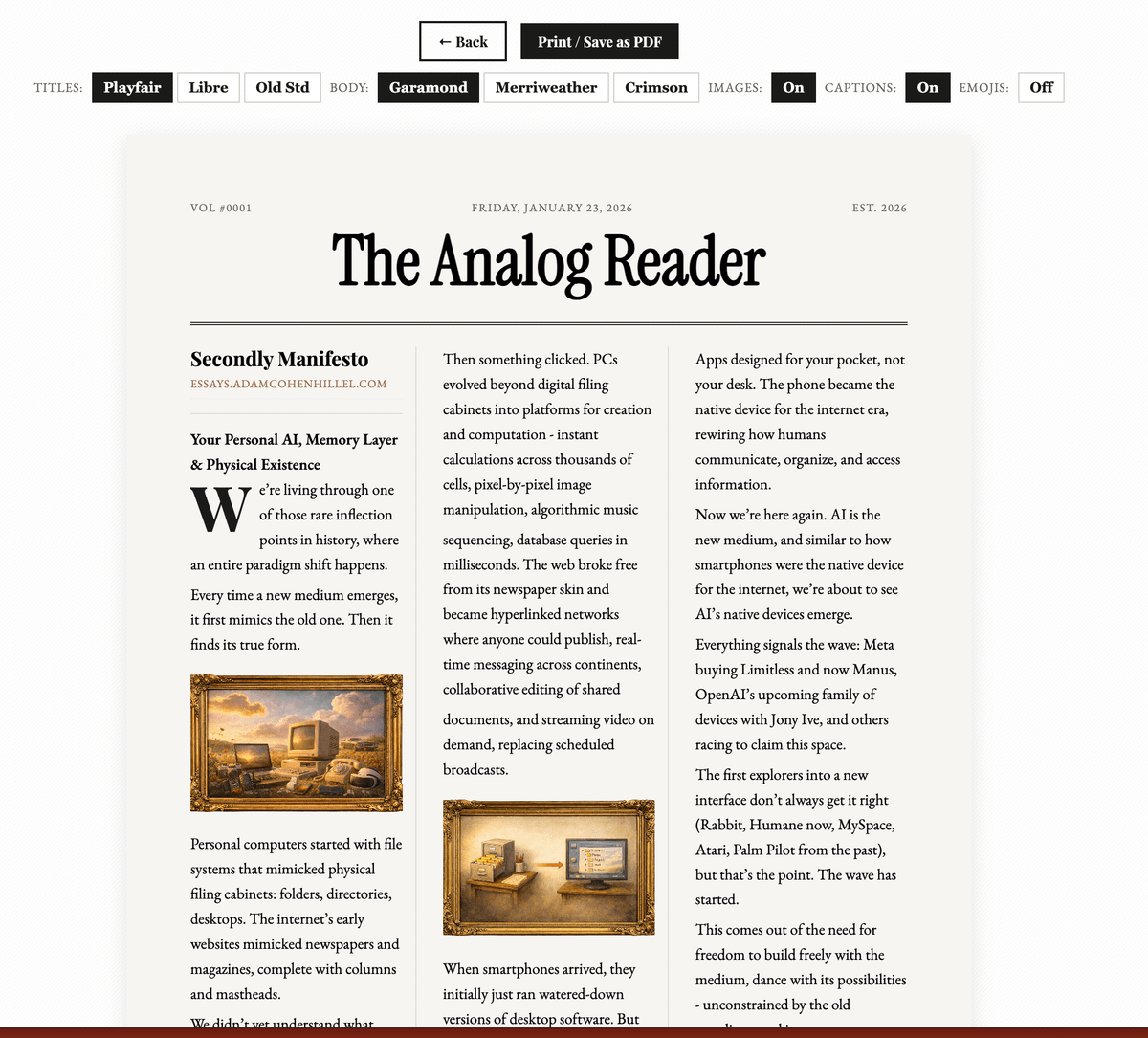

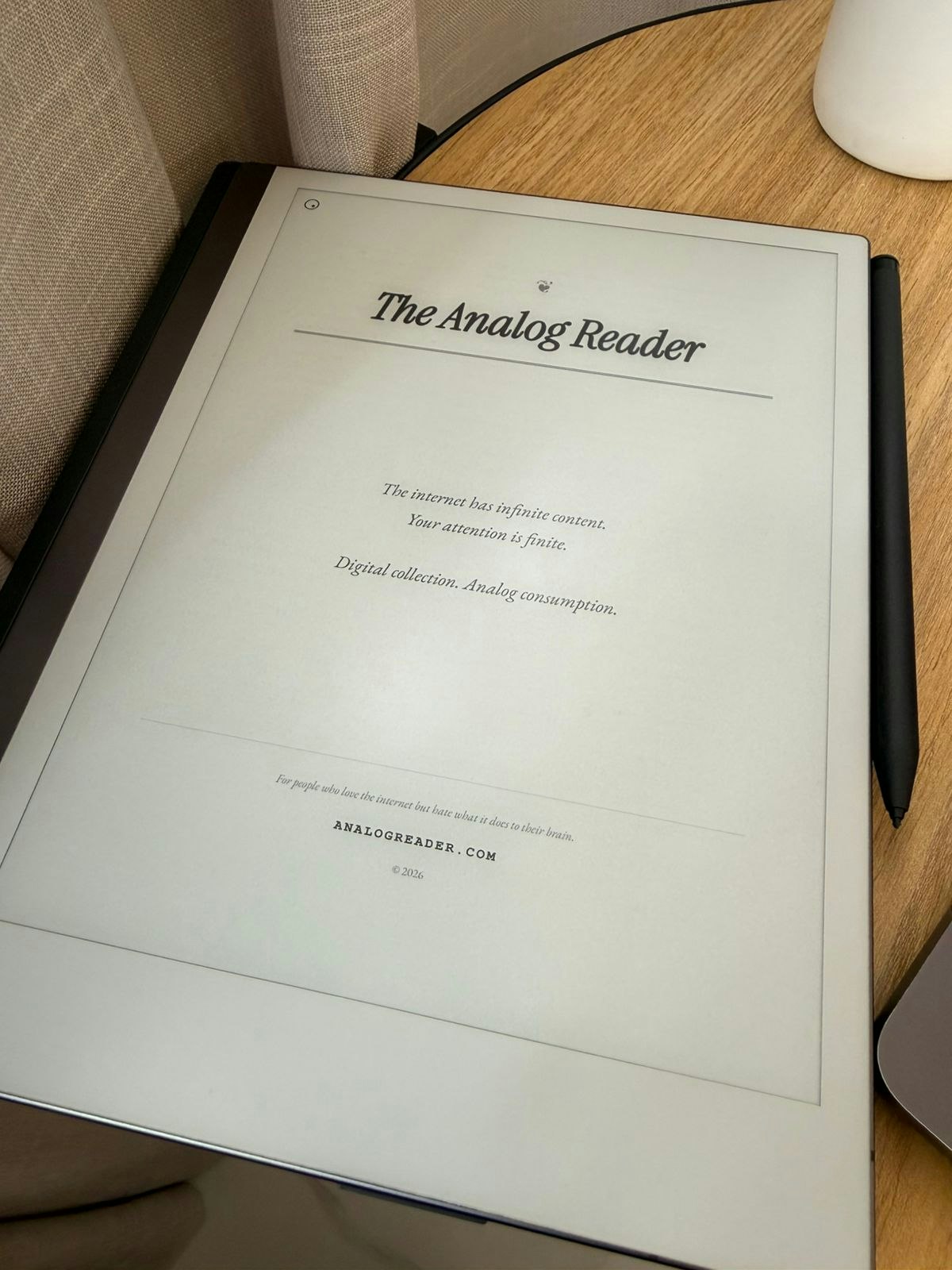

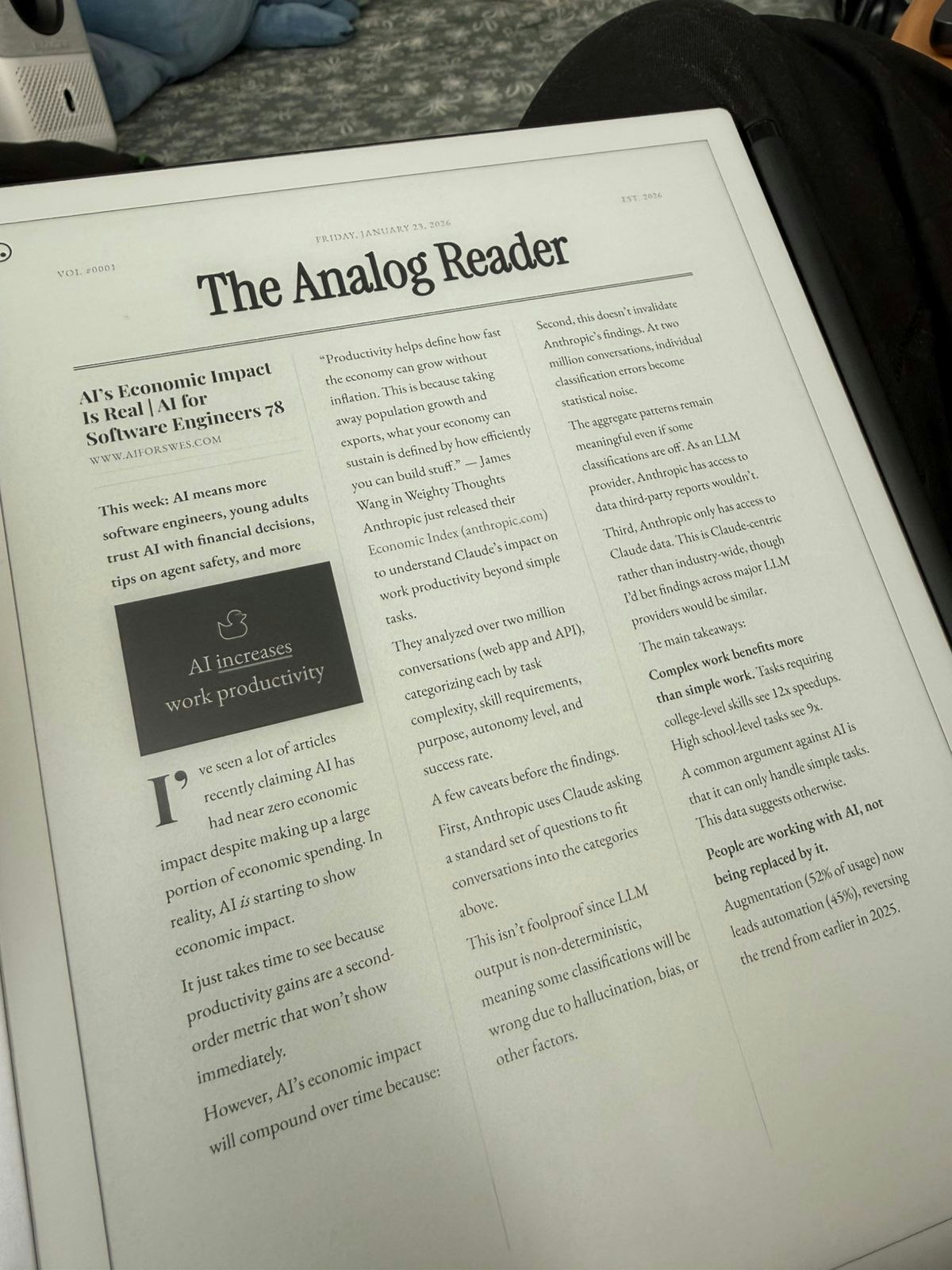

一句话介绍:一款将用户订阅的新闻通讯和RSS内容转换为可打印报纸格式的工具,在信息过载和数字干扰的场景下,帮助用户实现专注、深度的离线阅读,解决“收藏无数却从未阅读”的痛点。

News

User Experience

Social Media

数字排毒

内容聚合

离线阅读

可打印报纸

新闻通讯

RSS

注意力管理

生产力工具

慢科技

PDF生成

用户评论摘要:用户普遍认同产品理念,深感数字阅读带来的分心与焦虑,认为纸质化能促进专注与完成阅读。主要反馈包括:肯定其帮助建立阅读仪式感、缓解信息过载;询问与reMarkable、Kindle Scribe等设备的兼容性;建议增加对生成内容的“语调调整”控制以增强信任。

AI 锐评

Analog Reader 表面上是一个功能简单的格式转换工具,但其真正的锋芒在于对当下数字生活方式的尖锐批判与温和反抗。它没有试图在算法和流量的战场上搏杀,而是巧妙地开辟了一个“数字收集,模拟消费”的撤退路径。其核心价值并非技术突破,而是一种哲学主张:将信息从争夺注意力的赛博空间中“物理化”剥离,通过打印这一行为,完成所有权和消费权的宣告。

产品精准命中了现代知识工作者的认知失调:我们热爱信息开放,却厌恶随之而来的碎片化与焦虑。评论中“邮箱爆满却鲜少读完”、“同一文章在手机上读不完在纸上却能”的共鸣,印证了这是一个广泛存在的真实困境。Analog Reader 提供的解决方案看似复古低效,实则通过引入打印的成本(时间、操作)和纸质载体的物理限制,逆向实施了“注意力筛选”和“承诺机制”,将漫无目的的浏览转化为有意图的阅读仪式。

然而,其面临的挑战同样清晰。首先,在环保意识高涨的时代,倡导打印可能面临理念性质疑,尽管其鼓励的是有选择的深度打印而非无节制浪费。其次,商业模式存疑,“免费”模式如何持续?未来是否会对高级排版、个性化版式或与打印服务商分成收费?最后,其体验严重依赖外部硬件(打印机、电子墨水屏),作为中间环节的工具,用户粘性和壁垒可能不足。

本质上,Analog Reader 是“慢科技”运动的一个具体实践。它不提供更多内容,而是提供更好的消费内容的心智状态。它的成功与否,不在于能否成为爆款应用,而在于能否吸引一个足够忠诚的社群,共同践行这种“反潮流”的阅读信仰,并在过程中找到可持续的生存之道。这是一场针对数字异化的微型实验,值得尊敬,但前路不易。

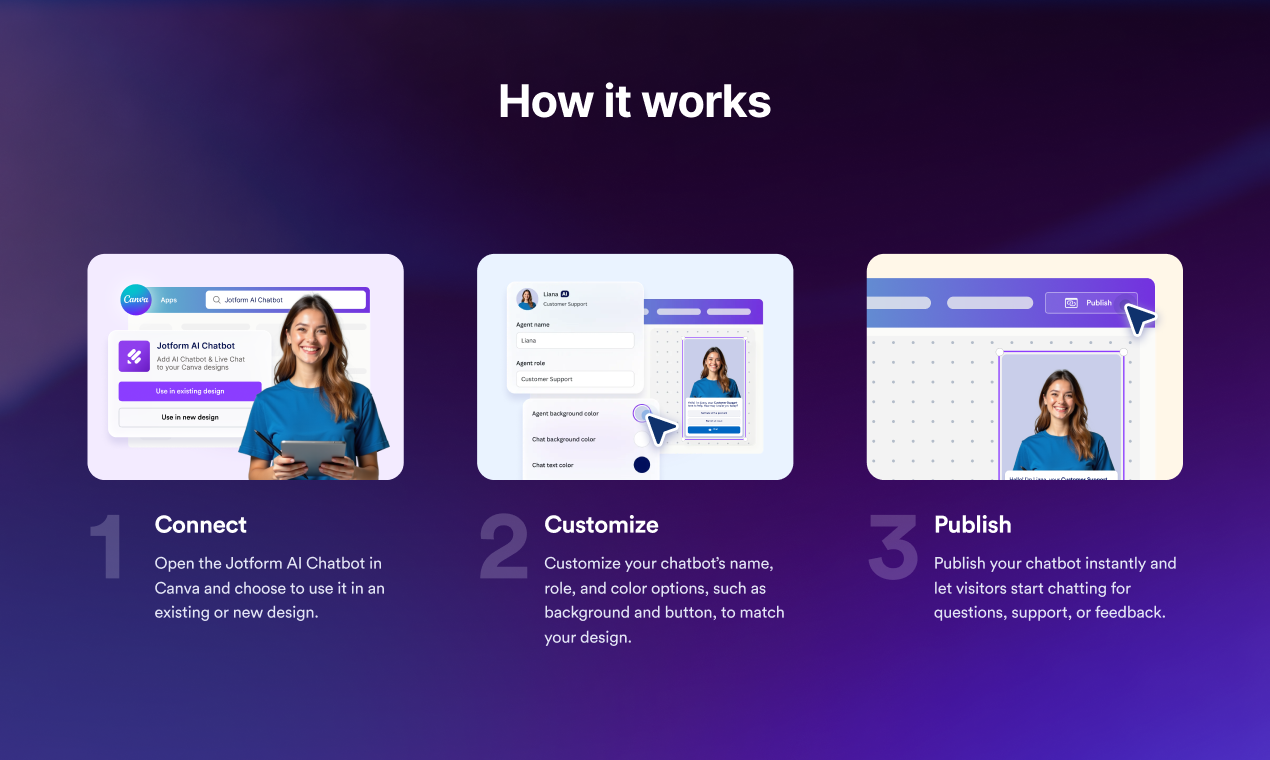

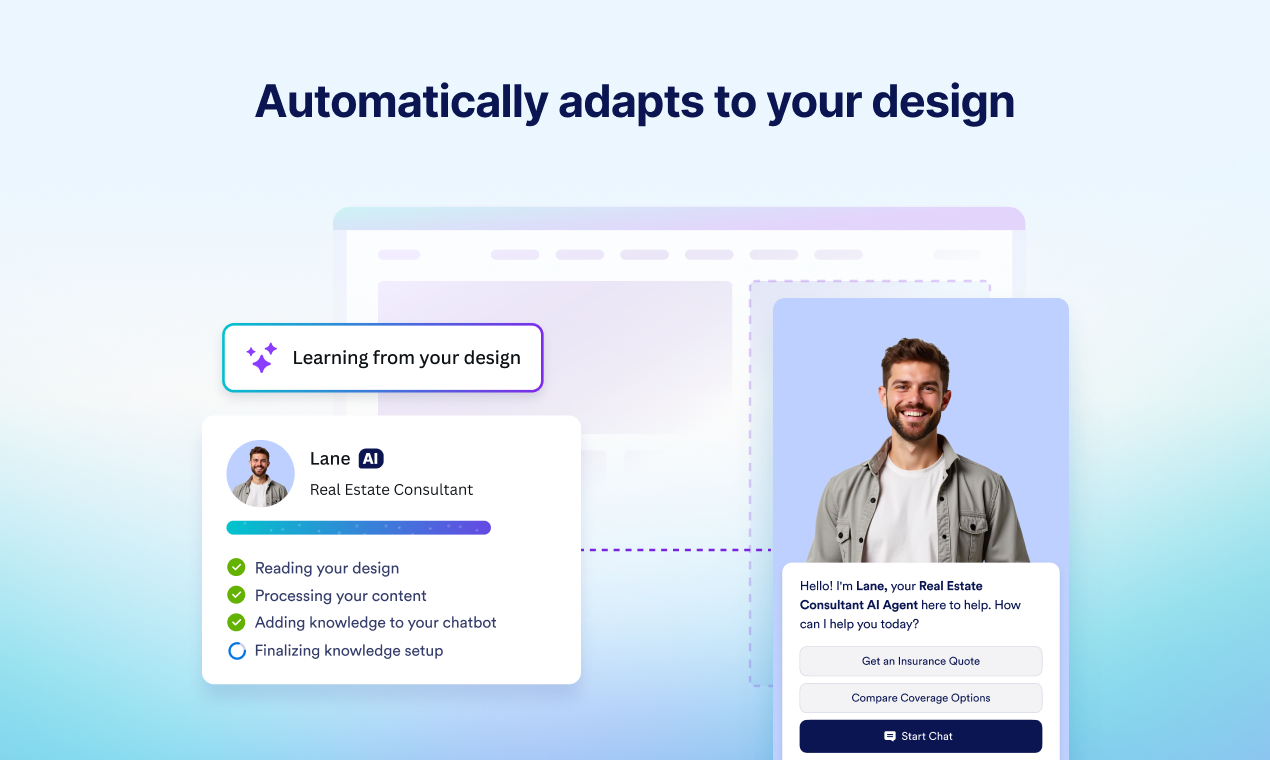

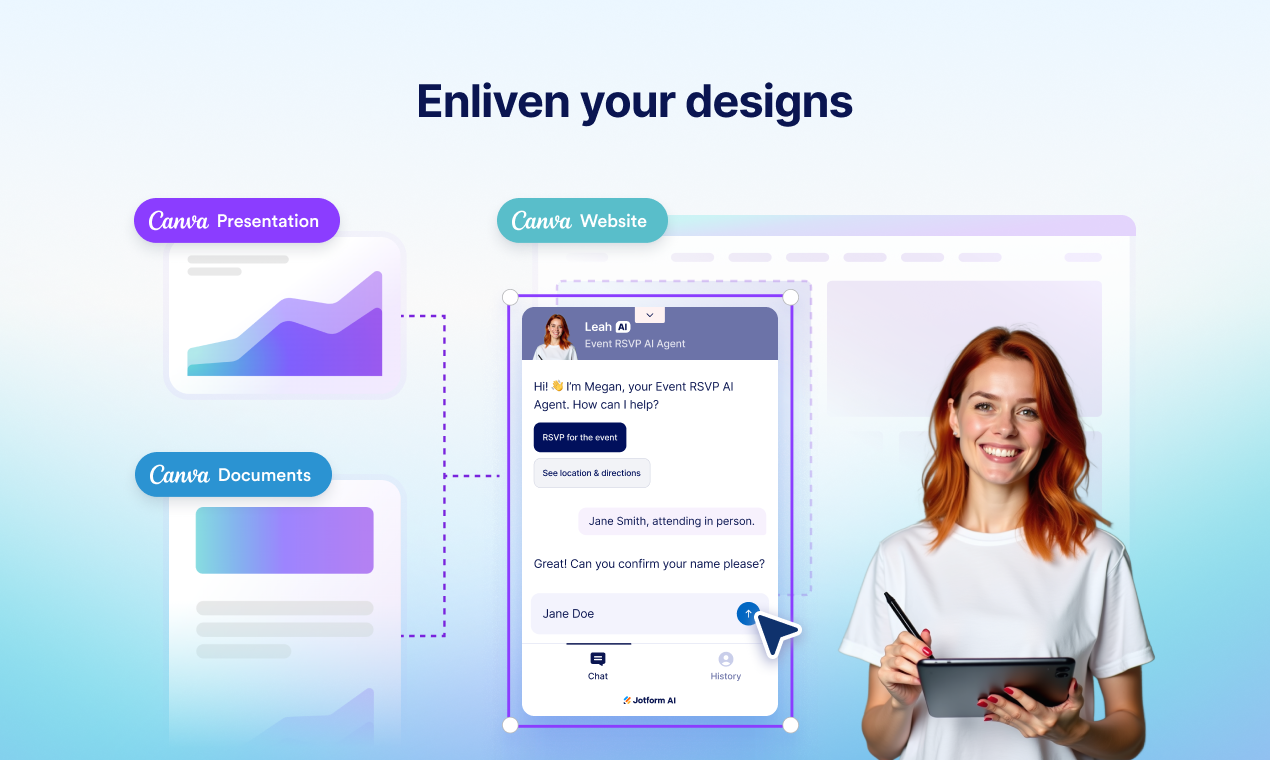

一句话介绍:这款产品允许用户在Canva设计作品中直接嵌入AI聊天机器人,将静态页面转化为交互式体验,用于即时解答访客疑问、捕获线索并引导后续行动,解决了Canva设计缺乏互动性、导致用户参与中断的痛点。

Design Tools

Productivity

Artificial Intelligence

AI聊天机器人

Canva集成

无代码交互

线索捕获

用户自助服务

表单自动化

品牌定制

对话式界面

页面内交互

工作流自动化

用户评论摘要:用户反馈肯定产品将静态Canva页面转化为对话式界面的方向,尤其认可其在线索捕获和自助服务流程中的价值。主要问题集中在聊天机器人的决策逻辑透明度(如何选择直接回答或引导至表单等)以及处理复杂条件分支表单时的设置直观性与学习成本。

AI 锐评

Jotform此次推出的AI Chatbot for Canva,本质上是一次对“静态内容交互化”趋势的精准卡位。其真正价值并非在于聊天机器人技术本身,而在于将成熟的AI对话能力无缝植入全球最主流的轻量级设计平台,试图解决内容展示与用户行动之间的“最后一公里”断裂问题。

产品逻辑清晰:Canva承载了海量的营销页面、产品介绍和宣传材料,但这些内容长期处于“只读”状态。访客的疑问无法即时解答,转化路径被迫跳出,导致流失。该产品通过嵌入式聊天机器人,将单向传播转变为双向对话,试图在内容消费场景内直接完成答疑、筛选和引导,提升转化效率。

然而,其面临的挑战同样明显。首先,场景深度有限。在简单的FAQ和线索捕获之外,复杂业务逻辑(如评论中提及的多级条件分支)在无代码环境下能否优雅实现存疑,可能陷入“简单场景不够强,复杂场景做不了”的尴尬。其次,决策黑箱问题。机器人何时应答、何时引导至下一步,其逻辑的透明度和用户可配置性,是影响实用性与信任度的关键,目前看来仍是未明确解答的痛点。

这更像是一个“功能嫁接”而非“范式革新”。它扩展了Jotform自身表单自动化生态的入口,也为Canva注入了交互层,但其长期价值取决于能否从“页面的装饰性交互”升级为“核心业务流的智能枢纽”。如果仅停留在美化版的在线客服插件层面,其竞争力将十分脆弱。下一步,应聚焦于开放更精细的对话流程设计权,并深化与Canva内数据层(如设计元素、链接组件)的联动,才能真正让设计“活”起来。

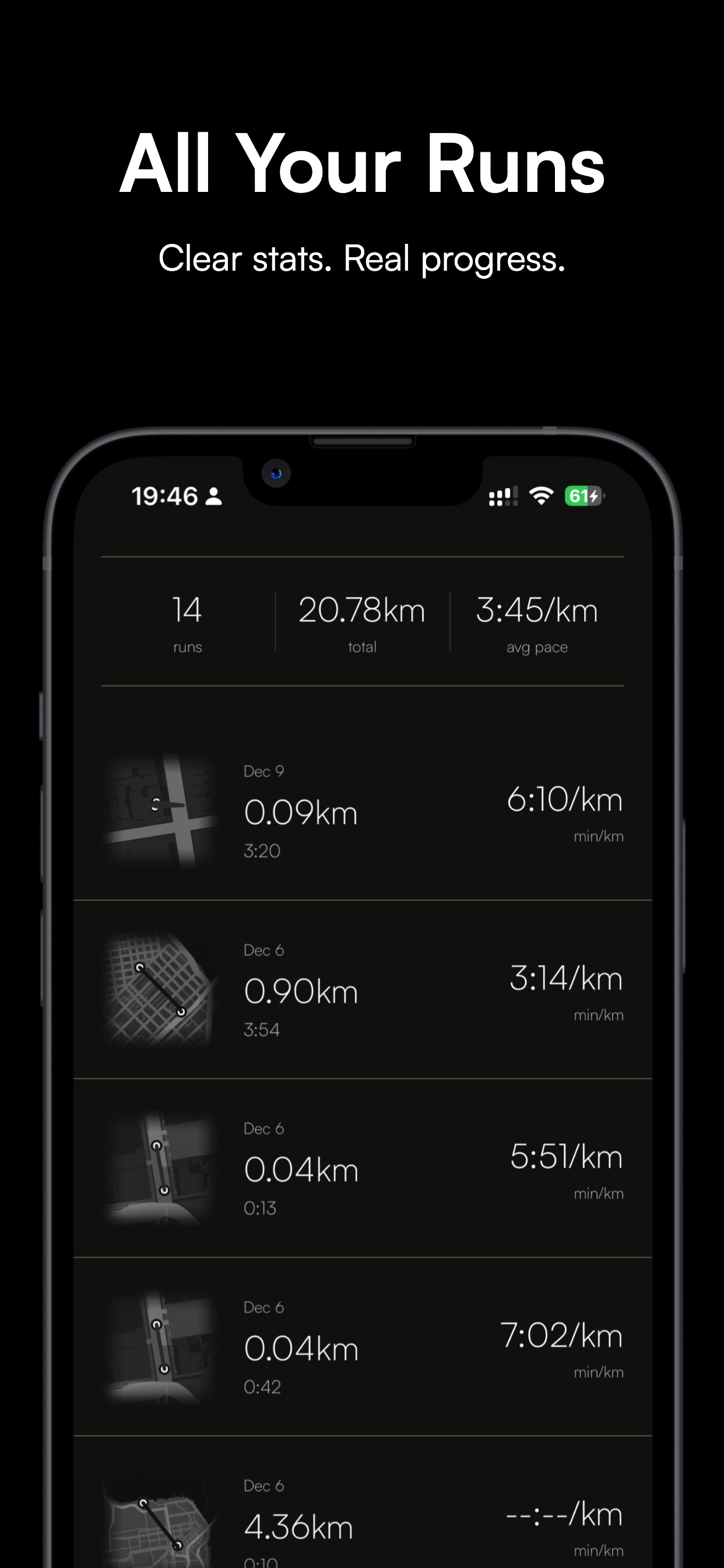

一句话介绍:一款通过节拍器原理,在跑步训练中提供实时步频引导,解决跑者配速不稳、易疲劳受伤痛点的移动应用。

Health & Fitness

Health

Running

跑步辅助

节拍器应用

步频训练

运动健康

Apple Watch集成

Strava同步

社交功能

马拉松训练

跑步经济性

伤害预防

用户评论摘要:用户反馈积极,认为概念巧妙,尤其赞赏Apple Watch触觉反馈实现了无耳机训练。开发者互动频繁,回应了关于中途调整节奏、Strava同步等具体功能问题,并采纳了添加Product Hunt渠道等建议。

AI 锐评

Runo 2.0的本质,是将专业跑步教练口中抽象的“节奏感”和“经济性”,降维成一个可听可感的简单节拍。其真正价值并非技术创新,而是对跑步训练中一个古老但顽固的痛点——配速漂移——进行了极致简化的工程学干预。

产品聪明地避开了与GPS手表在数据记录上的正面竞争,转而抢占了一个更前置的感官入口:听觉(及触觉)节奏引导。这相当于在数据反馈闭环中,加入了一个实时的“前馈”控制。Apple Watch的触觉反馈功能,更是精准地切入了“严肃跑者不愿戴耳机”或“户外跑步需保持环境音”这一细分场景,展现了产品对用户行为细节的洞察。

然而,其长期价值面临两重拷问:一是用户粘性。如开发者所言,这是“最终可以摆脱的辅助轮”,那么用户达到肌肉记忆后,产品的留存将依赖其社交和数据分析等衍生功能,而这正是Strava等成熟平台的腹地。二是科学适配的复杂性。跑步步频存在个体差异,并非越高越好。产品虽提供了调整空间,但将复杂的生物力学优化简化为一个固定节拍,可能存在过度简化训练科学的风险,需警惕用户盲目追求高步频而忽视步幅、触地方式等其他要素。

总体而言,Runo是一款定位精准、体验闭环的“专家型”工具。它能否从“训练拐杖”演进为“跑步社区”,取决于其社交功能与数据整合的深度,否则可能面临工具类应用典型的天花板。

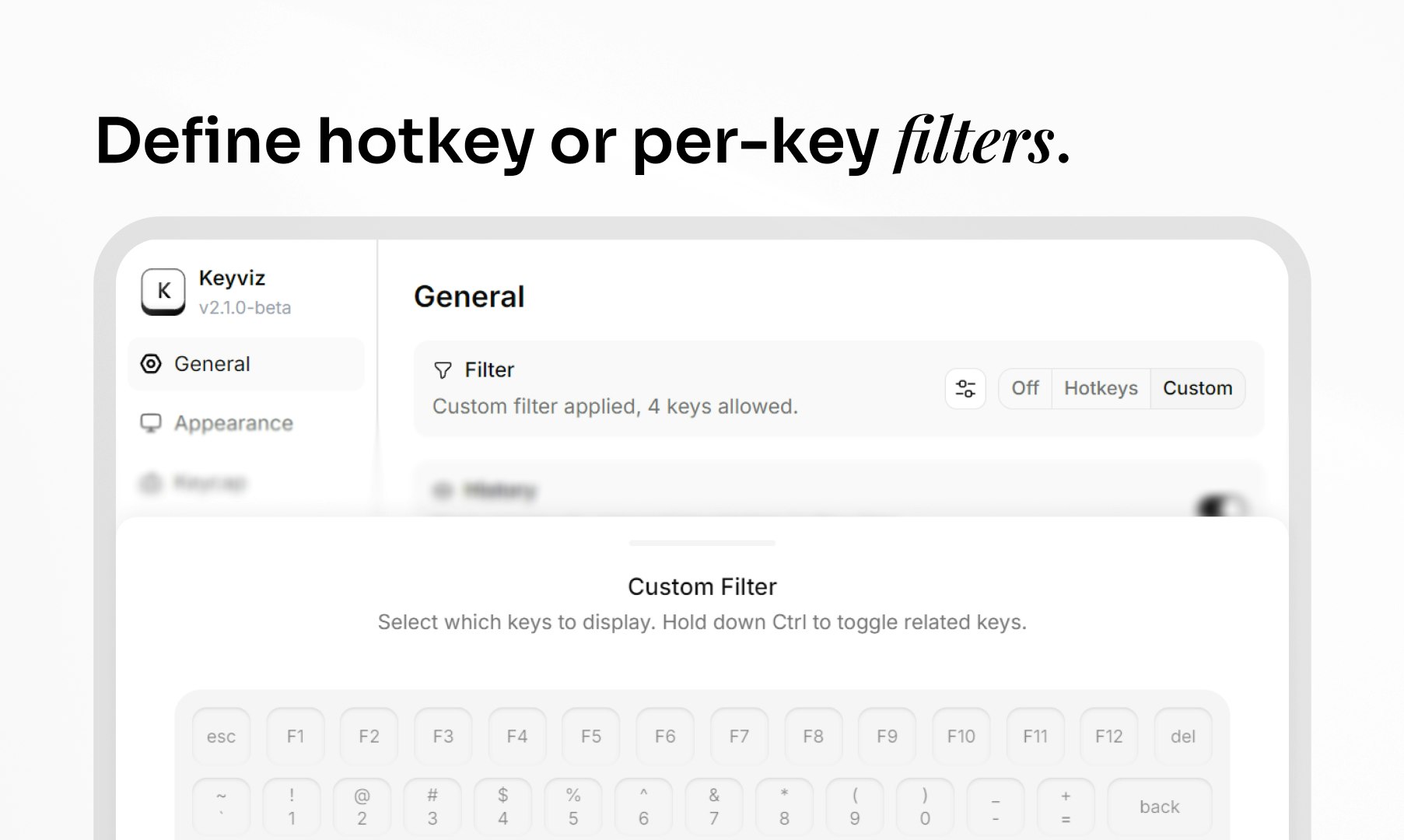

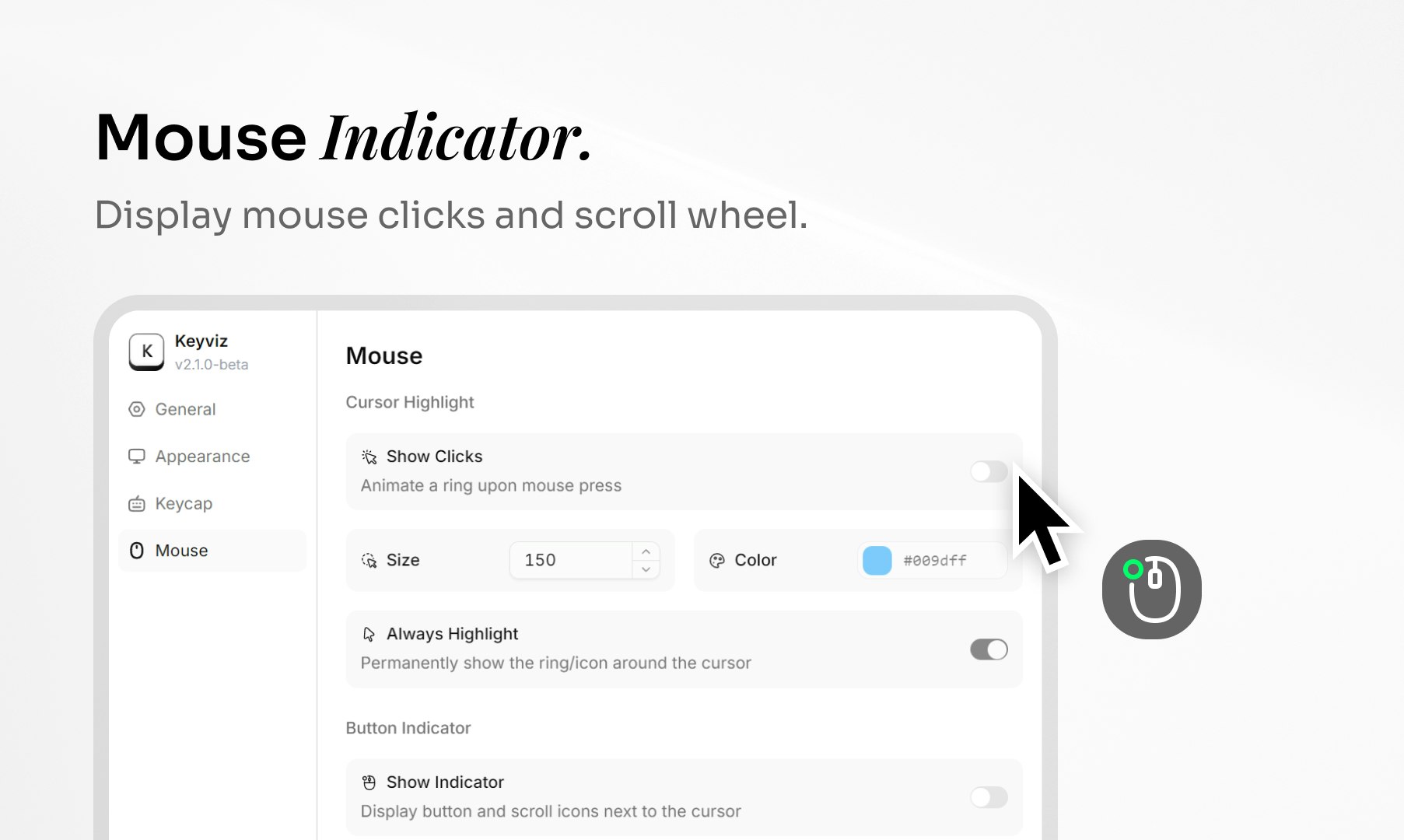

一句话介绍:Keyviz是一款免费开源按键与鼠标可视化工具,可在屏幕共享时实时显示操作轨迹,解决演示者无法清晰展示快捷键与鼠标动作的痛点。

Design Tools

Developer Tools

GitHub

开源工具

按键可视化

鼠标追踪

屏幕共享辅助

演示工具

实时反馈

教学辅助

效率工具

用户评论摘要:开发者宣布重大更新,新增鼠标可视化功能并优化性能。用户反馈此升级是“游戏规则改变者”,并询问技术实现细节,如拖拽可视化与性能影响,尤其关注其编程教学场景的应用。

AI 锐评

Keyviz的迭代揭示了一个深层趋势:工具类软件正从“单点解决方案”进化为“工作流闭环组件”。其早期版本仅解决按键可视化这一狭窄需求,而此次将鼠标轨迹纳入监控,实质上是完成了“数字操作意图”的全面外化。这远非功能堆砌,而是精准击中了知识工作者(尤其是教育者、教程创作者)在异步沟通中的核心困境——操作过程的“黑箱”。

值得警惕的是其技术路径选择。基于Tauri框架虽利于保持轻量,但实时捕获与渲染高频率的鼠标事件(尤其是拖拽)对底层系统钩子与性能优化是严峻考验。用户评论中提及的“Null”问题及性能疑虑,正是此类工具从“可用”到“可靠”必须跨越的鸿沟。其真正的护城河并非“可视化”这一表象功能,而在于极端稳定性与近乎零延迟的同步能力——在直播或录制中,任何卡顿或显示错误都会直接摧毁演示可信度。

此外,“开源免费”模式是一把双刃剑。它固然能快速构建社区与口碑,但如何维持长期开发动力?其商业化想象空间可能不在于向终端用户收费,而在于成为OEM组件,嵌入在线教育平台、远程协作软件甚至企业内训系统中,作为增强用户体验的基础设施。若团队能持续深耕底层系统交互数据的捕获与渲染效率,其技术资产的价值将远超一个桌面小工具。

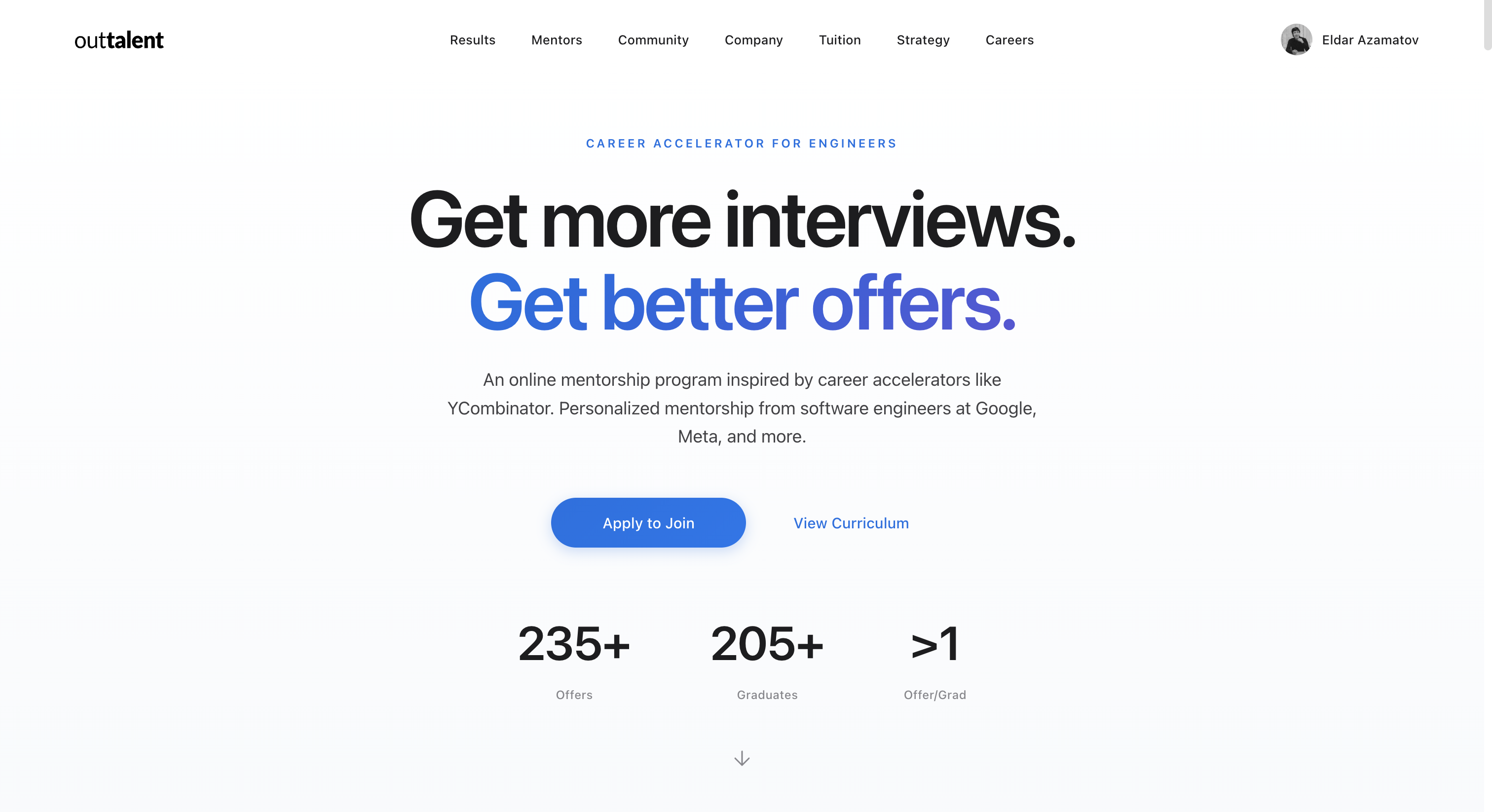

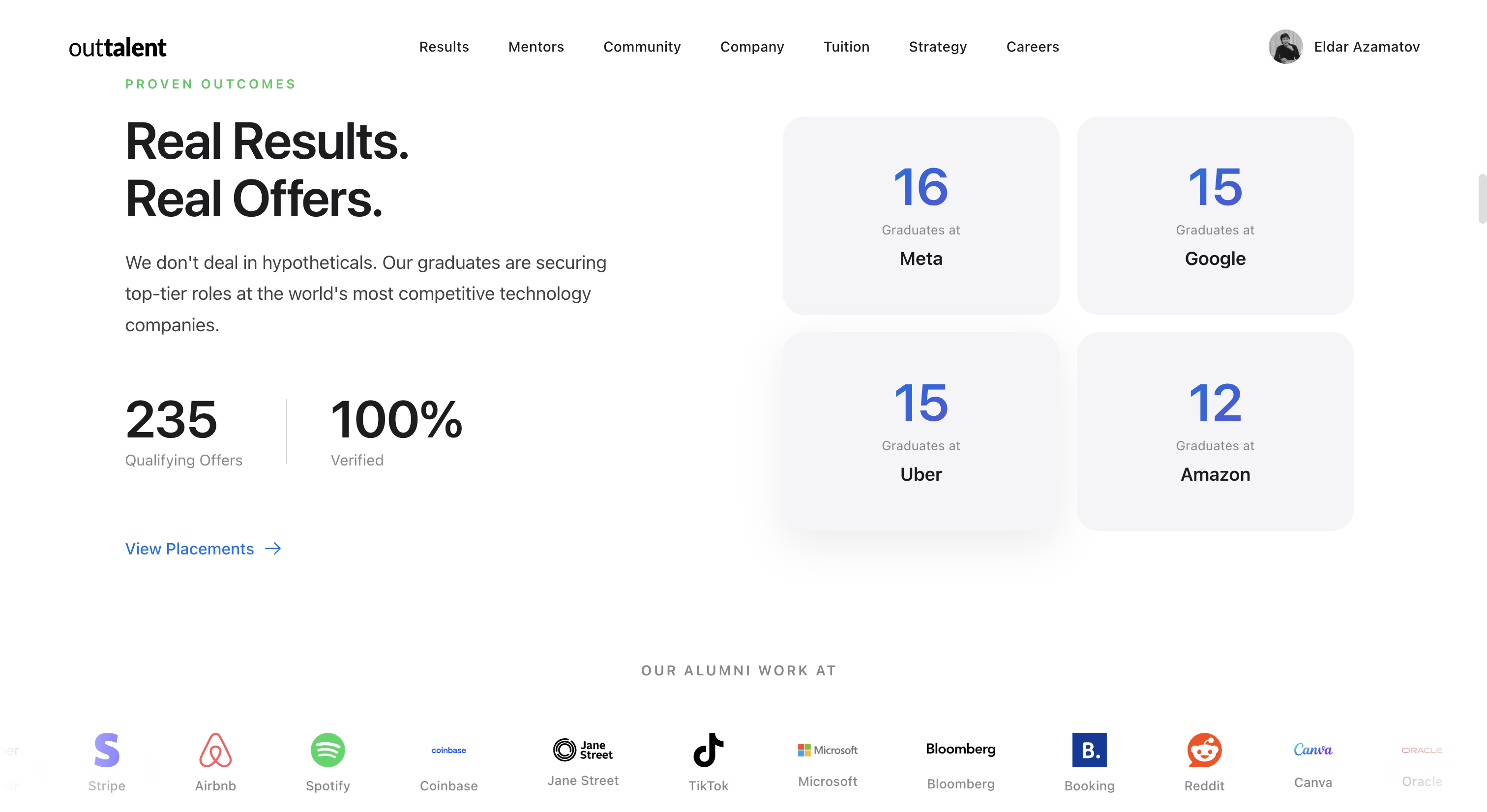

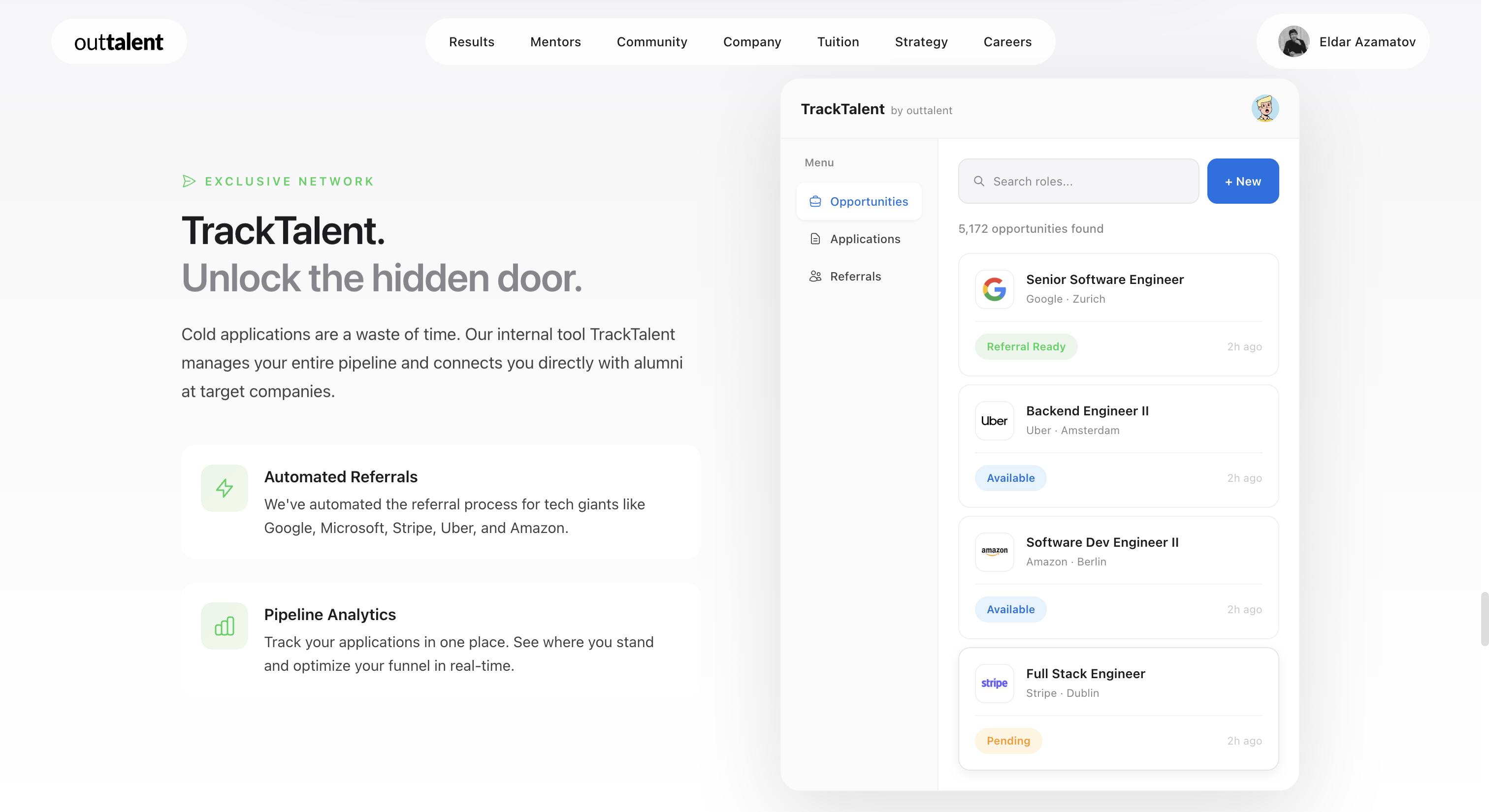

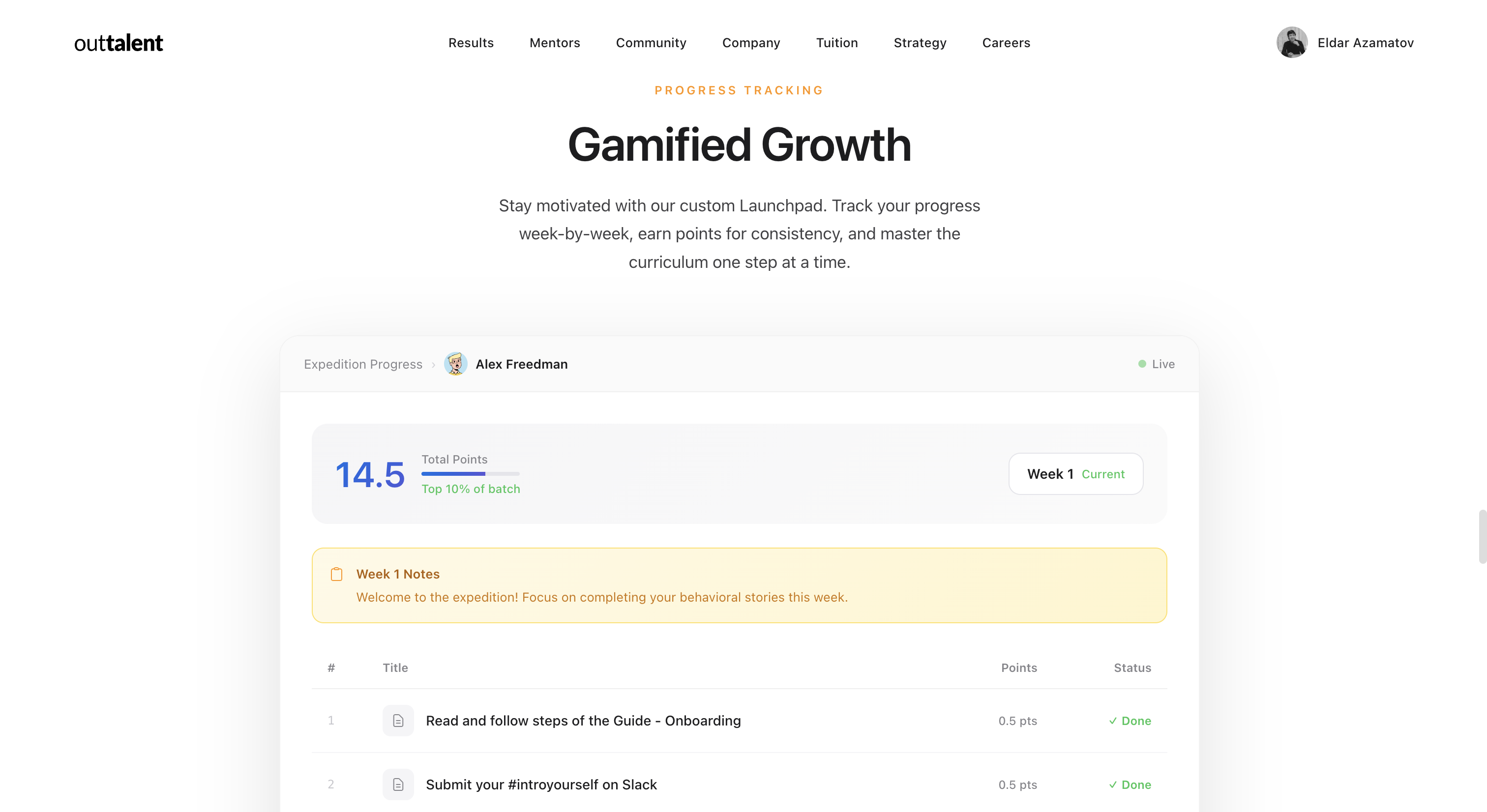

一句话介绍:Outtalent是一款通过结构化面试课程、AI工具及求职流程追踪系统,帮助工程师在竞争激烈的顶级科技公司求职中,更高效地获得面试和更好工作机会的产品。

Hiring

Education

Career

工程师求职

面试辅导

职业发展

AI工具

求职平台

技能提升

社区支持

结构化反馈

科技招聘

求职系统

用户评论摘要:用户反馈积极,认可产品“职业强化器”价值。主要问题集中在价格较高对新手不友好,建议提供更模块化、基础的套餐。另有用户询问与LinkedIn的联动可能性。创始人回应强调了社区与文化的核心价值。

AI 锐评

Outtalent的叙事巧妙地游走在“产品”与“程序”之间,其宣传核心从“工具效率”转向了“人的环境”,这暴露了当前技术求职赛道的真实痛点:信息不对称与系统性支持的缺失,而非单纯的技术能力不足。产品将结构化课程、AI软件与管道追踪打包,试图标准化一个非标过程,野心在于构建一个闭环生态系统。

然而,其面临的核心质疑极具代表性:高定价与目标用户(可能包含资金紧张的求职者)的潜在矛盾。评论中“模块化”的建议一针见血,揭示了标准化产品与个性化需求之间的张力。创始人强调“社区与文化”是真正价值,这既是一种差异化壁垒,也可能是一种风险转移——将部分成功归因于难以量化的软性环境,从而规避工具效果的可衡量性质疑。

真正的挑战在于,它是否真能规模化地复制那个关键的“成功环境”?当用户基数扩大,1对1辅导与紧密社区氛围必然被稀释,届时产品的核心价值是否会从“人与文化”退守回“软件与工具”,从而沦为又一个高级求职工具箱?其AI工具能否提供真正超越市场平均水平的“结构化反馈”,将是衡量其产品力而非社群力的硬指标。它描绘了一个美好愿景,但最终需要证明,其“系统”本身,而非暂时性的密集人力投入,才是可持续的竞争优势。

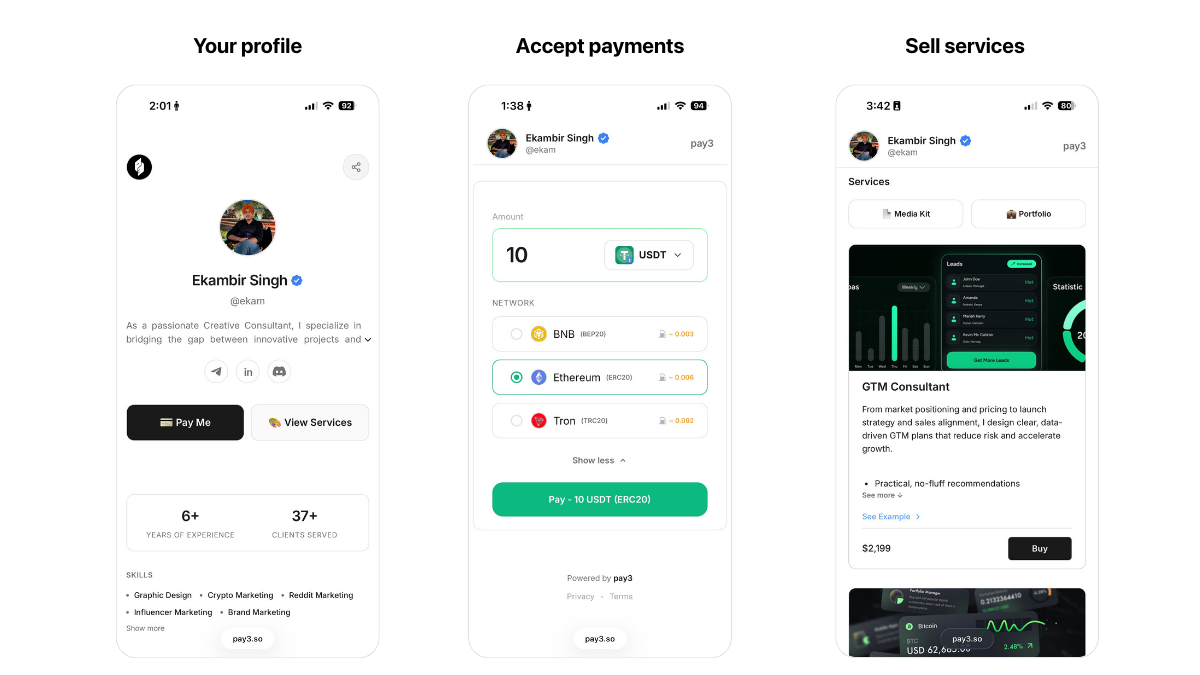

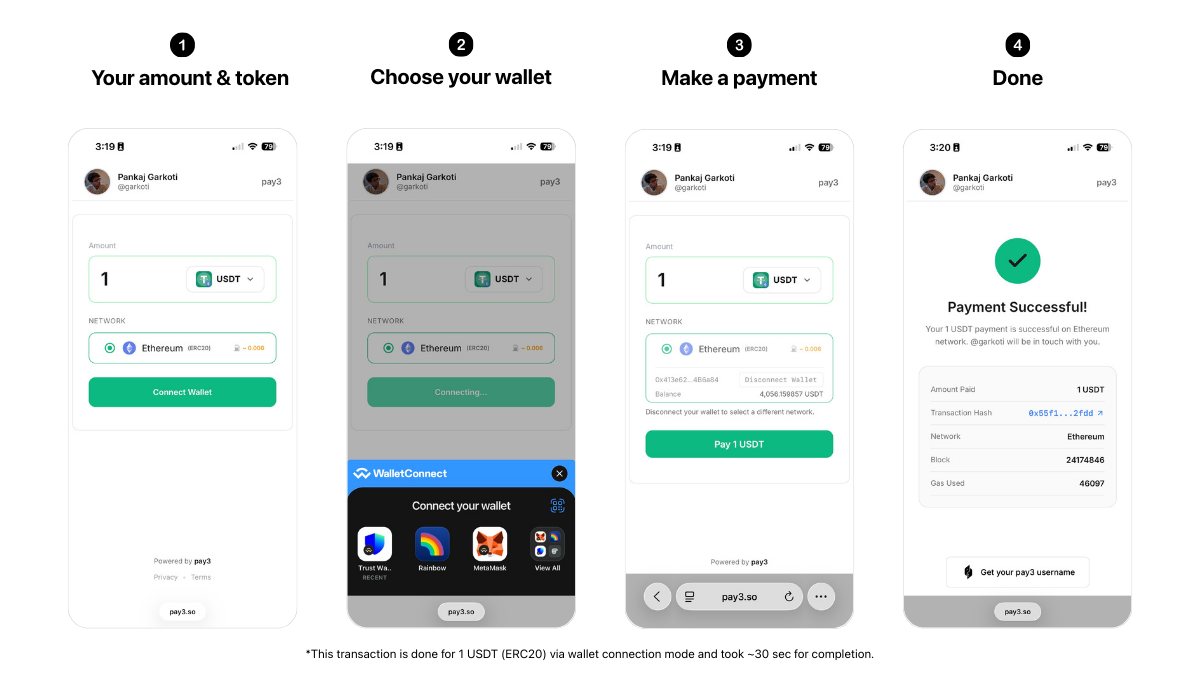

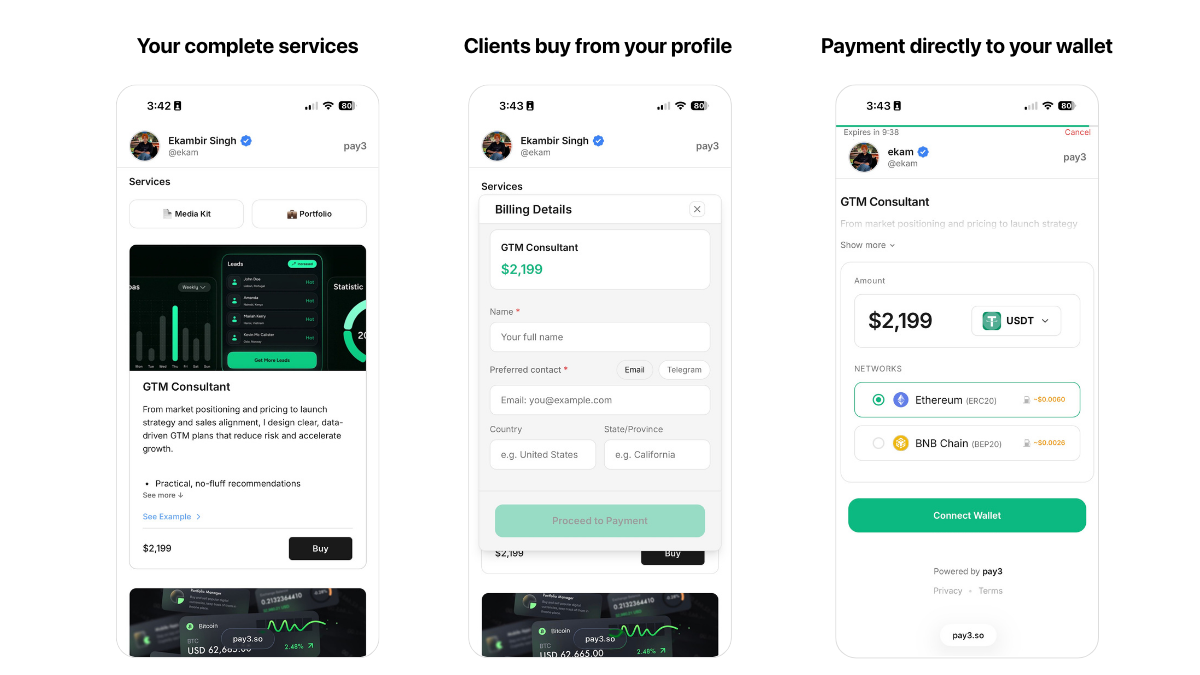

一句话介绍:pay3将复杂的加密货币钱包地址转化为个人专属链接和用户名,在需要便捷、准确收发加密支付的场景下,解决了用户手动复制粘贴长地址易出错、体验割裂的核心痛点。

Payments

Web3

Cryptocurrency

加密货币支付

钱包地址简化

非托管支付

多链聚合

用户体验工具

Web3基础设施

侧项目

个人品牌链接

用户评论摘要:用户反馈主要集中于创始人分享创业故事与产品理念,获得社区初步认可。有效评论仅一条,询问多链地址检测技术细节,创始人回复解释其为基于地址格式的模式匹配,无需链上查询。

AI 锐评

pay3瞄准了一个Web3世界中微小却顽固的“脚趾磕到桌角”式痛点:长且反人类的多链钱包地址。其价值不在于技术创新,而在于体验重构。它本质是一个基于规则映射的“支付路由层”,通过极简的链接将复杂的链、资产和地址信息封装起来,降低了发送方的认知负担与操作风险,也提升了接收方的专业形象。

然而,其“非托管”与“模式匹配”的双刃剑特性值得深究。优势是轻量、快速、无需信任;但隐患也在于此:地址映射完全依赖本地规则库,一旦用户错误添加了不兼容的地址(如将Solana地址用于接收ETH),或目标链出现新地址格式,资金损失风险将由用户自行承担。产品将自己严格定义为“管道”而非“钱包”或“交易所”,巧妙规避了监管与托管风险,但也将最核心的安全责任完全剥离。

在“社交支付”与“链抽象”成为趋势的当下,pay3的形态是讨巧的MVP。但其长期天花板清晰:一是依赖个人链接的传播,网络效应有限;二是功能单薄,易被集成钱包或社交应用的功能更新所覆盖;三是商业模式模糊。它更像一个精美的概念验证,证明了Web3基础体验的粗糙,但要从“有用的小工具”进化为“不可或缺的基础设施”,仍需在地址安全验证、社交图谱集成乃至轻量级法币通道等方面构建更深的护城河。当前版本,是一位资深从业者对行业痼疾的一次优雅吐槽与极简回应。

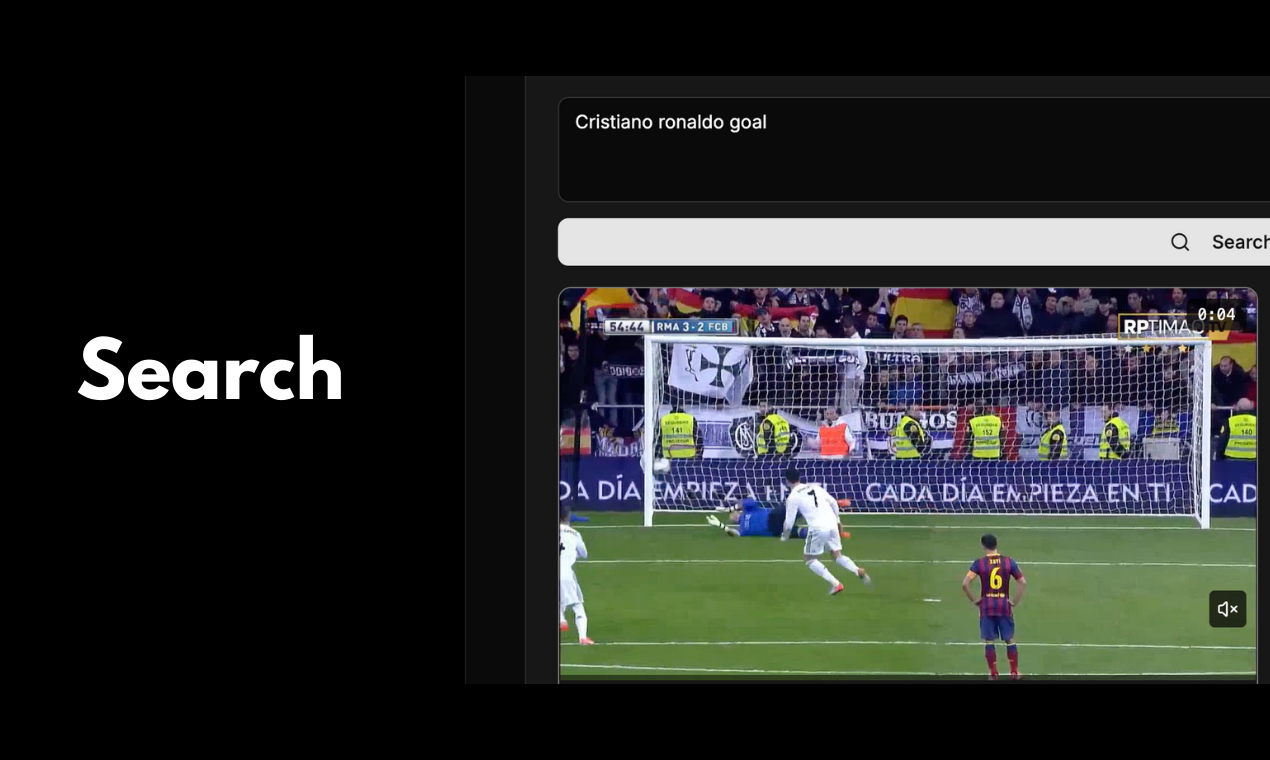

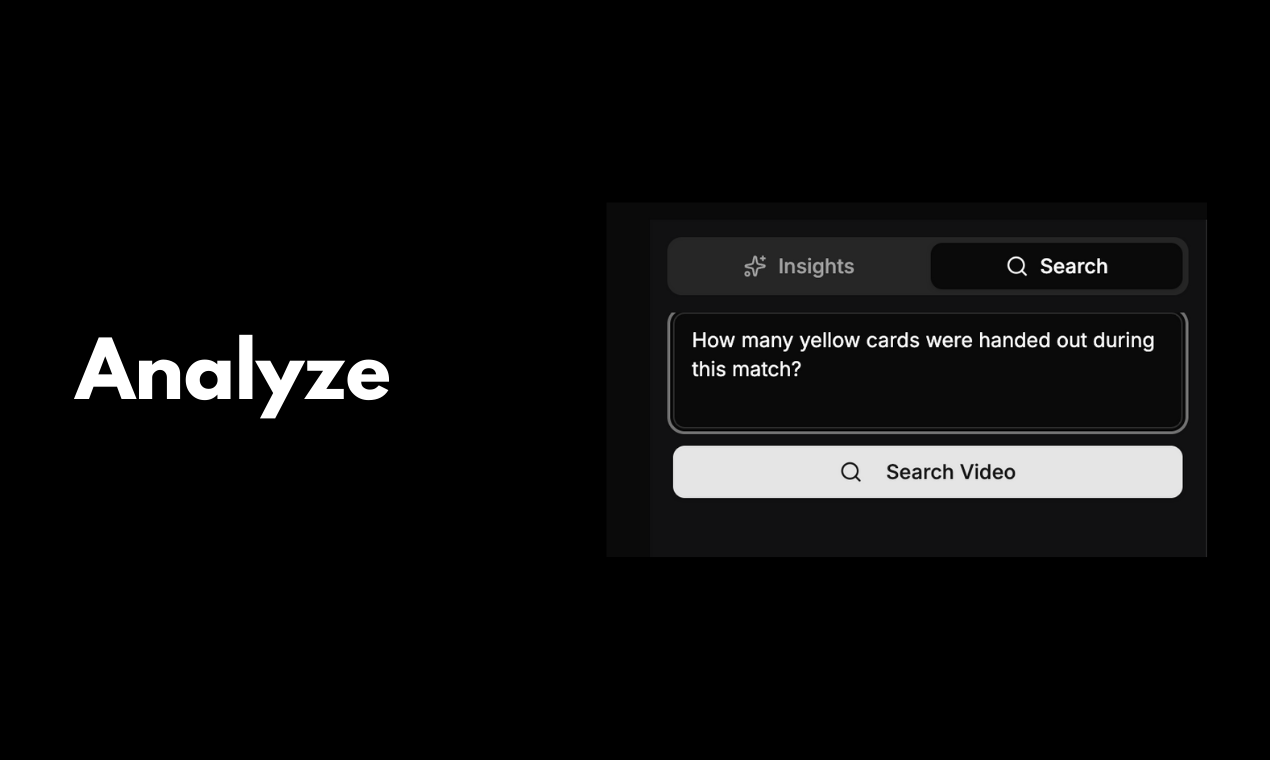

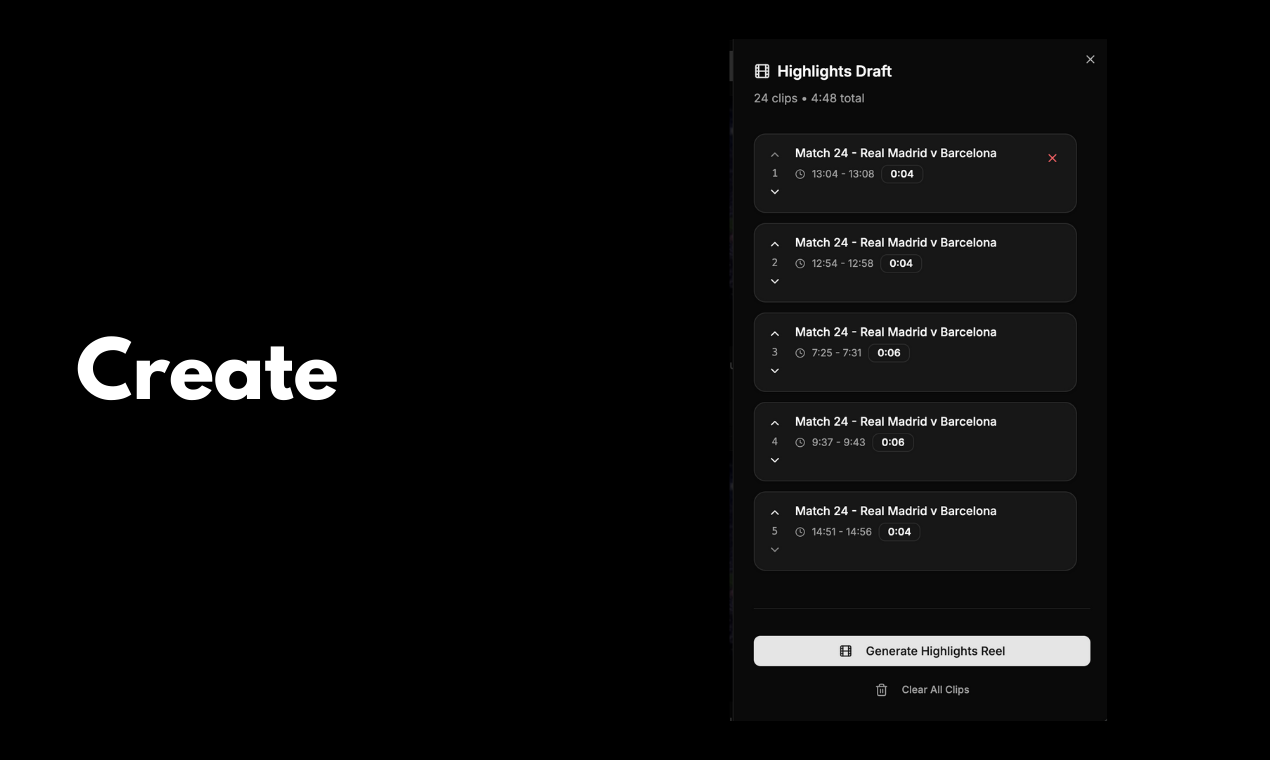

一句话介绍:一款AI驱动的体育内容创作平台,通过自动分析比赛录像、识别关键镜头并快速生成集锦,解决了体育创作者手动剪辑耗时费力的核心痛点。

Sports

Artificial Intelligence

Video

AI视频剪辑

体育集锦生成

内容创作工具

视频分析

自动化工作流

体育科技

社交媒体内容

游戏录像

创作者经济

效率工具

用户评论摘要:用户反馈强烈认同产品解决的“手动逐帧寻找精彩镜头”的痛点,认为能极大节省时间。同时提出产品潜力可扩展至影视剧等非体育领域,用于寻找“梗”素材。

AI 锐评

GameCutAI精准切入了一个垂直且明确的利基市场——体育内容创作的后端生产环节。其宣称的价值并非技术创新上的颠覆,而是工作流效率的“降维打击”。它将传统非线性编辑中高度依赖人力、经验和时间的“浏览-识别-标记-剪切-输出”链条,压缩为“上传-分析-生成”的一键式操作。真正的价值不在于AI识别是否比人眼更懂体育,而在于将创作者从重复、枯燥的机械劳动中解放出来,使其能量集中于更具创造性的叙事、包装与分发环节。

然而,其面临的挑战同样清晰。首先,技术壁垒有限,核心的“视频动作识别与精彩度判断”算法是计算机视觉的成熟应用,易被巨头复刻或集成。其次,市场天花板明显,重度用户集中于专业或半专业的体育团队、俱乐部和媒体机构,普通用户需求频次低。评论中“拓展至影视找梗”的思路虽有趣,但实则是另一个需求分散、标准模糊的战场。

产品的生存关键,在于能否在垂直领域内建立极致的体验壁垒和精准的数据飞轮。即:通过服务专业客户,持续优化特定运动(如篮球、足球、电竞)的识别准确度与场景理解深度,形成领域知识护城河。它不应止步于一个“剪辑工具”,而应演进为一个“体育内容数据中台”,将视频素材转化为可搜索、可结构化利用的数据资产。否则,它很可能只是一个在巨头缝隙中昙花一现的“好用工具”,而非一个具备持久生命力的独立产品。

一句话介绍:FireSEO MCP是一款MCP工具,它将Google Search Console等真实SEO数据直接接入Claude或Cursor等AI编辑器,让开发者或内容创作者能在编码或写作的上下文中,通过自然语言对话实时分析排名、诊断问题并获取修改建议,解决了工作流中频繁切换工具和界面的效率痛点。

Analytics

Marketing

SEO

SEO优化工具

AI工作流集成

MCP协议

谷歌搜索控制台

实时数据分析

智能代码编辑

开发者工具

竞品分析

自然语言交互

Agentic SEO

用户评论摘要:用户反馈积极,认可其减少上下文切换的核心价值。主要问题集中在:与现有AI编辑器规则的本质区别(数据驱动 vs 规则指导)、如何避免API速率限制和保证建议安全性、以及目标用户(创始人)是否具备提出正确SEO问题的能力。开发者回应强调了基于真实数据与仅凭知识库的本质优势。

AI 锐评

FireSEO MCP的亮相,与其说是一款新工具,不如说是一次对“AI赋能工作流”的精准切片。它没有选择做大而全的SEO平台,而是巧妙地押注在MCP协议和“AI原生编辑器”这两个新兴交汇点上,试图将SEO从“监测-分析-行动”的滞后性循环,压缩成在开发环境中的即时问答。

其宣称的“Agentic SEO”是核心叙事,但需冷静审视。产品真正的价值不在于替代Ahrefs或SEMrush这类数据航母,而在于充当一个“数据管道”和“语境翻译器”。它将GSC的原始数据流引入AI对话窗口,试图消除从看到数据到理解问题再到实施代码/内容修改之间的摩擦。这瞄准了一个真实痛点:对开发者或技术型创作者而言,切换至SEO仪表盘本身就是心流中断。

然而,评论中的犀利问题戳中了其商业化与实用化的潜在软肋。首先,其价值深度严重依赖用户提问的能力,这对于其预设的“创始人”目标群体可能是个门槛,产品可能需要内置更主动的诊断框架。其次,将SEO建议直接关联代码修改是一把双刃剑,若无严谨的变更影响评估(如对页面性能、结构的潜在负面作用),所谓的“Agentic”可能带来不可控风险。最后,其技术护城河目前建立在MCP的接入便利性上,一旦大型SEO平台或编辑器自身开放类似深度集成,其独特性将面临挑战。

总体而言,这是一个极具前瞻性场景构思的利基产品。它能否从“炫酷的演示”成长为“必需的工作流”,取决于它能否将“数据接入”深化为“可靠的决策智能”,并在易用性与安全性上构建足够厚的壁垒。当前版本更像是一个充满潜力的“副驾驶”原型,而远非全自动的SEO飞行员。

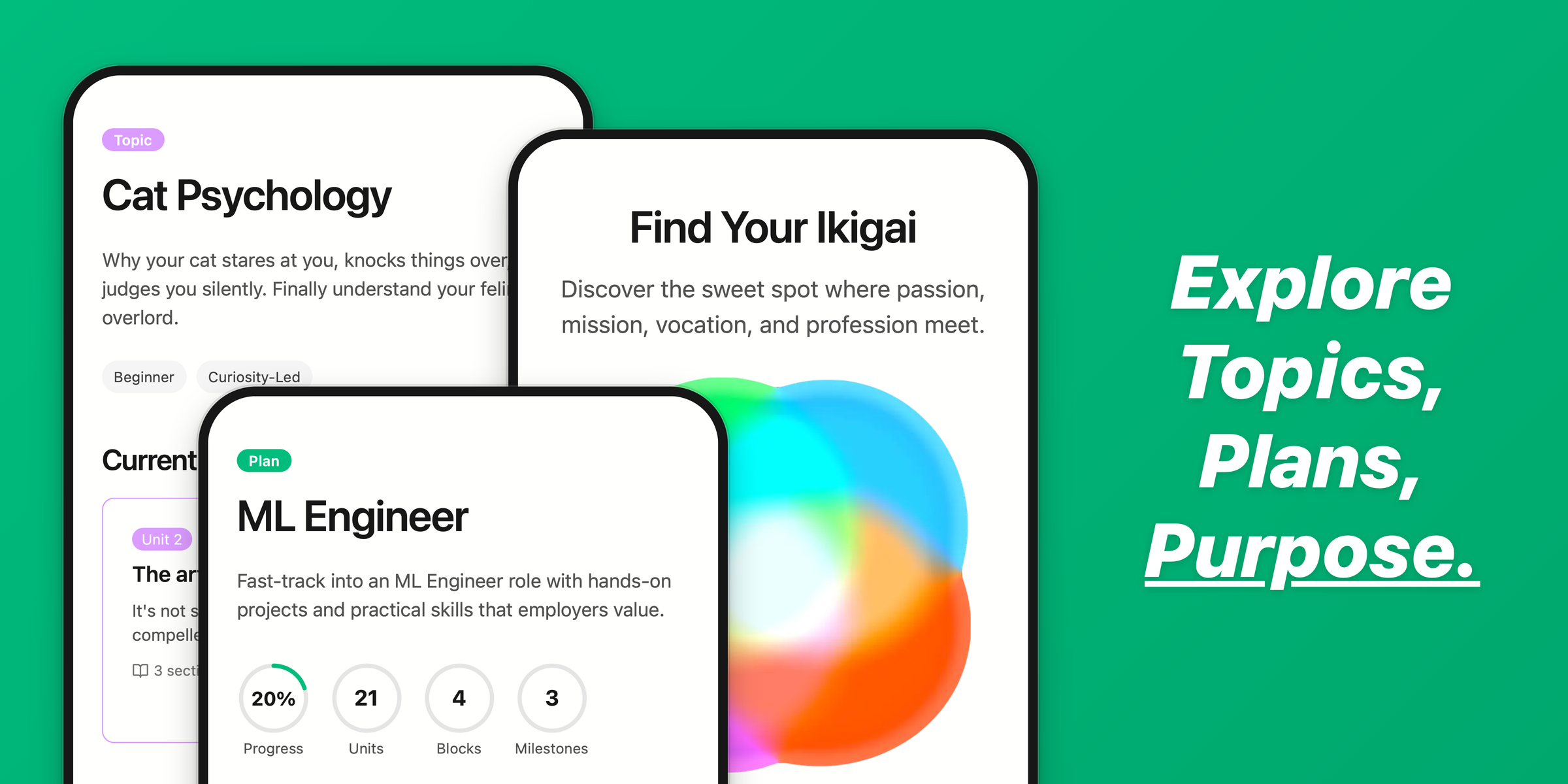

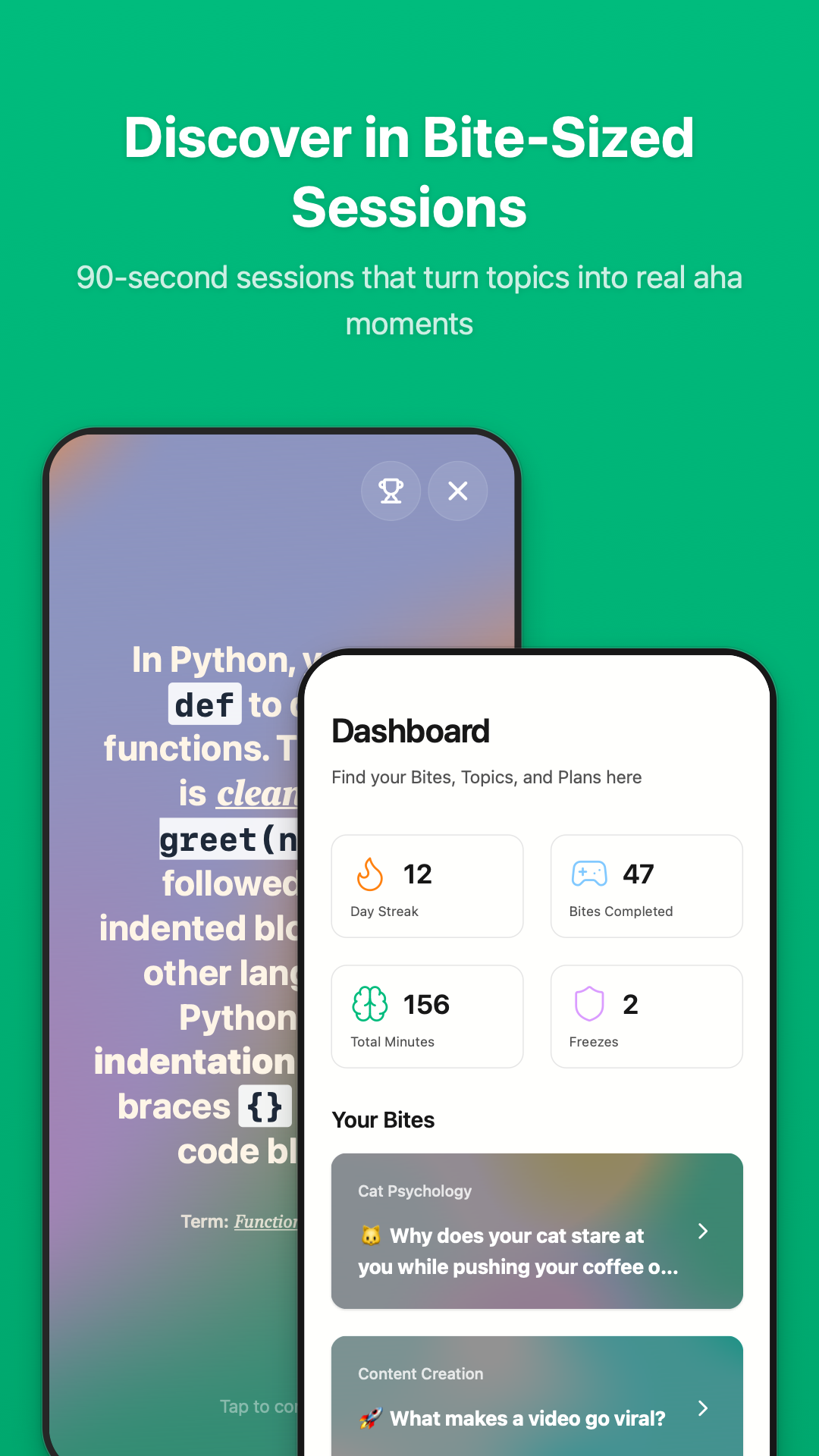

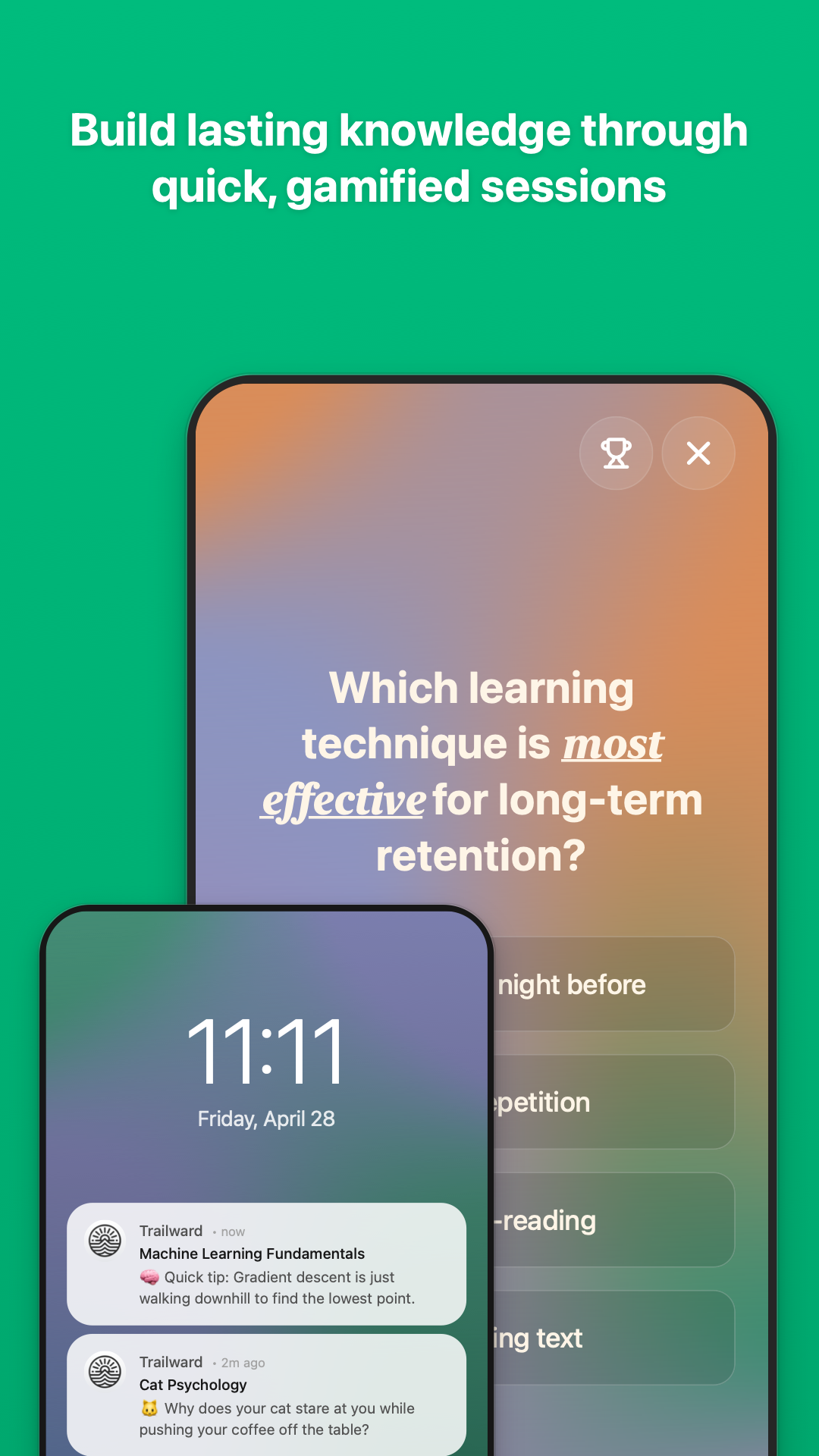

一句话介绍:Trailward通过90秒游戏化微课程,在碎片化时间场景下,解决了用户因学习门槛高、时间不足或动力缺乏而难以开启和坚持新领域学习的痛点。

Productivity

Education

Career

微学习

游戏化学习

知识碎片化

职业规划

兴趣探索

移动学习

习惯养成

个性化推荐

终身学习工具

快速入门

用户评论摘要:用户普遍赞赏其简洁设计和个性化推荐。主要建议集中在增加音频/视频格式以缓解阅读疲劳,并优化初始问卷长度。创始人回应确认音频功能正在开发中,并阐述了产品核心是降低学习启动门槛、对抗拖延症。

AI 锐评

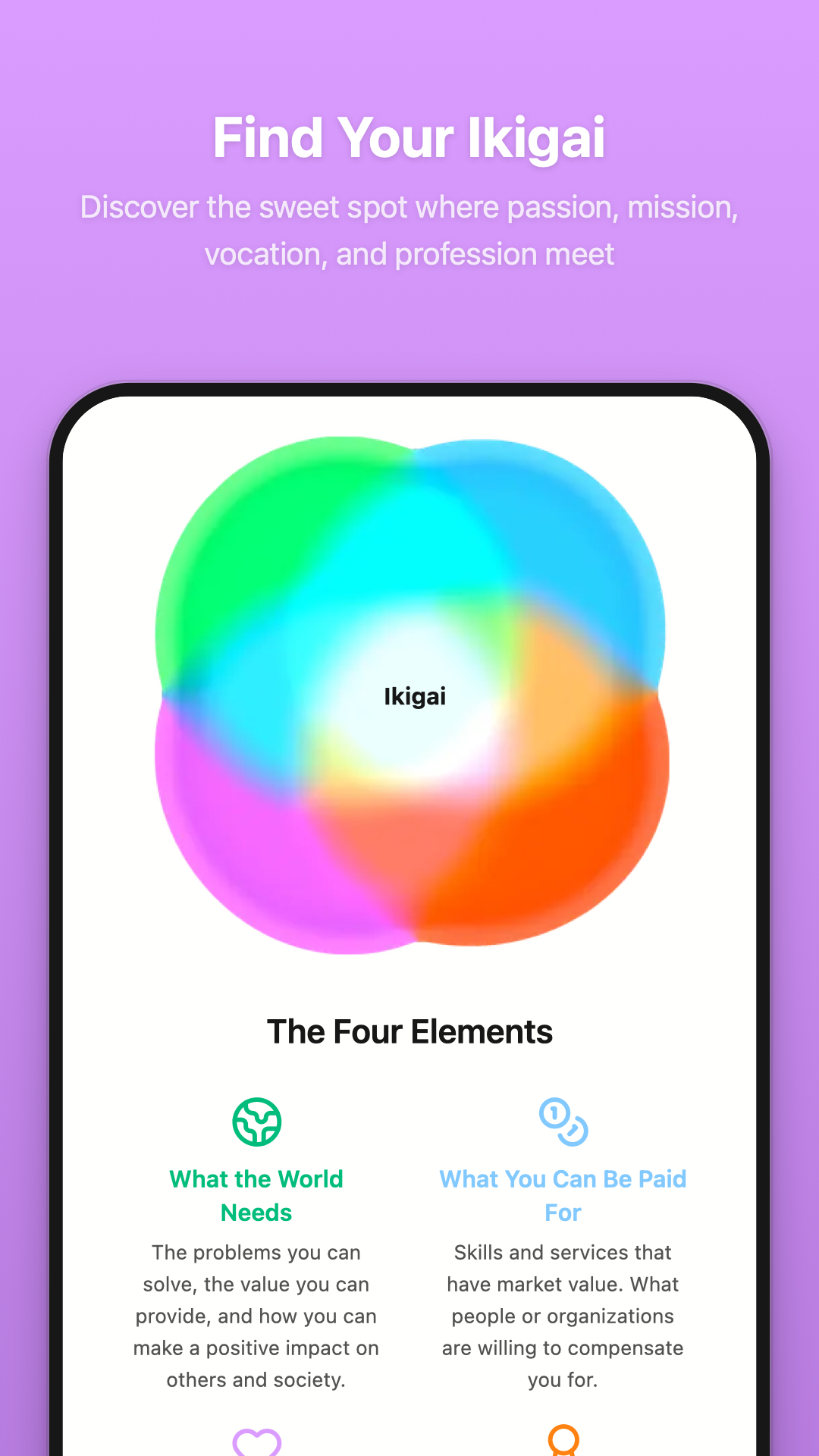

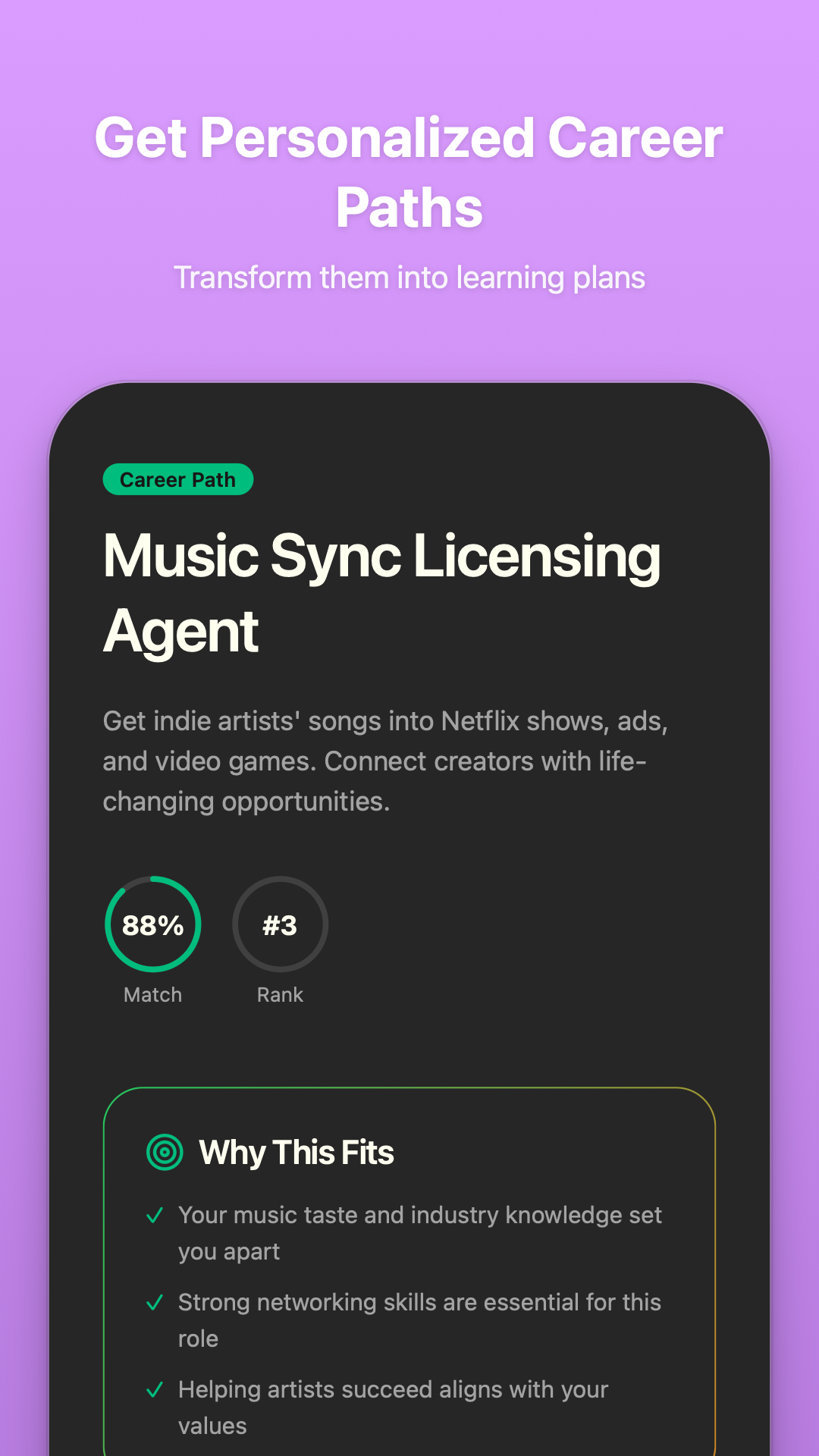

Trailward的核心理念并非“深度学习”,而是“学习启动”。它敏锐地捕捉到现代人知识焦虑与行动瘫痪之间的根本矛盾:渴望学习却败于庞大的课程体系与时间承诺。其真正价值在于,将“学习”这一沉重行为解构为无压力的90秒“Bites”,通过游戏化与即时反馈,完成从“零到一”的心理突破,本质上是为“后续深度学习”制造“上瘾”的钩子。

产品巧妙地融合了两个关键模块:碎片化微课与Ikigai职业路径规划。前者负责提供即时、低负担的正反馈,后者则负责赋予长期意义感,试图将随机的兴趣点击串联成有方向的学习叙事。这种结合颇具野心,但也埋下隐患:微学习的“浅尝辄止”属性与职业路径所需的“系统深度”之间存在天然张力。评论中暴露的“阅读疲劳”和“问卷过长”问题,正是这种张力在用户体验层面的体现——产品在试图平衡“轻量启动”与“深度个性化”时出现的摩擦。

创始人坦诚这是对抗“拖延症”的工具,这一定位反而比“学习平台”更精准、更具洞察力。它的成功与否,不取决于内容库的广度,而取决于其算法能否在用户几次“Bite”后,精准推送那个让用户愿意投入更长时间的关键兴趣点,完成从“打发时间”到“投入时间”的惊险一跃。目前看来,其模式更偏向于高效的兴趣探索与过滤工具,而非知识沉淀容器。若音频功能能如期优化,并有效管理用户对“AI生成内容质量”的疑虑,它有望成为信息过载时代一个高效的“学习决策引擎”。

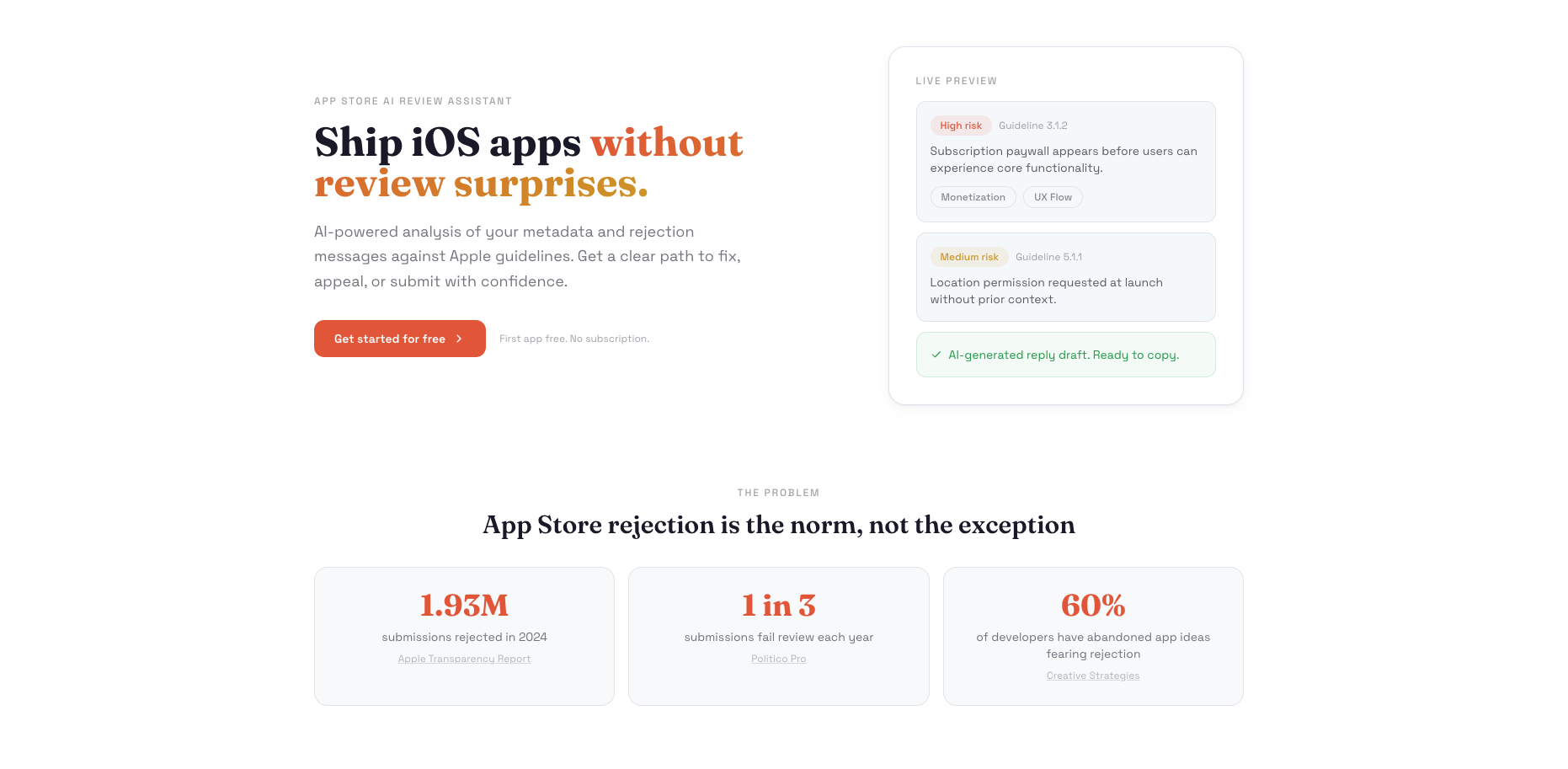

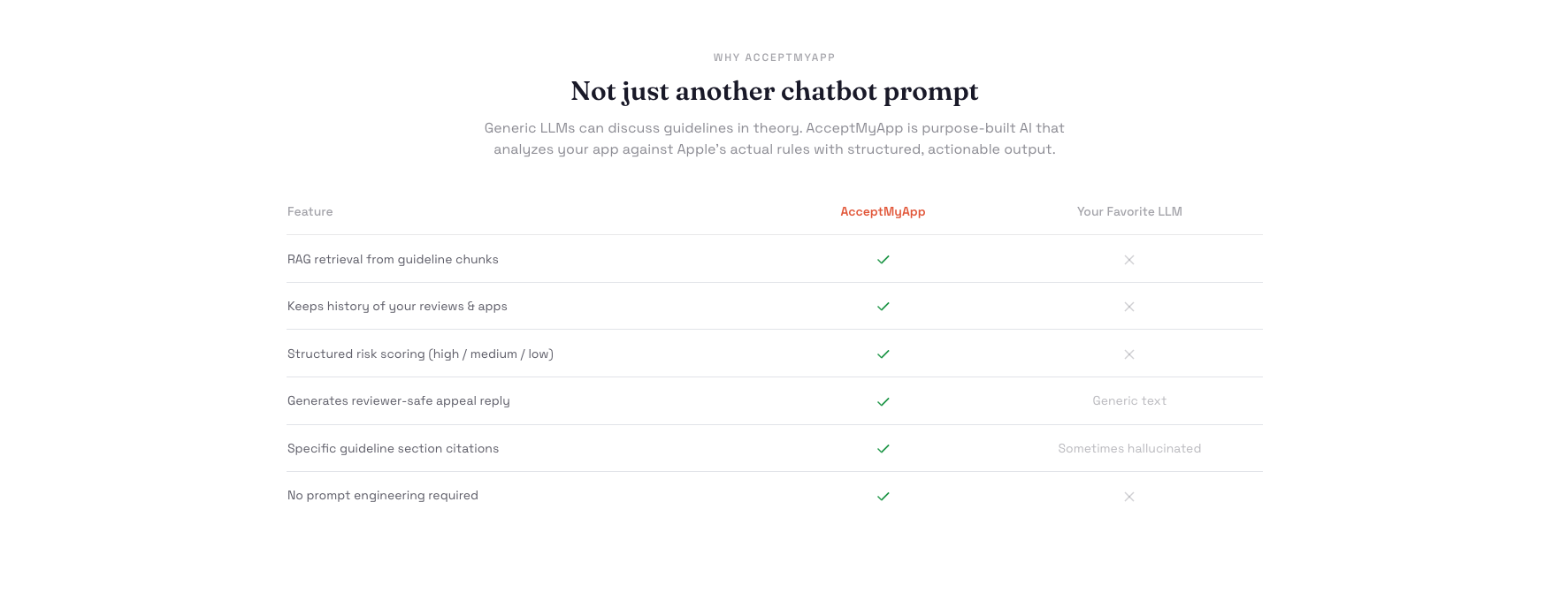

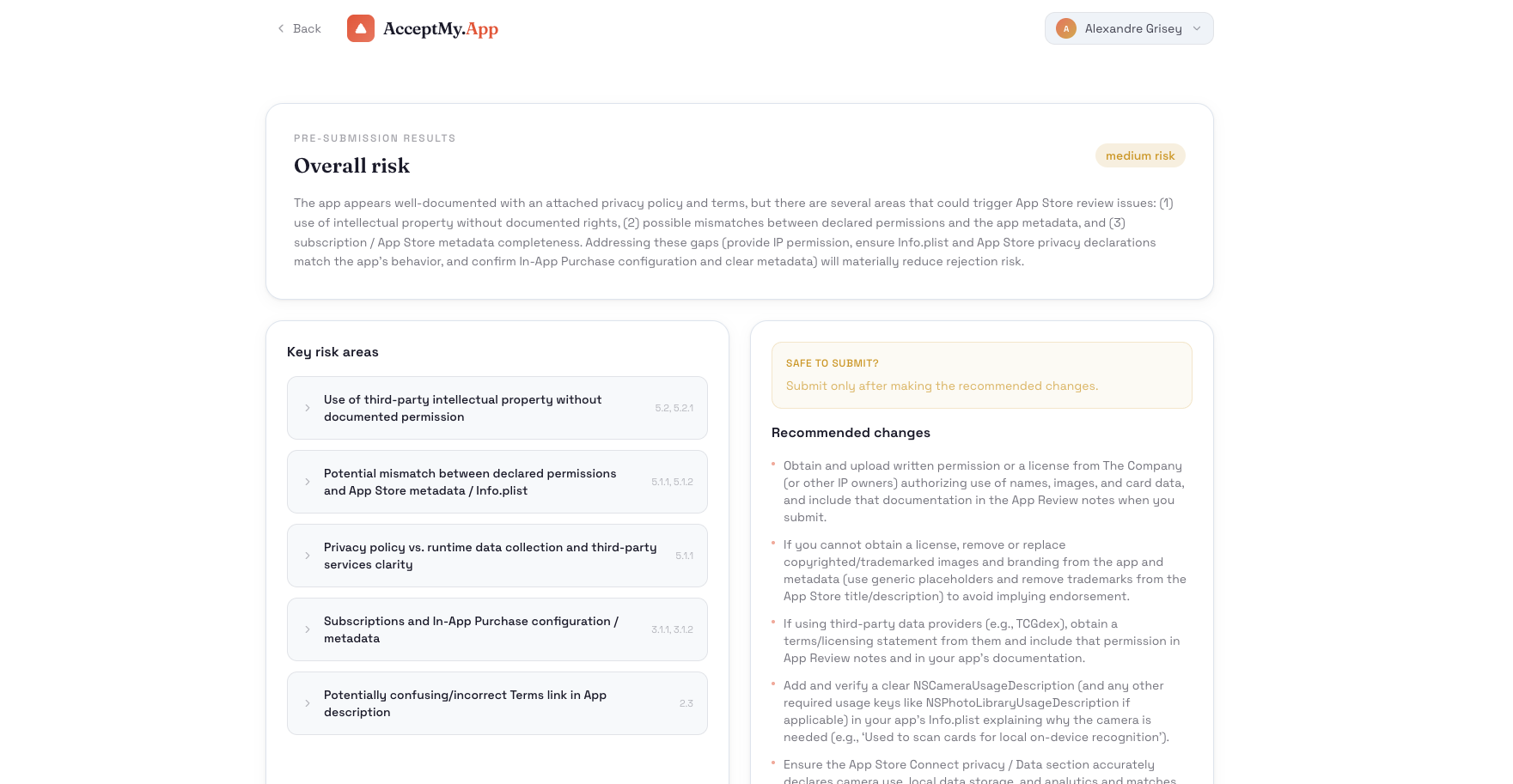

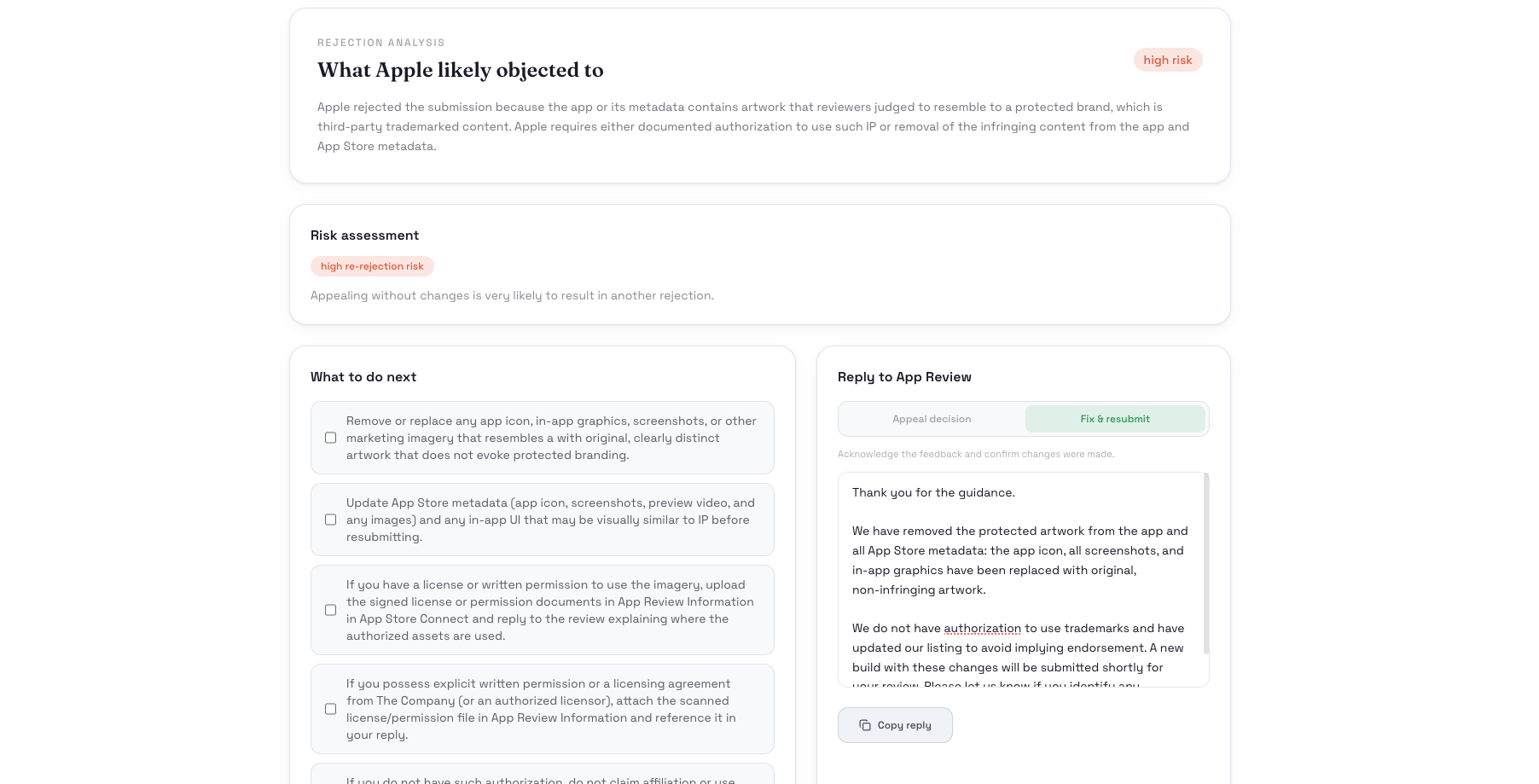

一句话介绍:一款帮助iOS开发者在应用提交前扫描潜在审核风险、被拒后提供结构化修复方案和回复草案的AI工具,旨在终结与苹果App Store审核团队之间模糊、耗时的拉锯战。

iOS

Apple

iOS应用审核

预提交扫描

审核被拒分析

开发者工具

AI合规检查

RAG应用

一次性付费

App Store指南

效率工具

风险规避

用户评论摘要:用户普遍对苹果审核过程的模糊性和低效感到挫败,认为该工具精准击中了痛点。反馈积极,肯定其“独特”性和实用性,并有多人表示愿意尝试。创始人互动积极,强调解决审核挫折的初衷,并推广免费名额。

AI 锐评

AcceptMyApp的价值,远不止于一个“基于Apple Guidelines的RAG系统”。它本质上是在试图将苹果App Store那套不透明、充满主观解释且沟通成本极高的审核黑盒,进行“白盒化”和“流程化”改造。

其真正锋芒在于两个层面:首先是**风险前置**。将开发者事后被拒的被动补救,转变为事前的主动规避。通过扫描元数据、条款等,它试图将审核员的隐性评判标准提前暴露,这直接提升了开发迭代的确定性和效率。其次是**对抗审核沟通的模糊性**。当被拒发生时,它提供的不是笼统的指南编号,而是结构化的问题拆解、修复清单,最关键的是“审核员安全”的回复草案。这相当于为单兵作战的开发者提供了一个专业的“合规外脑”和“谈判助手”,大幅提升了申诉的胜算与专业性。

然而,其深层挑战与价值并存。产品的天花板取决于其对苹果审核指南动态变化的追踪解读能力,以及对其背后“人治”因素的把握程度。审核指南是文本,但审核员的判断常涉及意图、设计哲学等灰色地带,AI能否持续精准捕捉?此外,其“一次性付费”模式虽对开发者友好,但如何持续覆盖模型更新、指南同步的成本,是其商业可持续性需要验证的一点。

总体而言,这是一款在特定垂直领域极具洞察力的AI应用。它没有追逐泛化的聊天机器人,而是将AI的解析、生成能力深度嵌入到一个高痛点的专业工作流中,解决了真实、迫切的商业效率问题。它的成功与否,将成为检验AI在垂直领域能否真正提供稳定、可靠专业服务的关键试金石。

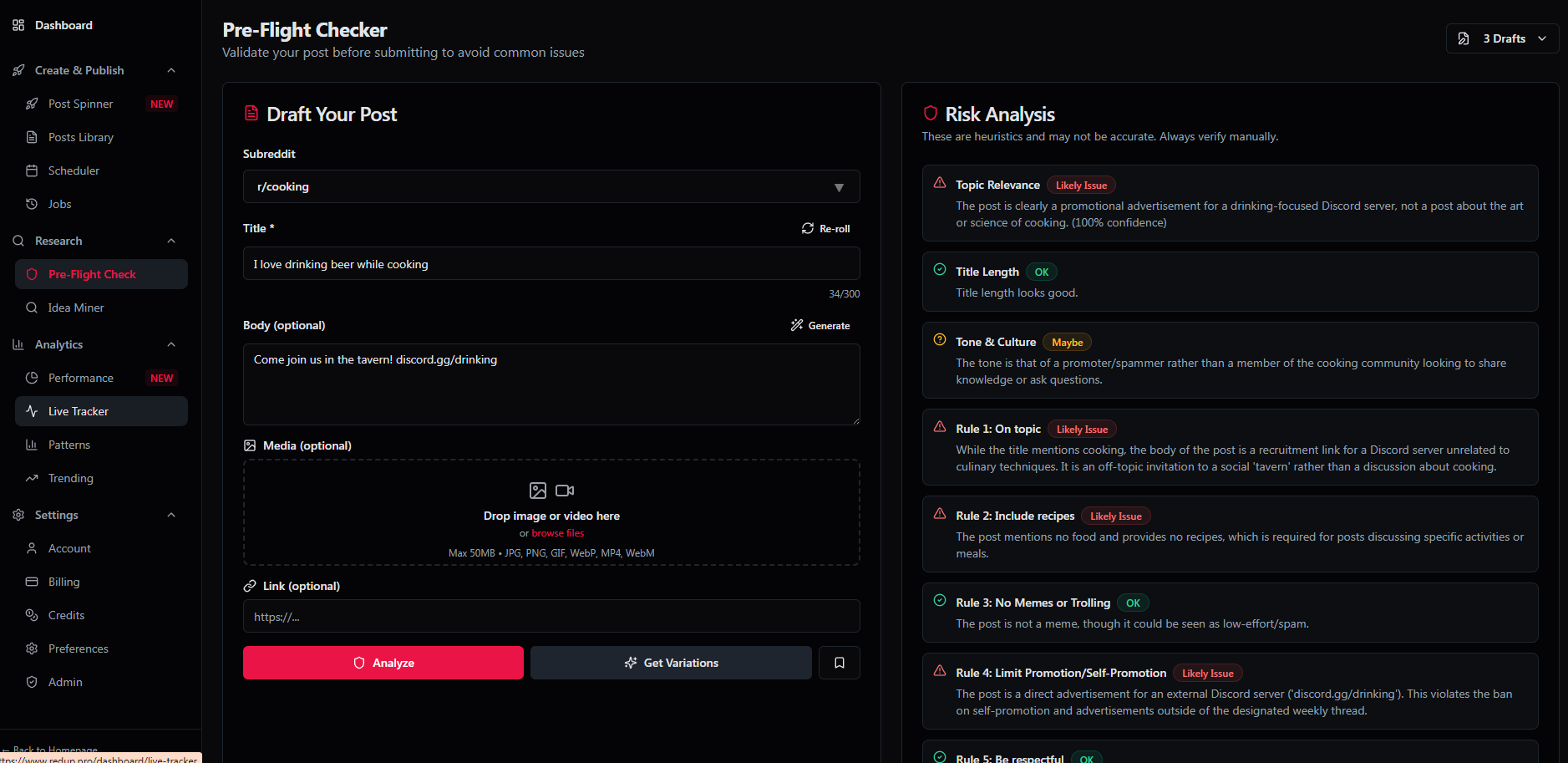

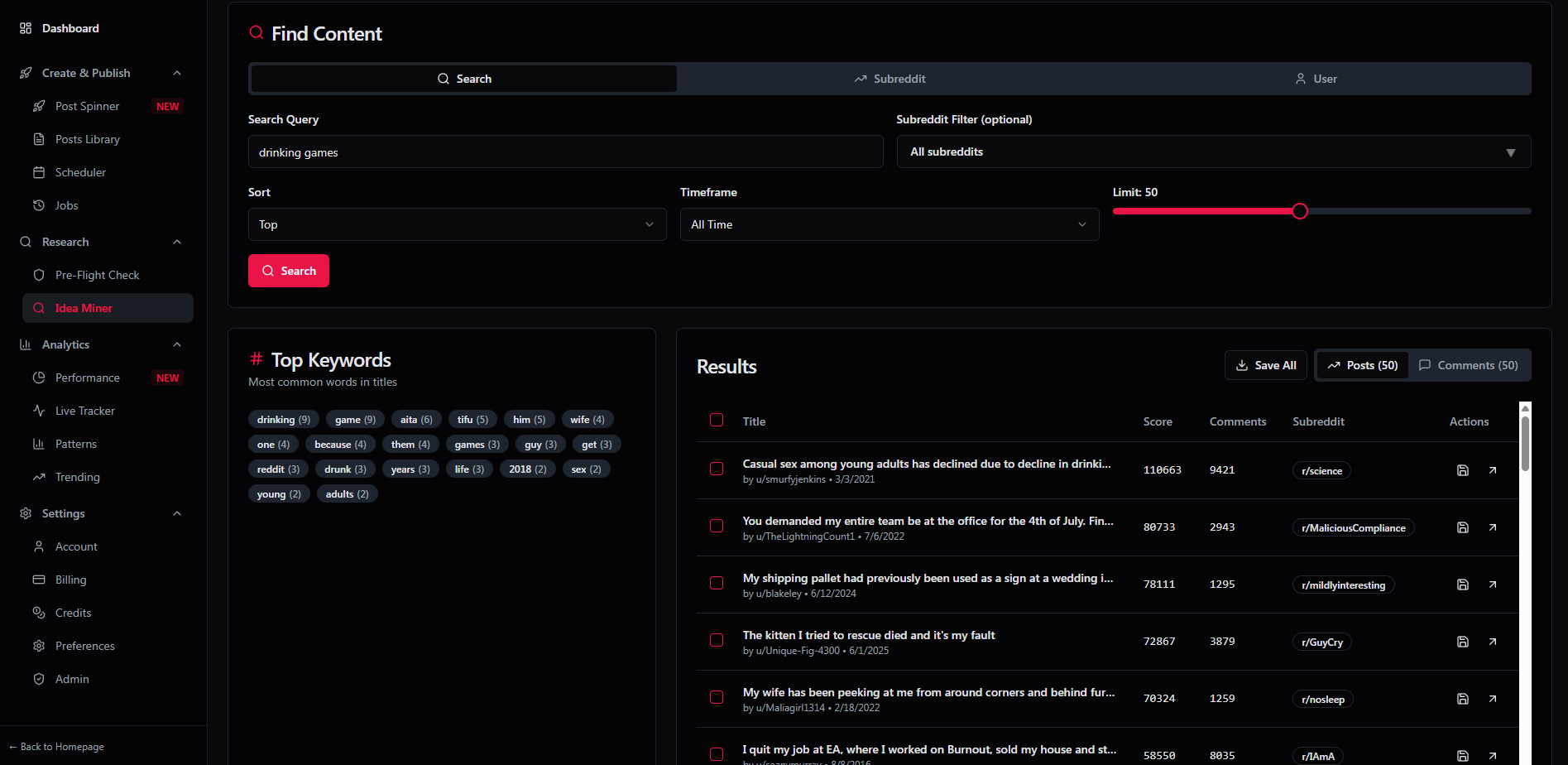

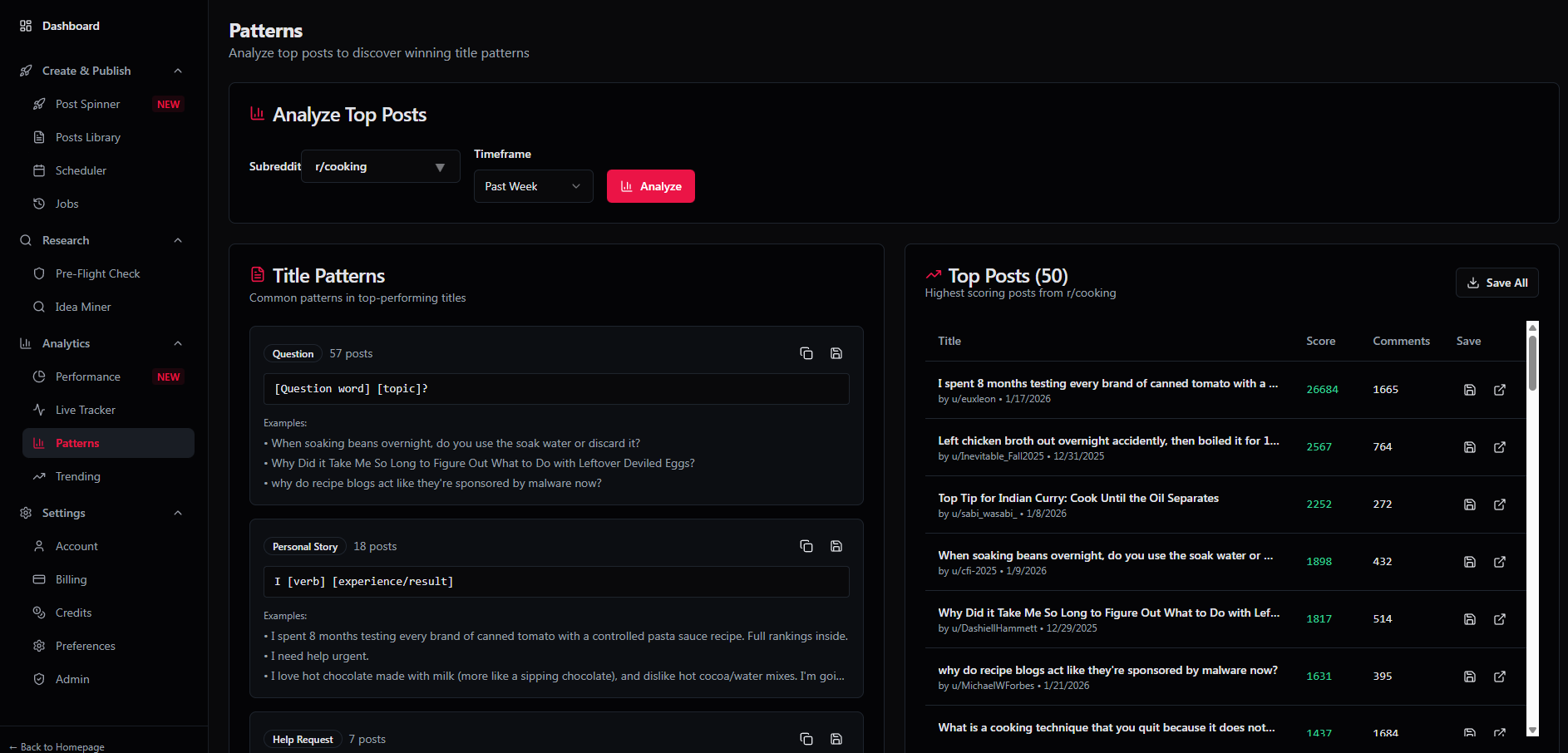

一句话介绍:RedUp.pro 是一款为创作者、营销者和开发者设计的AI驱动平台,通过提供符合Reddit社区规则的安全发帖、智能调度与分析功能,解决了在Reddit进行规模化营销时易被封号、效率低下的核心痛点。

API

Social Media

Marketing

Reddit营销工具

AI内容生成

社交媒体管理

多账号调度

社区安全发帖

增长黑客

SaaS平台

API集成

市场发现

数据分析

用户评论摘要:开发者强调现有工具差且易导致封号,RedUp以安全为核心差异点。用户质疑其“避免封号”声明的可靠性,关注预检系统是否真正模拟社区规则。开发者回复称系统会检测规则、社区氛围及帖子类型,以提供匹配建议。

AI 锐评

RedUp.pro 试图在Reddit营销工具这片红海中,打出“安全”这张技术牌与信任牌,这确实切中了行业最敏感的神经。当前多数第三方工具因粗暴对待Reddit的社区生态(如滥用跨社区发帖、忽视规则差异)而导致账号批量被封,RedUp提出的“社区氛围检测”和“预检系统”在理念上是一种进步,它承认Reddit不是一个统一的广场,而是成千上万个拥有独立文化和规则的小城镇。

然而,其宣称的“无封号风险”是一个极其大胆且危险的承诺。Reddit的反垃圾邮件算法是动态、复杂且不透明的,任何外部平台都无法100%模拟或保证。其真正的价值可能不在于彻底消除风险,而在于通过流程化(如发帖类型选择、节奏控制)和数据分析(子社区活动洞察)将用户的“盲操作”转化为“可观测、可优化的策略”,从而显著降低风险概率。这更像是一个“风险管控平台”,而非“免死金牌”。

另一个潜在亮点是“真正的API”。如果其API能稳定、合规地提供发帖与数据能力,将吸引开发者构建更垂直的解决方案,这可能成为其构建生态壁垒的关键。但这一切的前提是RedUp自身能长期维持其账号体系的健康度,并与Reddit平台保持一种微妙的、不被认定为敌对的关系。总体而言,这是一个针对专业用户、定位清晰的产品,但其最大的卖点恰恰是其未来可能面临的最大挑战——与平台方的博弈。成功与否,取决于其安全模型的技术深度,以及是否能在增长与合规间找到可持续的平衡点。

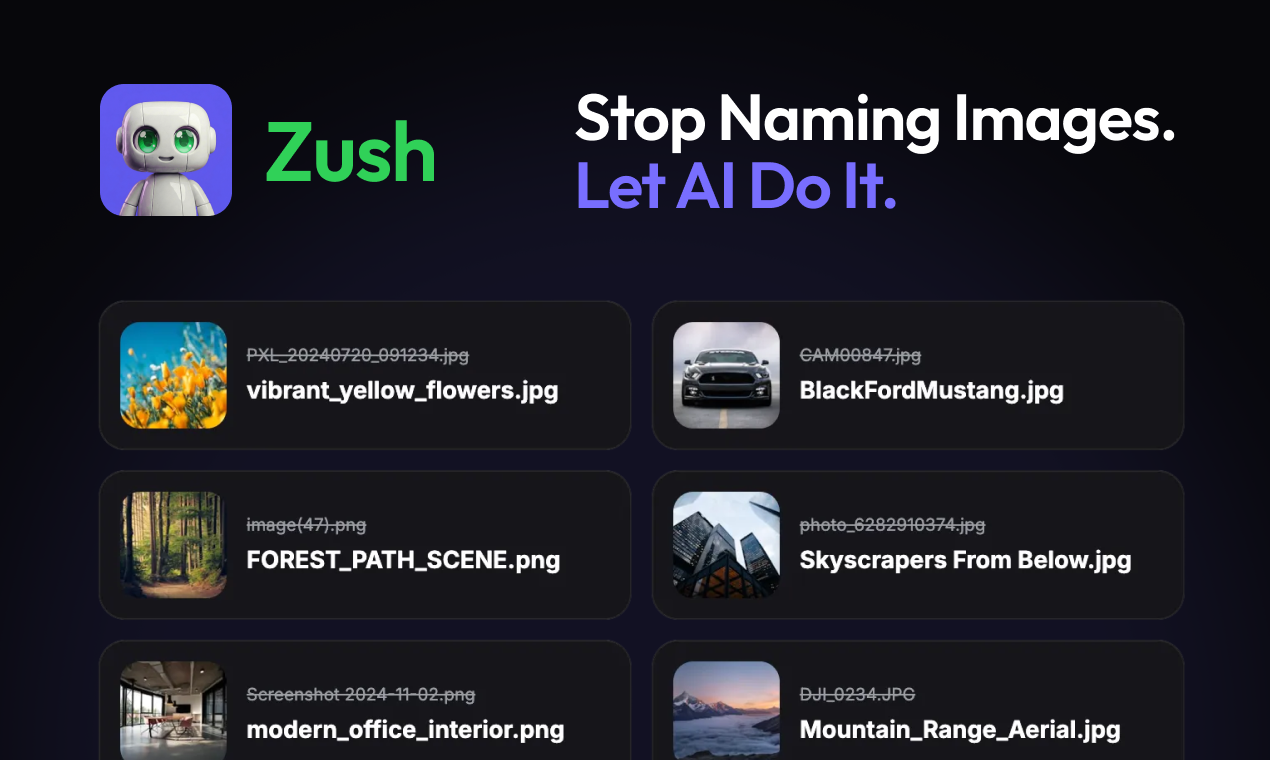

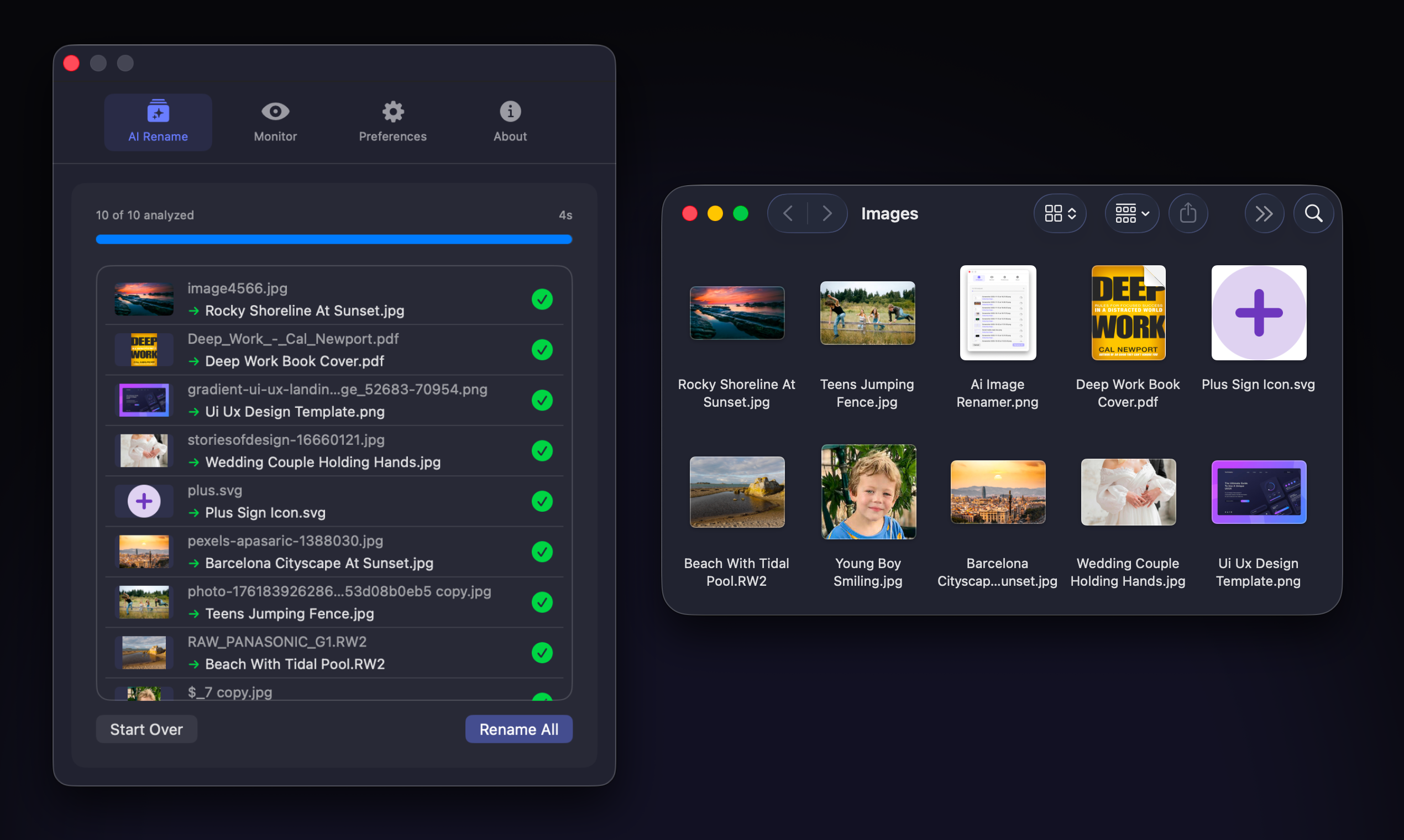

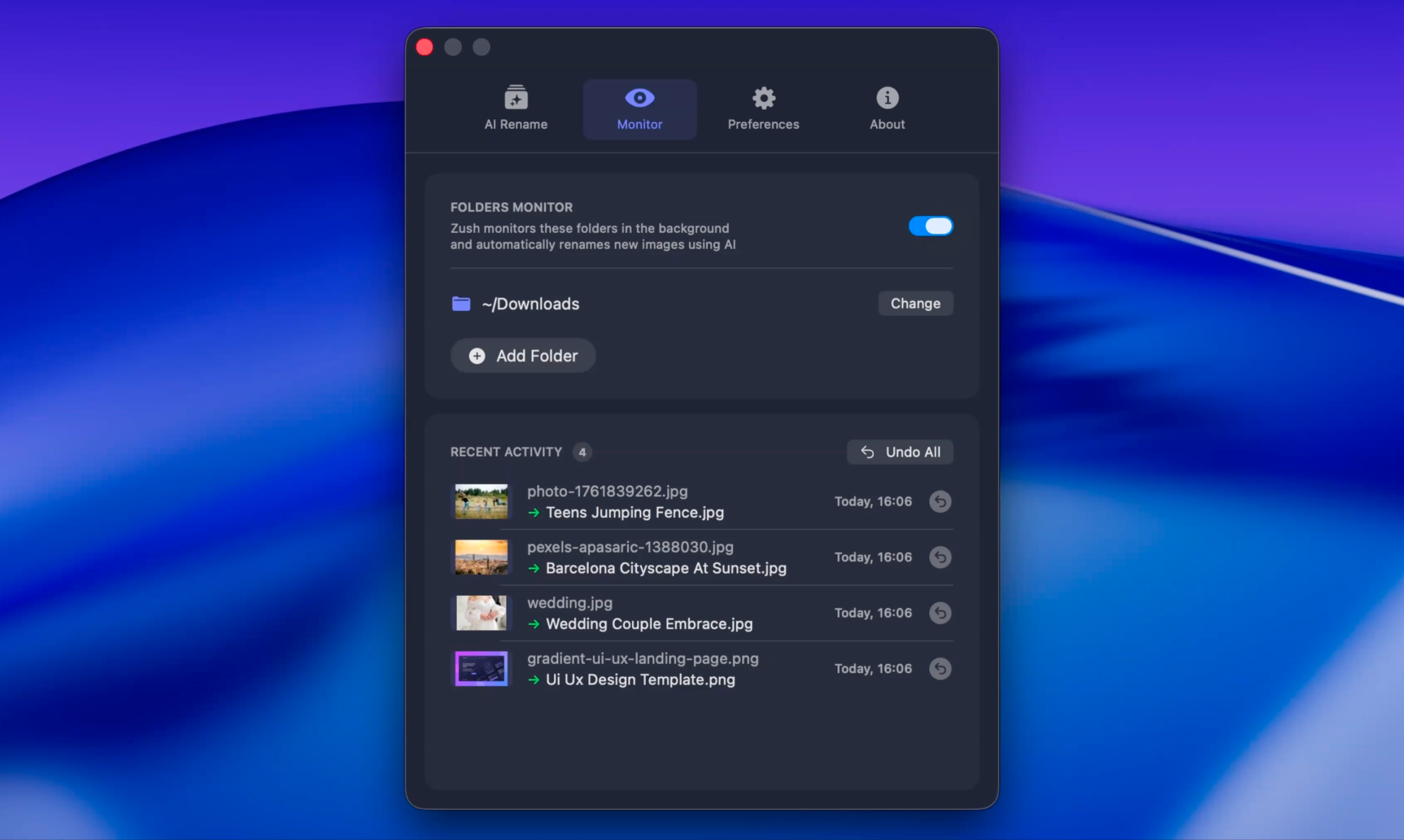

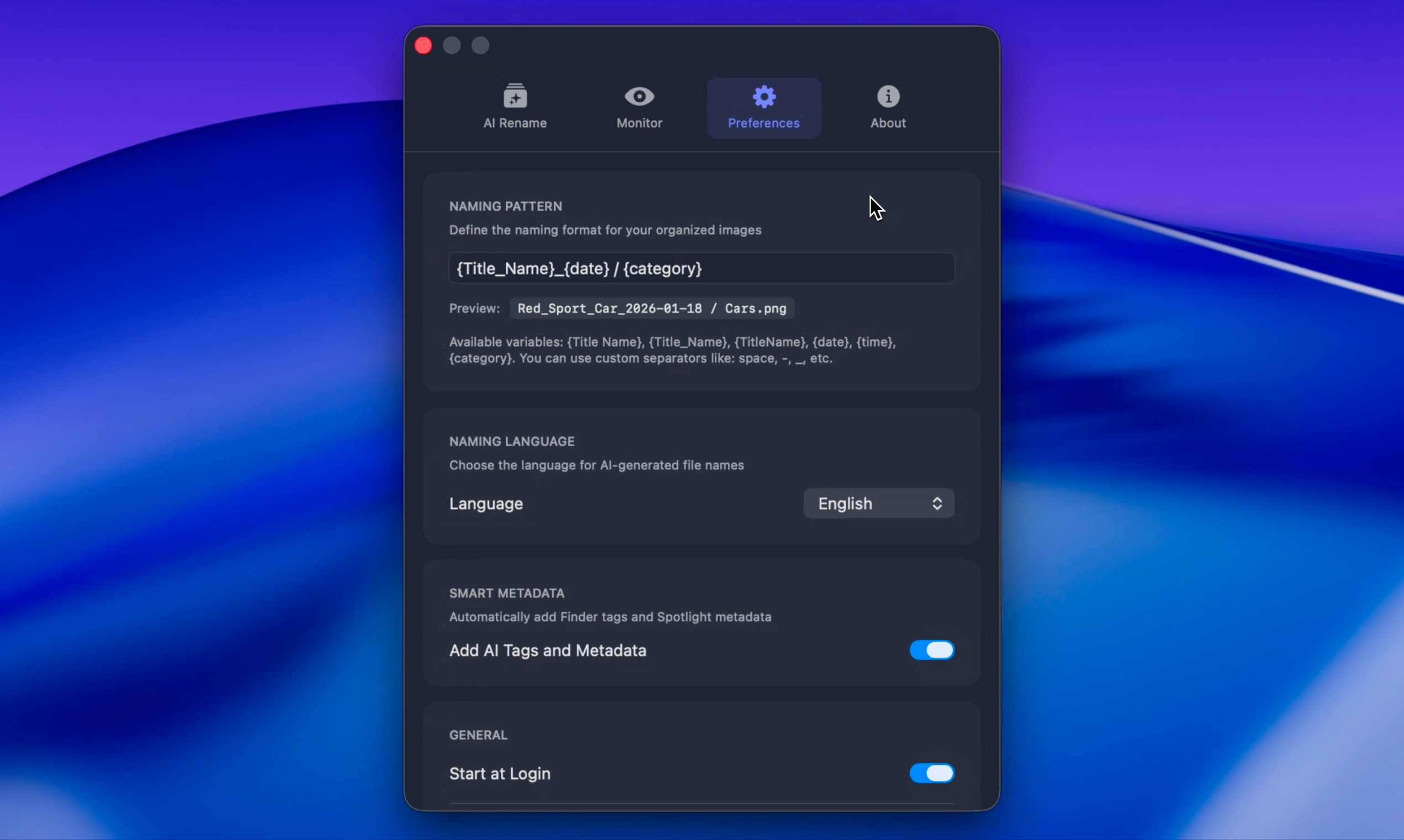

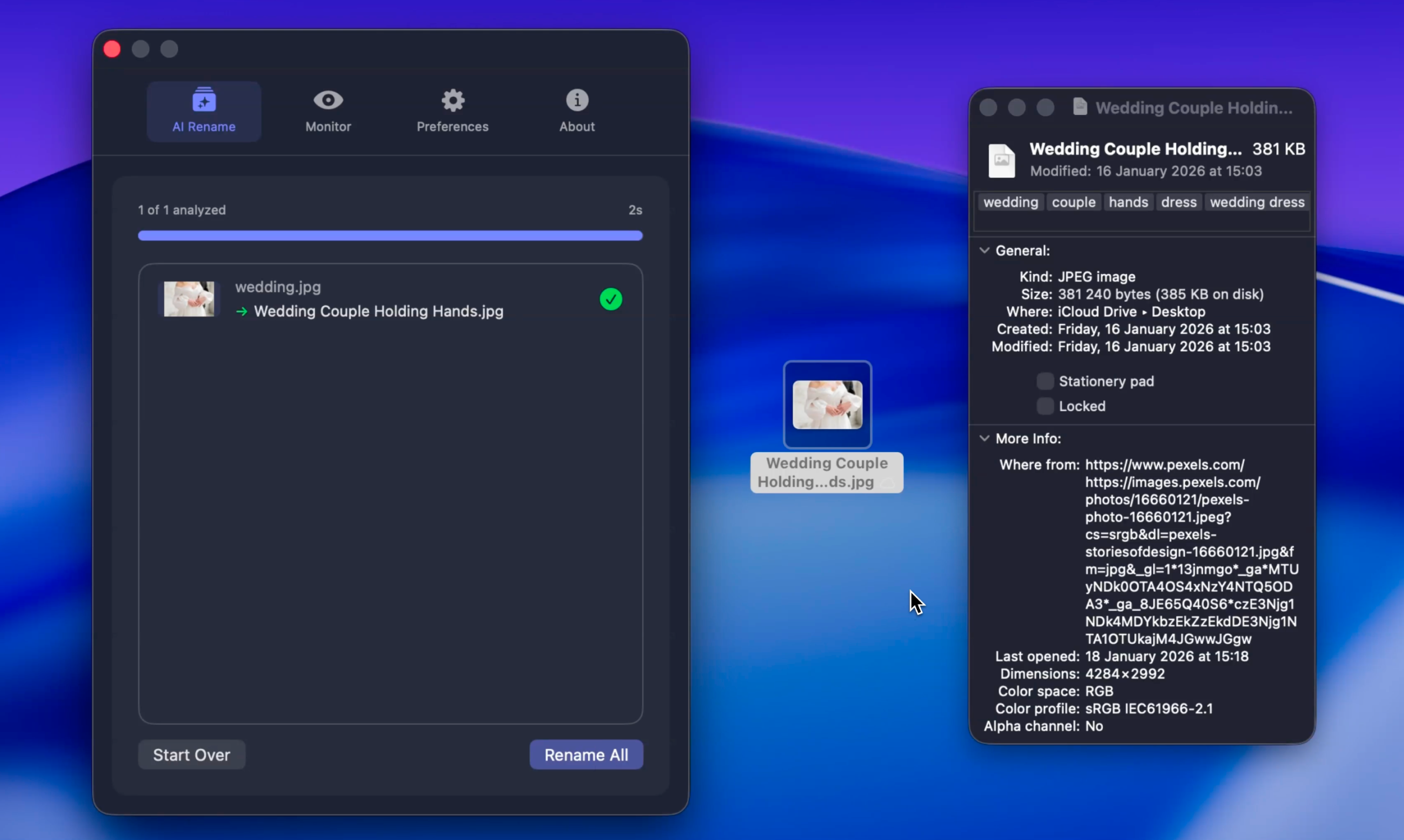

一句话介绍:一款macOS上的AI图片批量重命名与自动打标工具,通过本地AI分析文件内容,将“IMG_1234.jpg”等无意义文件名自动转换为描述性名称,解决了摄影师、设计师等创意工作者在海量图片文件中管理混乱、检索低效的核心痛点。

Productivity

Photography

Artificial Intelligence

生产力工具

AI文件管理

图片批量处理

自动重命名

自动打标

RAW文件支持

本地AI

macOS应用

创意工作者工具

文件整理

用户评论摘要:目前有效评论主要为开发者自述。开发者阐述了产品开发背景、在“本地AI与云端API”、“Tauri与原生Swift”之间的技术选型思考,并强调了速度优化的自豪感。提供了早期访问的优惠码,并主动邀请用户反馈和提出功能建议。

AI 锐评

Zush切入了一个看似微小却极其顽固的痛点:数字资产,尤其是图片文件的命名与管理混乱。其宣称的价值不在于简单的重命名,而在于通过AI理解内容,为无序数据赋予语义化结构,这本质上是将非结构化数据转换为半结构化数据的关键一步,直接提升了文件在Spotlight等系统级搜索中的可发现性。

产品思路清晰,定位精准。选择原生Swift开发换来14MB体积与“极速”体验,是明智的取舍,契合了目标用户(处理大量RAW文件的摄影师、设计师)对本地工具“轻快、可靠”的核心诉求。支持RAW格式更是直击专业用户痒点。自动监控文件夹的“自动驾驶”模式与批量处理模式,覆盖了从实时整理到历史归档的全场景。

然而,其真正的挑战与价值天花板隐藏在“本地AI”这个选择中。开发者提到为速度放弃云端API,这意味着其AI分析能力受限于本地模型的精度与广度。对于“Mountain_Lake_Sunset”这类通用场景或许游刃有余,但对于专业用户更复杂的细分场景(如特定设计风格、建筑结构、植物物种的识别),其描述准确性将面临考验。这可能导致重命名结果流于表面,无法满足深度分类需求。

此外,工具属性强也意味着用户粘性可能不足。它更像是一个“用了就关”的实用程序,而非一个持续打开的平台。其长期发展需思考如何从单次整理工具,演进为贯穿文件创建、管理、检索全流程的智能助手,或通过命名规则与标签体系,与Adobe Lightroom等专业生态建立更深层的协同。

总体而言,Zush是一款解决痛点明确的利基市场效率工具。其成功与否,短期看AI本地模型的实际表现与稳定性,长期看能否围绕“语义化文件管理”构建更深的护城河,而非停留在“更快的重命名工具”层面。在AI平民化的今天,它的出现是必然,但要想从“有用”到“不可或缺”,仍需在“理解”的深度上做更多文章。

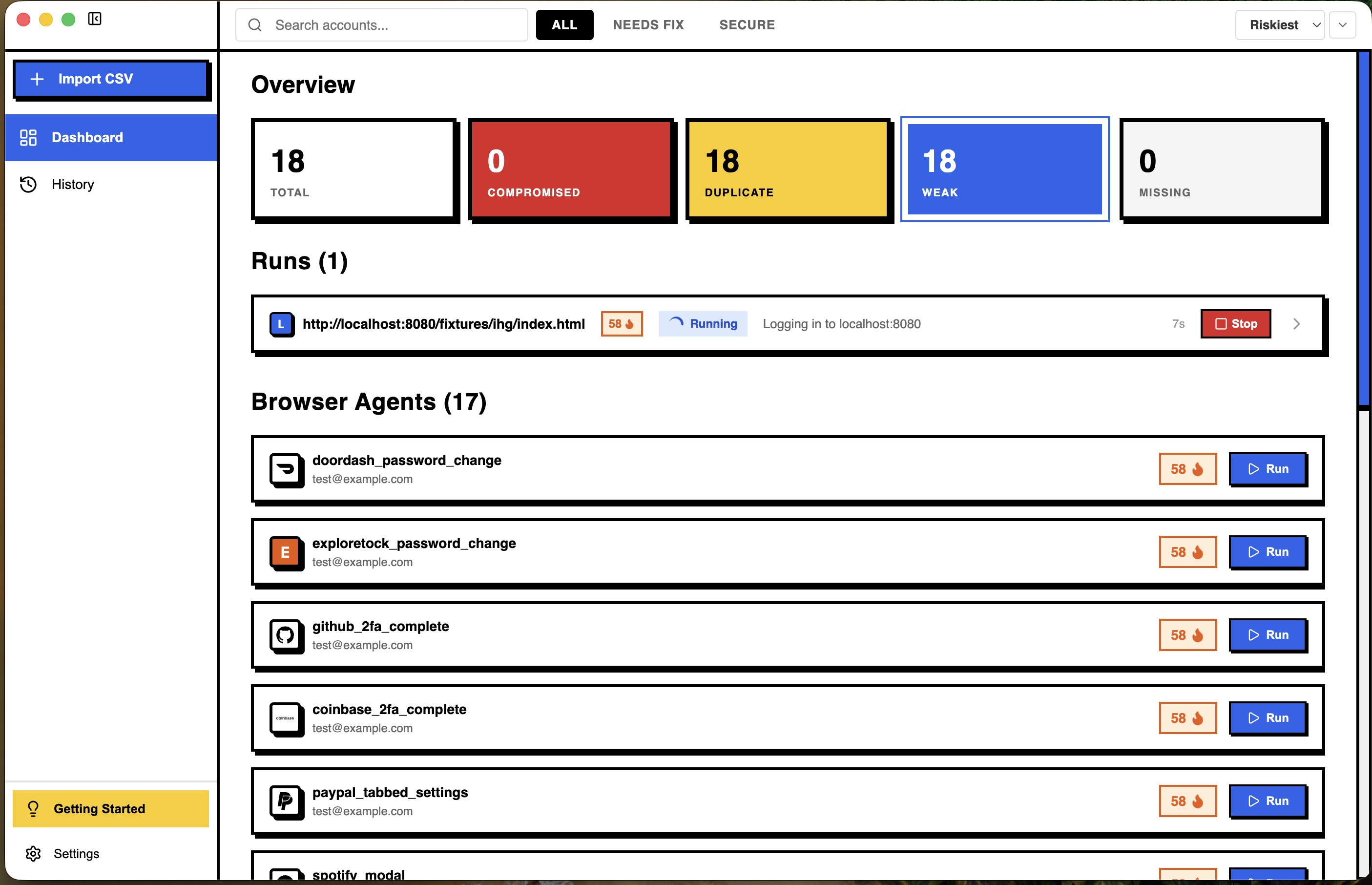

一句话介绍:一款本地AI代理工具,能在数据泄露后自动遍历网站并更换重复使用的密码,解决用户因操作繁琐而忽视密码更新的安全痛点。

Chrome Extensions

Privacy

Artificial Intelligence

Security

密码管理

本地AI代理

自动化安全

隐私保护

凭证填充防御

数据泄露响应

macOS应用

数字足迹管理

自主代理

安全工具

用户评论摘要:开发者自述产品源于个人遭遇数据泄露的痛点,强调其安全与隐私设计原则(数据不离本地、AI不接触敏感信息)。有用户认可团队解决普遍安全问题的能力。目前未见具体功能性质疑或建议。

AI 锐评

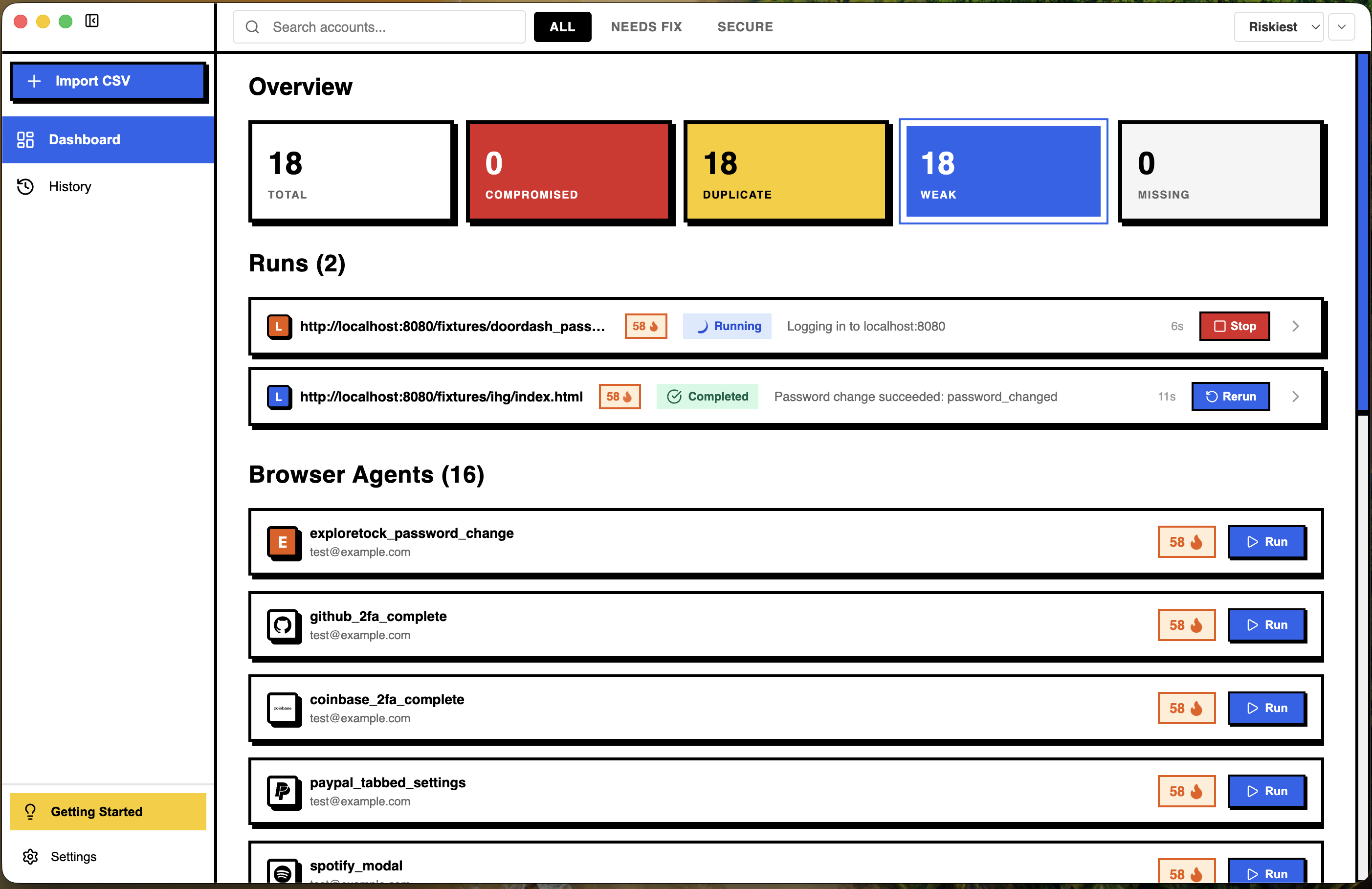

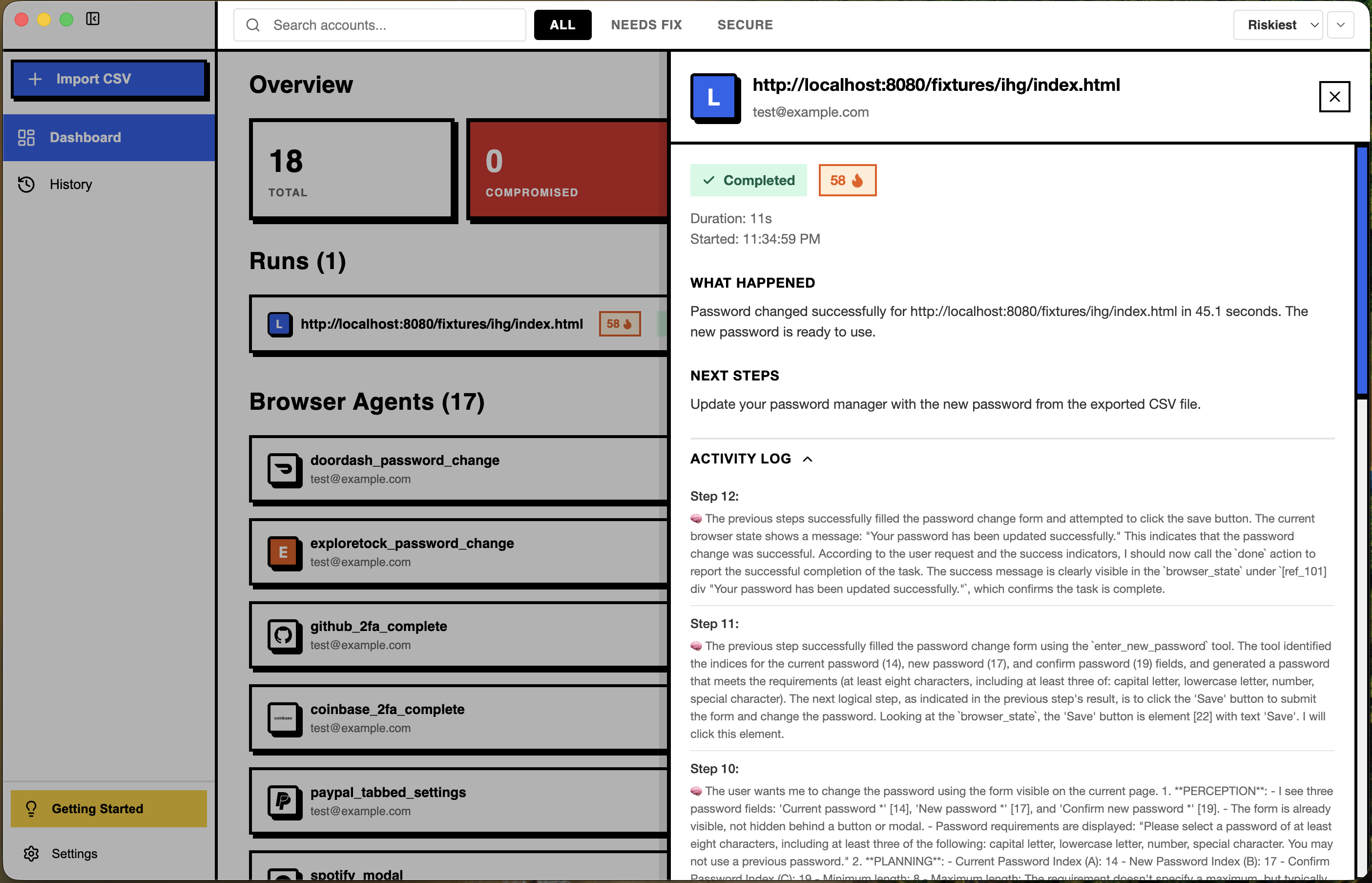

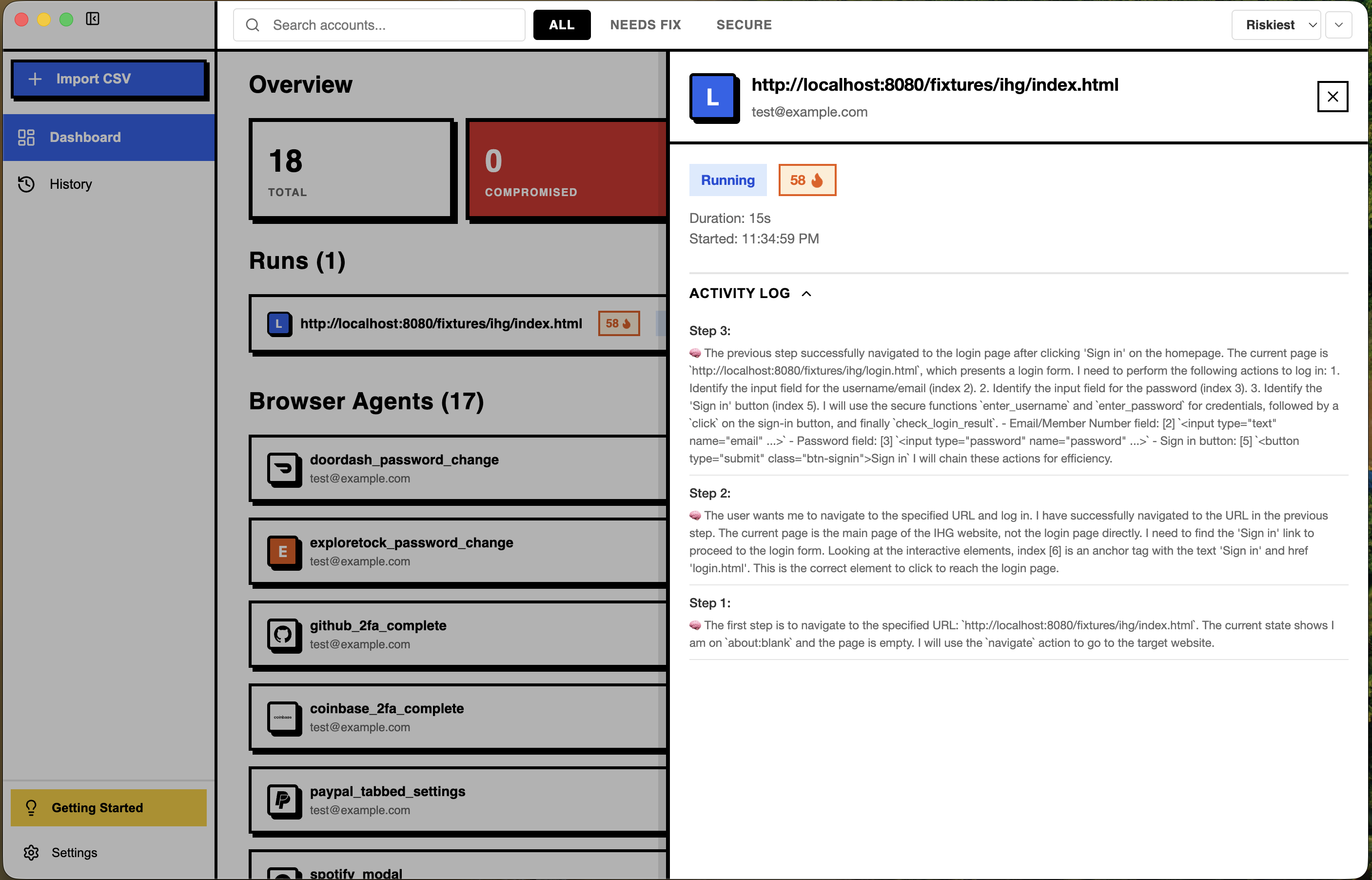

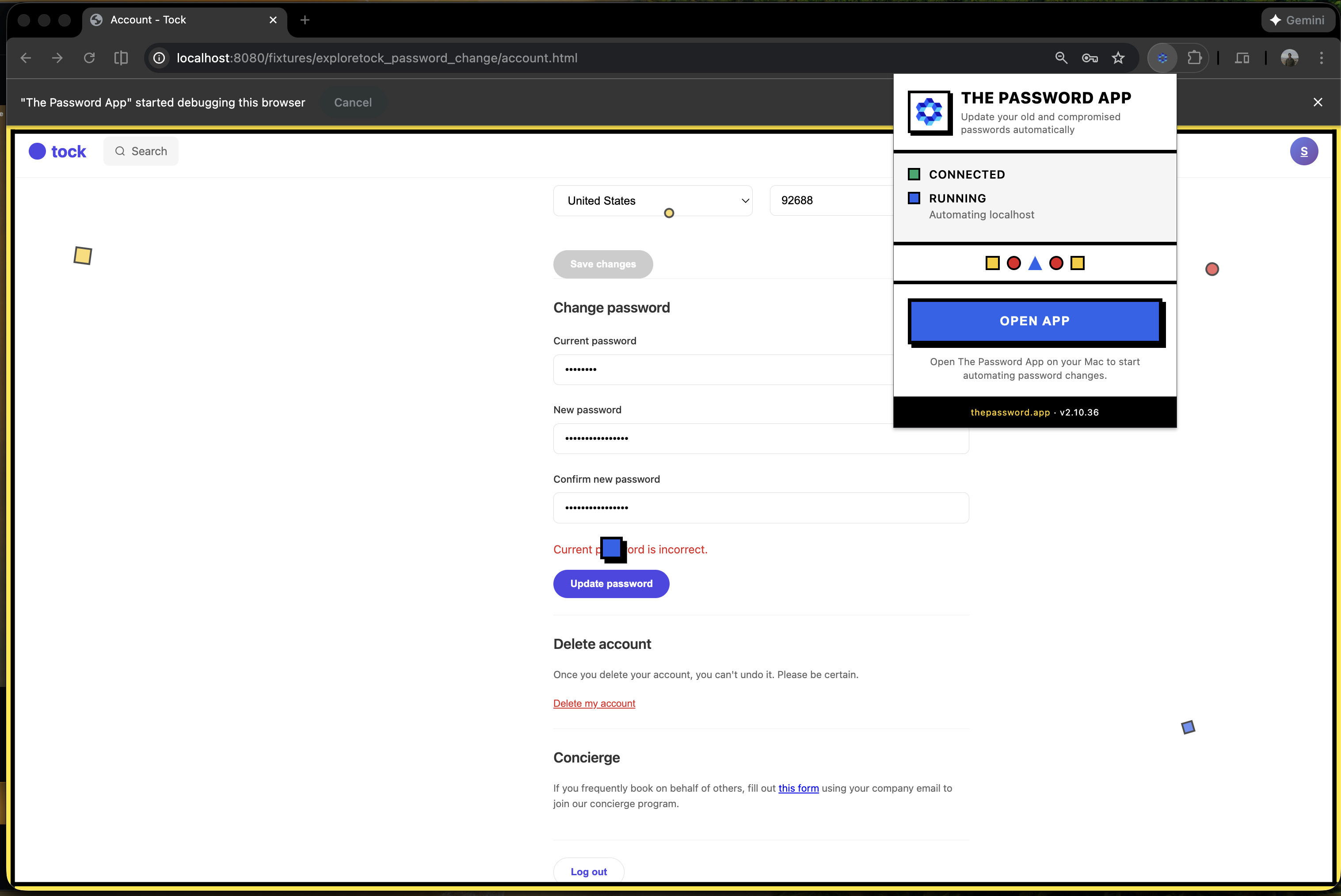

在“密码疲劳”与“撞库攻击”泛滥的时代,The Password App试图用本地AI自动化撬动一个行为死结:用户明知该改密码却因操作成本过高而拖延。其真正的颠覆性不在于技术复杂度(自动填充与脚本可部分实现),而在于将安全维护从“用户责任”转变为“代理服务”,试图用机器耐性对抗人类惰性。

然而,其价值面临三重拷问。首先,技术可靠性存疑:千差万别的网站界面与多因素认证流程,对AI的鲁棒性提出极高挑战,一次失败操作可能导致账户锁定。其次,商业模式与扩展性矛盾:强调“数据永不离开Mac”固然是隐私卖点,却限制了跨设备同步与实时威胁情报整合,这与其描绘的“全景数字足迹管理”愿景存在架构冲突。最后,安全哲学上的潜在风险:将核心安全凭证托付给本地AI代理,虽避开了云端风险,却将攻击面转移至本地模型可能遭受的提示注入或代理逻辑漏洞,其内置的“Guardian agent”防御效果有待实战检验。

产品真正的野心已显露在蓝图里——从密码轮换扩展到自动账户清理与数据删除请求。这指向了更深刻的命题:在个人数据主权意识觉醒的当下,能否用AI代理作为杠杆,将分散的、耗时的个人数据维权动作系统化、自动化?这条路充满监管与技术雷区,但若能在安全与体验间找到平衡点,或许能重新定义“个人网络安全基础设施”的形态。目前,它仍是一个针对苹果生态内技术乐观主义者的锋利实验。

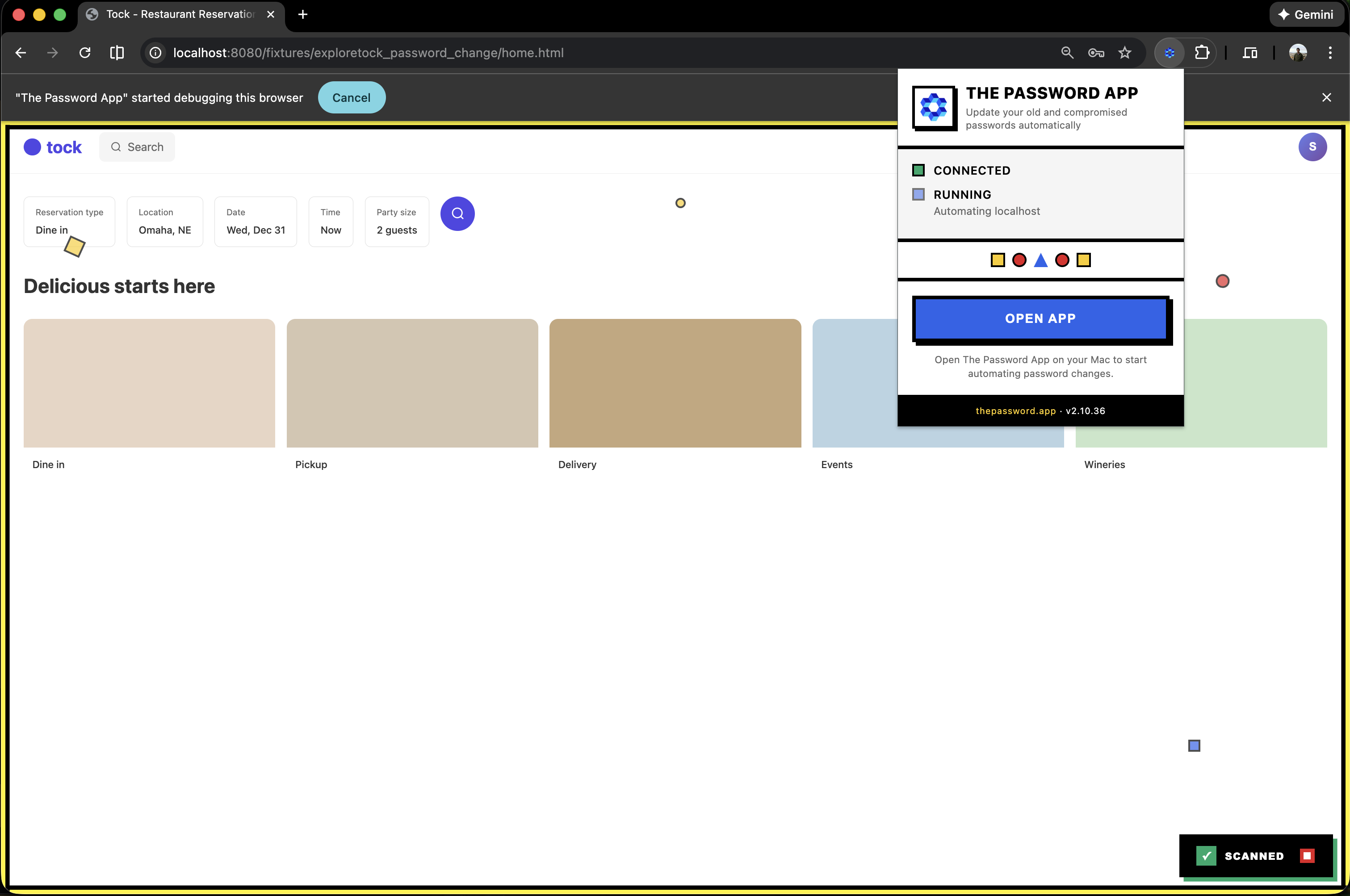

Hey Product Hunt! 👋

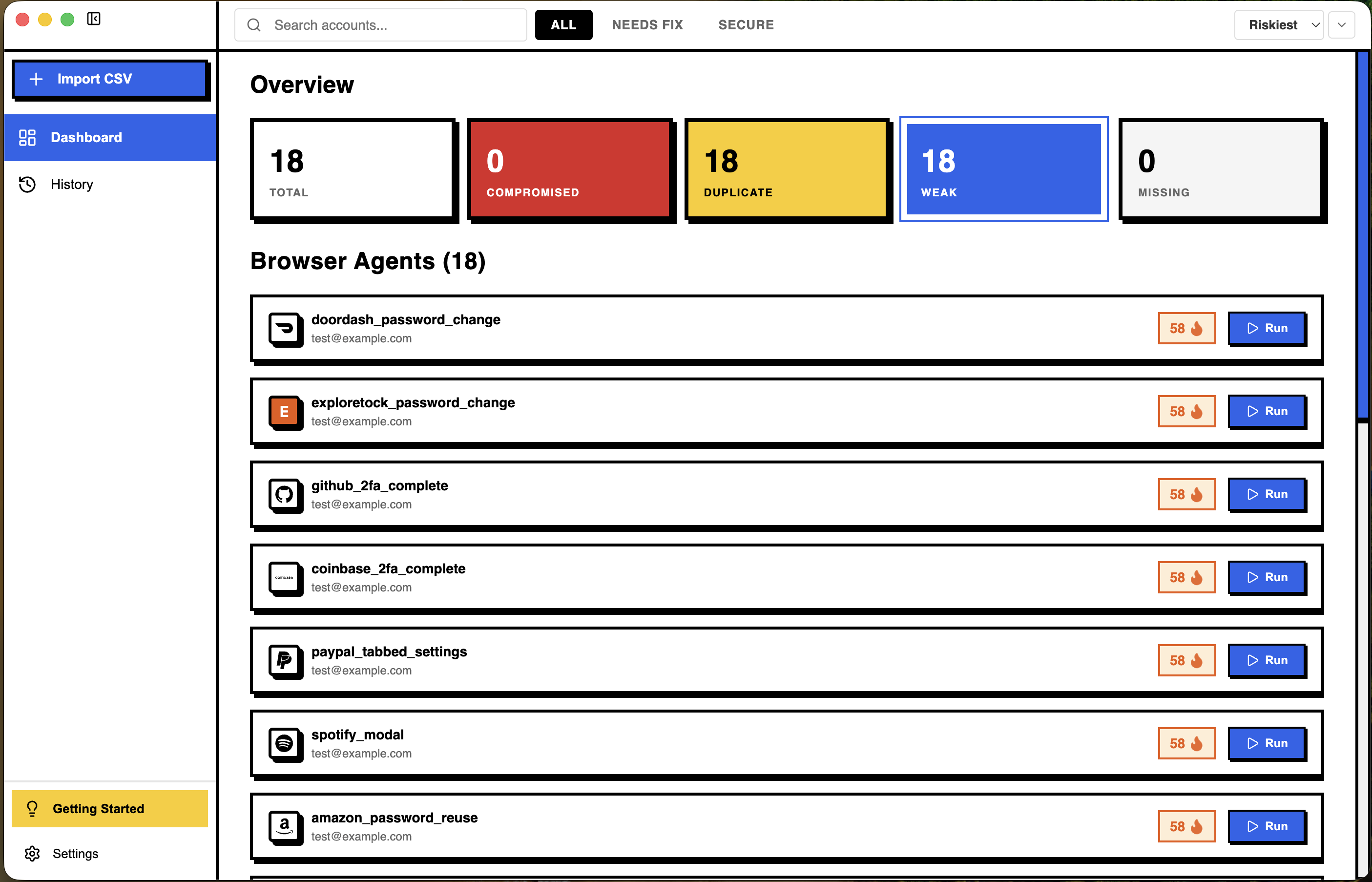

Brian, DevRel from Kilo here. We built @Kilo Code Code Reviewer to kill PR bottlenecks.

It runs automatically when you open a PR, catching security issues, performance problems, and style inconsistencies before your teammates even look at it, and offers comments and inline suggestions.

It's completely free with models like MiniMax M2.1 and GLM 4.7 - or use the latest from @Claude by Anthropic, @Gemini, or whatever you prefer from over 500 supported models.

What's your biggest code review pain point?

@Kilo Code Code Reviewer has become such a big part of my workflow. Can't imagine coding without it.

As a data engineer, I’ve been using Kilo Code reviewer and it’s surprisingly data aware, not just code aware. It helps me catch pipeline changes that would only break dashboards later

The amount of time this product helped me out is wild. I spin up PRs daily and let code reviewer take care of it before asking a human dev to do a final check.

had a blast working with the team on this new launch, introducing Kilo Code Reviewers -- AI-powered code reviews that understand your codebase and catch bugs before merging.

First launched on @Product Hunt about a year ago, @Kilo Code is now the most popular open-source coding agent, trusted by 1M+ developers.

S/O to @sytses @scobreit and team 👏👏

Reading this made me think about how often my PRs wait longer than expected. I usually spot small issues only after opening them. Getting early feedback would help me feel more confident before asking teammates to review.

Love the open source angle of Kilo Code and the transparent pricing model (you can bring your own AI models too). How it handles larger codebases with multiple modules and complex dependencies compared with other AI coding assistants like Copilot or Cursor?

I've been using KC for code reviews at Resume Matcher, and the experience has been amazing so far.

You can see it in action here: https://github.com/srbhr/Resume-Matcher/pull/638

I wanted to ask how this works with legacy codebases. My projects often have older patterns mixed with new ones.

The automation is interesting but I do worry about over dependency. My concern is whether developers might rely on it too much and miss deeper review thinking.

Reading this made me think about how long my pull requests usually sit waiting. I often wonder if small issues could be caught earlier. This feels like it could reduce that waiting stress for me.

This could be huge for junior devs on my team. They'd get feedback instantly instead of waiting for me to free up. Congrats, exciting to see this!

Wow, this is actually game-changing!

Gave it a first try today and its a very convenient feature. Certainly will continue using it.

This is wonderful. We've been using this Code Review mode since early testing and given tonnes of tips/feedback, love where it's at today!

If this reduces review back-and-forth even 30%, that’s already a win. Wishing you all the best :)

Very interesting product. Out of supported 500+ models, is there any recommended coding models list you guys suggest, as only few of them good in coding and review.

How does the AI understand our team’s specific coding standards and architectural decisions over time? (And can it learn from accepted vs. rejected suggestions?)

So much better than other code reviewers! Love that there are so many models available to power it

Congrats on the launch. OSS AI coding assistants are the future. What’s the one feature users fall in love with first?

This works as a Cloud Agent I presume.

awesome expansion of this product. Congrats to the team

pr bottlenecks are real , especially on small teams where everyone's busy building.

quick question: does it learn from previous reviews? like if i keep ignoring certain suggestions, does it adapt over time?

also how it handles false positives. nothing worse than an ai reviewer flagging stuff that's actually fine.

This looks super cool! I've been battling with CodeRabbit and it doesn't seem very helpful. We're a small team and we need something that's actionable. But CR seems to mainly give me fluff than actionable insights. I'm curious - how does Kilo compare to other similar products out there? Would be great to get some insight on that.

Does Kilo limit its analysis strictly to the diff / selected changes, or can it reason about a wider scope (files, modules, usage elsewhere) in a way that adapts to the size of the repository?

From my recent experiments with AI code reviewers, most of them either:

stay diff-only, or

try to scan “everything” and quickly become impractical on larger repos due to long processing times.

What I’m missing is something more adaptive — e.g. scope expansion that’s proportional to repo size or dependency graph, rather than a fixed “deep analysis” mode. Curious how Kilo handles this today, and whether repo-aware scoping is part of the design.

If you are a solo-founder or are vibe coding, having this code review gives you another check on the quality and security of your code. This is far better than skipping them and is faster & less expensive than hiring a fractional worker to do it.

It looks great! What new features you guys are planning to add on?

Congrats on the launch! Kilo Code has really outdone itself with planning and outlining complex tasks as well as bug fixing and error analysis. Will you develop a system for integration to make it more efficient for teams to setup & separate windows or workflows?

Hi everyone! Happy coding!,

I definitely recommend trying kilocode's new "review" mode feature.

It successfully reviewed my entire spaghetti code website initially generated with a free deepseek ai model that I was unaware of it's lack of html/css coding abilities.

It successfully referenced 12 out of 13 critical 🚨errors/⚠️warnings which saved me hours of debugging.

The only warning recommendation from kilocode's review mode I could do without is a warning: "oncentextmenu=return false;" "prevents right click menu".

I purposely turned off the right click context window for an image, but it's not a big deal at all.

Overall I rate the new review code mode a 9/10, would give a 10/10 but it just released today and I never experienced perfect software.

Enjoy the ai revolution in 2026 and thank you team Kilocode for the hard work I notice you guys put in! 💯